Spark示例——SparkPi出现ClassNotFound异常解决

Spark示例——SparkPi

在运行中出现ClassNotFound异常的问题解决

前言:按照《Spark实战高手之路-第1章》的前四节,搭建完Spark集群及IDEA 集成环境后,最后一步是用IDEA集成环境运行SparkPi例子。可就在这最后一步,让我花了三天时间才最终完成。所以,这里详细介绍解决方法,让接下来以《 Spark实战高手之路》入门的后来者少走些弯路。文中将大量引用网上的资源,在可能的情况下我会尽量标明出处,但不到之处还请原著作者见谅。

1.在《Spark实战高手之路-第1章(4)》的最后,说要以本地模式过行,则在 Edit Configurations->Program arguments中输入“local”就不会报错了,但事实是:加之前与加之后都报错,且错误相同。此次报错内容总共只有6行,主要内容是“A master URL must be …...”,大致意思是找不到master 的URL 路径。

解决方法:

找不到URL路径,要在代码中添加

x.setMaster("spark://192.168.18.211:7077").自行设置URL路径,其中,192.168.18.211 是我的Master电脑的IP地址,不同的集群根据自己的情况而定。这个方法在《Spark实战高手之路-第1章(5)》的最后也提到过,可能原文的本意是仅本地运行时填“local”,当要在集群上运行时要添加master的URL路径,但好像在本地运行不是很happy.好在重点不在本地运行,而在集群,所以就不管“local”了。下面看一下这一行代码集体插入的位置和方法:

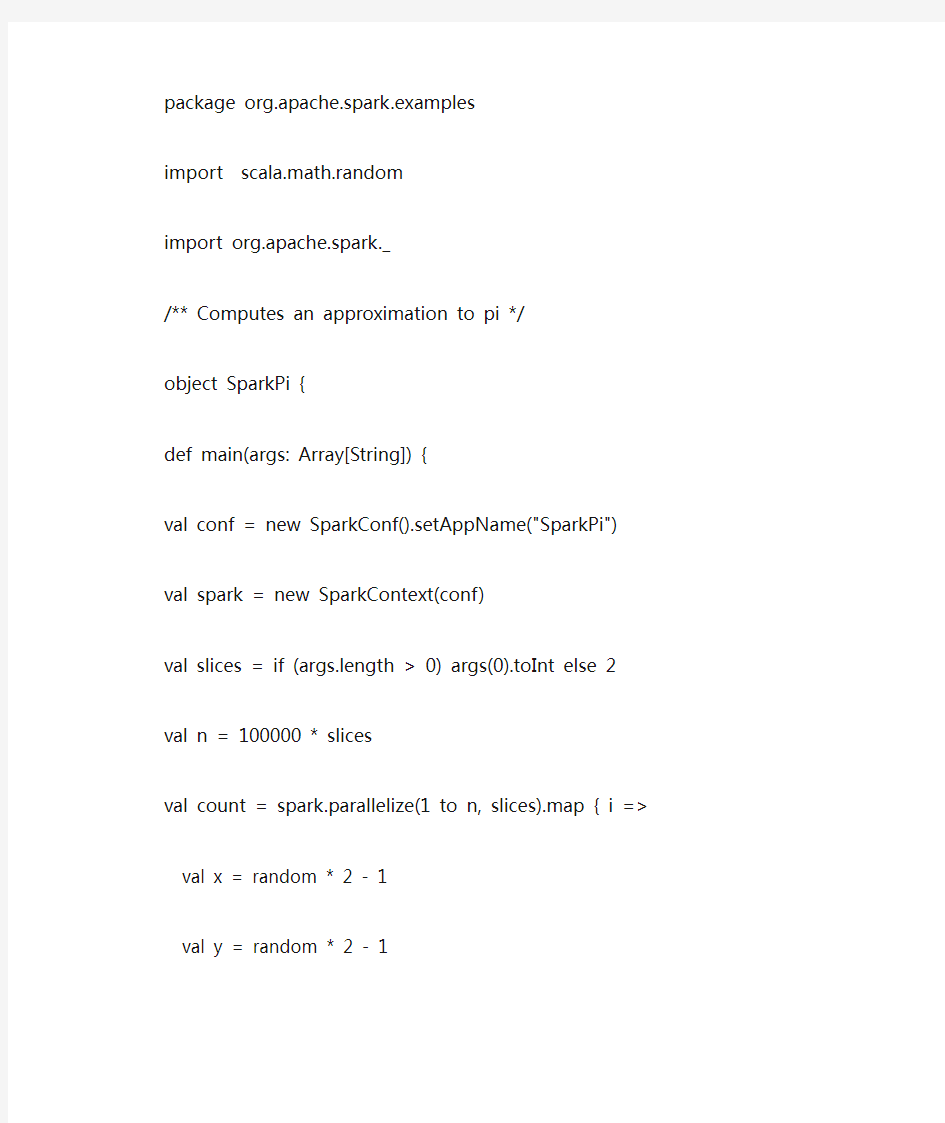

原代码:

package org.apache.spark.examples

import scala.math.random

import org.apache.spark._

/** Computes an approximation to pi */

object SparkPi {

def main(args: Array[String]) {

val conf = new SparkConf().setAppName("SparkPi")

val spark = new SparkContext(conf)

val slices = if (args.length > 0) args(0).toInt else 2

val n = 100000 * slices

val count = spark.parallelize(1 to n, slices).map { i =>

val x = random * 2 - 1

val y = random * 2 - 1

if (x*x + y*y < 1) 1 else 0

}.reduce(_ + _)

println("Pi is roughly " + 4.0 * count / n)

spark.stop()

}

}

添加后:

package org.apache.spark.examples

import scala.math.random

import org.apache.spark._

/** Computes an approximation to pi */

object SparkPi {

def main(args: Array[String]) {

val conf = new SparkConf().setAppName("SparkPi")

conf.setMaster("spark://192.168.18.211:7077")

val spark = new SparkContext(conf)

val slices = if (args.length > 0) args(0).toInt else 2

val n = 100000 * slices

val count = spark.parallelize(1 to n, slices).map { i =>

val x = random * 2 - 1

val y = random * 2 - 1

if (x*x + y*y < 1) 1 else 0

}.reduce(_ + _)

println("Pi is roughly " + 4.0 * count / n)

spark.stop()

}

}

到此,第一种异常(6行)就解决了。

2.在解决完第一种异常后运行,发现会出现新的异常,而且这次异常所用的行数远多于6行。主要内容为”https://www.sodocs.net/doc/af1037673.html,ng.ClassNotFoundException:”,意思应该是没有将jar包提交到spark的worker上面,导致运行的worker找不到被调用的类。

解决方法:

将要运行的程序达成jar包,然后调用JavaSparkContext的addJar方法将该jar包提交到spark集群中,然后spark的master会将该jar包分发到各个worker上面。

(本段内容参考了

https://www.sodocs.net/doc/af1037673.html,/forum.php?mod=viewthread&tid=322668

网站的内容。)

接下来我就偿试打jar包,再提交。先说一下提交的方法:

原代码:

package org.apache.spark.examples

import scala.math.random

import org.apache.spark._

/** Computes an approximation to pi */

object SparkPi {

def main(args: Array[String]) {

val conf = new SparkConf().setAppName("SparkPi") conf.setMaster("spark://192.168.18.211:7077")

val spark = new SparkContext(conf)

val slices = if (args.length > 0) args(0).toInt else 2 val n = 100000 * slices

val count = spark.parallelize(1 to n, slices).map { i => val x = random * 2 - 1

val y = random * 2 - 1

if (x*x + y*y < 1) 1 else 0

}.reduce(_ + _)

println("Pi is roughly " + 4.0 * count / n)

spark.stop()

}

}

添加后:

package org.apache.spark.examples

import scala.math.random

import org.apache.spark._

/** Computes an approximation to pi */

object SparkPi {

def main(args: Array[String]) {

val conf = new SparkConf().setAppName("SparkPi") conf.setMaster("spark://192.168.18.211:7077")

val spark = new SparkContext(conf)

spark.addJar("/root/s2.jar")

val slices = if (args.length > 0) args(0).toInt else 2 val n = 100000 * slices

val count = spark.parallelize(1 to n, slices).map { i => val x = random * 2 - 1

val y = random * 2 - 1

if (x*x + y*y < 1) 1 else 0

}.reduce(_ + _)

println("Pi is roughly " + 4.0 * count / n)

spark.stop()

}

}

其中 s2.jar 就是我们打的包。

下面聚体说下怎么打包:

起初我是在终端用命令行:jar cvf 自行打包,但是不对。正确的打包方法是这样的:

依次选择“File”–> “Project Structure”–> “Artifact”,选择“+”–> “Jar”–> “From Modules with dependencies”,选择main函数,并在弹出框中选择输出jar位置,并选择“OK”。

最后依次选择“Build”–> “Build Artifact”编译生成jar包。具体如下图所示。

转载自董的博客:

https://www.sodocs.net/doc/af1037673.html,/framework-on-yarn/apache-spark-intellij-idea/

这里打成的包还比较大,我打了三次,都是一百二三十兆。包打成后,可以将.jar 文件移到目录较浅的地方,方便代码的编写。

3.总结

要使Spark自带的示例能够在集群上运行,需要增加两行代码,一行用来指明master路径:conf.setMaster("spark://192.168.18.211:7077"),另一行用来把打好的jar 包发到集群上:spark.addJar("/root/s2.jar")。然后注意一下打包的方法,和生成包的大小。

最后,祝你成功!!

附:成功后的运行结果:

/usr/lib/java/jdk1.7.0_67/bin/java https://www.sodocs.net/doc/af1037673.html,uncher.port=7535

https://www.sodocs.net/doc/af1037673.html,uncher.bin.path=/usr/local/idea/idea-IC-135.1289/bin

-Dfile.encoding=UTF-8 -classpath

/usr/lib/java/jdk1.7.0_67/jre/lib/jce.jar:/usr/lib/java/jdk1.7.0_67/j re/lib/jfxrt.jar:/usr/lib/java/jdk1.7.0_67/jre/lib/deploy.jar:/usr/li b/java/jdk1.7.0_67/jre/lib/resources.jar:/usr/lib/java/jdk1.7.0_67/jr

e/lib/jsse.jar:/usr/lib/java/jdk1.7.0_67/jre/lib/jfr.jar:/usr/lib/jav a/jdk1.7.0_67/jre/lib/rt.jar:/usr/lib/java/jdk1.7.0_67/jre/lib/charse ts.jar:/usr/lib/java/jdk1.7.0_67/jre/lib/plugin.jar:/usr/lib/java/jdk 1.7.0_67/jre/lib/javaws.jar:/usr/lib/java/jdk1.7.0_67/jre/lib/managem ent-agent.jar:/usr/lib/java/jdk1.7.0_67/jre/lib/ext/sunpkcs11.jar:/us r/lib/java/jdk1.7.0_67/jre/lib/ext/sunec.jar:/usr/lib/java/jdk1.7.0_6 7/jre/lib/ext/zipfs.jar:/usr/lib/java/jdk1.7.0_67/jre/lib/ext/localed ata.jar:/usr/lib/java/jdk1.7.0_67/jre/lib/ext/dnsns.jar:/usr/lib/java /jdk1.7.0_67/jre/lib/ext/sunjce_provider.jar:/root/IdeaProjects/Hello Scala/target/scala-2.10/classes:/root/.sbt/boot/scala-2.10.4/lib/scal a-library.jar:/usr/local/spark/spark-1.1.0/lib/spark-assembly-1.1.0-h adoop1.0.4.jar:/usr/local/idea/idea-IC-135.1289/lib/idea_rt.jar com.intellij.rt.execution.application.AppMain SparkPi

Using Spark's default log4j profile:

org/apache/spark/log4j-defaults.properties

14/11/05 15:19:47 INFO SecurityManager: Changing view acls to: root, 14/11/05 15:19:47 INFO SecurityManager: Changing modify acls to: root, 14/11/05 15:19:47 INFO SecurityManager: SecurityManager: authentication disabled; ui acls disabled; users with view permissions: Set(root, ); users with modify permissions: Set(root, )

14/11/05 15:19:47 INFO Slf4jLogger: Slf4jLogger started

14/11/05 15:19:47 INFO Remoting: Starting remoting

14/11/05 15:19:47 INFO Remoting: Remoting started; listening on addresses :[akka.tcp://sparkDriver@Master:60777]

14/11/05 15:19:47 INFO Remoting: Remoting now listens on addresses: [akka.tcp://sparkDriver@Master:60777]

14/11/05 15:19:47 INFO Utils: Successfully started service 'sparkDriver' on port 60777.

14/11/05 15:19:47 INFO SparkEnv: Registering MapOutputTracker

14/11/05 15:19:47 INFO SparkEnv: Registering BlockManagerMaster

14/11/05 15:19:47 INFO DiskBlockManager: Created local directory at /tmp/spark-local-20141105151947-2b9c

14/11/05 15:19:47 INFO Utils: Successfully started service 'Connection manager for block manager' on port 50031.

14/11/05 15:19:47 INFO ConnectionManager: Bound socket to port 50031 with id = ConnectionManagerId(Master,50031)

14/11/05 15:19:47 INFO MemoryStore: MemoryStore started with capacity 491.5 MB

14/11/05 15:19:47 INFO BlockManagerMaster: Trying to register BlockManager

14/11/05 15:19:47 INFO BlockManagerMasterActor: Registering block manager Master:50031 with 491.5 MB RAM

14/11/05 15:19:47 INFO BlockManagerMaster: Registered BlockManager

14/11/05 15:19:47 INFO HttpFileServer: HTTP File server directory is /tmp/spark-b5af6f99-7900-4de7-8379-89650b305b36

14/11/05 15:19:47 INFO HttpServer: Starting HTTP Server

14/11/05 15:19:48 INFO Utils: Successfully started service 'HTTP file server' on port 52570.

14/11/05 15:19:53 INFO Utils: Successfully started service 'SparkUI' on port 4040.

14/11/05 15:19:53 INFO SparkUI: Started SparkUI at http://Master:4040 14/11/05 15:19:53 INFO AppClient$ClientActor: Connecting to master spark://192.168.18.211:7077...

14/11/05 15:19:53 INFO SparkDeploySchedulerBackend: SchedulerBackend is ready for scheduling beginning after reached minRegisteredResourcesRatio: 0.0

14/11/05 15:19:54 INFO SparkDeploySchedulerBackend: Connected to Spark cluster with app ID app-20141105151954-0008

14/11/05 15:19:54 INFO AppClient$ClientActor: Executor added:

app-20141105151954-0008/0 on worker-20141105124522-Master-53897 (Master:53897) with 8 cores

14/11/05 15:19:54 INFO SparkDeploySchedulerBackend: Granted executor ID app-20141105151954-0008/0 on hostPort Master:53897 with 8 cores, 512.0 MB RAM

14/11/05 15:19:54 INFO AppClient$ClientActor: Executor added:

app-20141105151954-0008/1 on worker-20141104234523-Slave1-49080 (Slave1:49080) with 2 cores

14/11/05 15:19:54 INFO SparkDeploySchedulerBackend: Granted executor ID app-20141105151954-0008/1 on hostPort Slave1:49080 with 2 cores, 512.0 MB RAM

14/11/05 15:19:54 INFO AppClient$ClientActor: Executor added:

app-20141105151954-0008/2 on worker-20141105124523-Slave2-46320 (Slave2:46320) with 2 cores

14/11/05 15:19:54 INFO SparkDeploySchedulerBackend: Granted executor ID app-20141105151954-0008/2 on hostPort Slave2:46320 with 2 cores, 512.0 MB RAM

14/11/05 15:19:54 INFO AppClient$ClientActor: Executor updated:

app-20141105151954-0008/1 is now RUNNING

14/11/05 15:19:54 INFO AppClient$ClientActor: Executor updated:

app-20141105151954-0008/0 is now RUNNING

14/11/05 15:19:54 INFO AppClient$ClientActor: Executor updated:

app-20141105151954-0008/2 is now RUNNING

14/11/05 15:19:56 INFO SparkDeploySchedulerBackend: Registered executor: Actor[akka.tcp://sparkExecutor@Slave1:38597/user/Executor#-463599812] with ID 1

14/11/05 15:19:56 INFO SparkDeploySchedulerBackend: Registered executor: Actor[akka.tcp://sparkExecutor@Slave2:34634/user/Executor#-1528704844] with ID 2

14/11/05 15:19:56 INFO BlockManagerMasterActor: Registering block manager Slave1:33325 with 265.1 MB RAM

14/11/05 15:19:56 INFO BlockManagerMasterActor: Registering block manager Slave2:57790 with 265.1 MB RAM

14/11/05 15:19:57 INFO SparkDeploySchedulerBackend: Registered executor: Actor[akka.tcp://sparkExecutor@Master:51501/user/Executor#454736183] with ID 0

14/11/05 15:19:57 INFO BlockManagerMasterActor: Registering block manager Master:51783 with 265.1 MB RAM

14/11/05 15:20:39 INFO SparkContext: Added JAR

/root/IdeaProjects/HelloScala/out/artifacts/helloscala_jar/helloscala .jar at http://192.168.18.211:52570/jars/helloscala.jar with timestamp 1415172039923

14/11/05 15:20:40 INFO SparkContext: Starting job: reduce at

SparkPi.scala:27

14/11/05 15:20:40 INFO DAGScheduler: Got job 0 (reduce at

SparkPi.scala:27) with 2 output partitions (allowLocal=false)

14/11/05 15:20:40 INFO DAGScheduler: Final stage: Stage 0(reduce at SparkPi.scala:27)

14/11/05 15:20:40 INFO DAGScheduler: Parents of final stage: List()

14/11/05 15:20:40 INFO DAGScheduler: Missing parents: List()

14/11/05 15:20:40 INFO DAGScheduler: Submitting Stage 0 (MappedRDD[1] at map at SparkPi.scala:23), which has no missing parents

14/11/05 15:20:40 WARN SizeEstimator: Failed to check whether UseCompressedOops is set; assuming yes

14/11/05 15:20:40 INFO MemoryStore: ensureFreeSpace(1680) called with curMem=0, maxMem=515411804

14/11/05 15:20:40 INFO MemoryStore: Block broadcast_0 stored as values in memory (estimated size 1680.0 B, free 491.5 MB)

14/11/05 15:20:40 INFO MemoryStore: ensureFreeSpace(1114) called with curMem=1680, maxMem=515411804

14/11/05 15:20:40 INFO MemoryStore: Block broadcast_0_piece0 stored as bytes in memory (estimated size 1114.0 B, free 491.5 MB)

14/11/05 15:20:40 INFO BlockManagerInfo: Added broadcast_0_piece0 in memory on Master:50031 (size: 1114.0 B, free: 491.5 MB)

14/11/05 15:20:40 INFO BlockManagerMaster: Updated info of block broadcast_0_piece0

14/11/05 15:20:40 INFO DAGScheduler: Submitting 2 missing tasks from Stage 0 (MappedRDD[1] at map at SparkPi.scala:23)

14/11/05 15:20:40 INFO TaskSchedulerImpl: Adding task set 0.0 with 2 tasks

14/11/05 15:20:40 INFO TaskSetManager: Starting task 0.0 in stage 0.0 (TID 0, Slave2, PROCESS_LOCAL, 1209 bytes)

14/11/05 15:20:40 INFO TaskSetManager: Starting task 1.0 in stage 0.0 (TID 1, Slave1, PROCESS_LOCAL, 1209 bytes)

14/11/05 15:21:01 INFO ConnectionManager: Accepted connection from [Slave1/192.168.30.194:49874]

14/11/05 15:21:01 INFO SendingConnection: Initiating connection to [Slave1/192.168.30.194:33325]

14/11/05 15:21:01 INFO SendingConnection: Connected to

[Slave1/192.168.30.194:33325], 1 messages pending

14/11/05 15:21:01 INFO BlockManagerInfo: Added broadcast_0_piece0 in memory on Slave1:33325 (size: 1114.0 B, free: 265.1 MB)

14/11/05 15:21:01 INFO TaskSetManager: Finished task 1.0 in stage 0.0 (TID 1) in 21559 ms on Slave1 (1/2)

14/11/05 15:21:03 INFO BlockManagerInfo: Added broadcast_0_piece0 in memory on Slave2:57790 (size: 1114.0 B, free: 265.1 MB)

14/11/05 15:21:03 INFO TaskSetManager: Finished task 0.0 in stage 0.0 (TID 0) in 22924 ms on Slave2 (2/2)

14/11/05 15:21:03 INFO DAGScheduler: Stage 0 (reduce at SparkPi.scala:27) finished in 22.926 s

14/11/05 15:21:03 INFO TaskSchedulerImpl: Removed TaskSet 0.0, whose tasks have all completed, from pool

14/11/05 15:21:03 INFO SparkContext: Job finished: reduce at SparkPi.scala:27, took 23.224325592 s

Pi is roughly 3.14668

14/11/05 15:21:03 INFO SparkUI: Stopped Spark web UI at

http://Master:4040

14/11/05 15:21:03 INFO DAGScheduler: Stopping DAGScheduler

14/11/05 15:21:03 INFO SparkDeploySchedulerBackend: Shutting down all executors

14/11/05 15:21:03 INFO SparkDeploySchedulerBackend: Asking each executor to shut down

14/11/05 15:21:03 INFO ConnectionManager: Removing SendingConnection to ConnectionManagerId(Slave1,33325)

14/11/05 15:21:03 INFO ConnectionManager: Removing ReceivingConnection to ConnectionManagerId(Slave1,33325)

14/11/05 15:21:03 ERROR ConnectionManager: Corresponding SendingConnection to ConnectionManagerId(Slave1,33325) not found

14/11/05 15:21:04 INFO MapOutputTrackerMasterActor: MapOutputTrackerActor stopped!

14/11/05 15:21:04 INFO ConnectionManager: Selector thread was interrupted!

14/11/05 15:21:04 INFO ConnectionManager: ConnectionManager stopped 14/11/05 15:21:04 INFO MemoryStore: MemoryStore cleared

14/11/05 15:21:04 INFO BlockManager: BlockManager stopped

14/11/05 15:21:04 INFO BlockManagerMaster: BlockManagerMaster stopped 14/11/05 15:21:04 INFO SparkContext: Successfully stopped SparkContext 14/11/05 15:21:04 INFO RemoteActorRefProvider$RemotingTerminator: Shutting down remote daemon.

14/11/05 15:21:04 INFO RemoteActorRefProvider$RemotingTerminator: Remote daemon shut down; proceeding with flushing remote transports.

Process finished with exit code 0

(生产管理知识)制剂生产过程中常见问题和处理方法

制剂生产过程中常见问题和处理方法 一、质量问题 制剂生产过程由于种种原因造成制剂的质量不合格,尤其是在片剂生产中,造成片剂质量问题的因素更多。现仅对片剂、胶囊剂及注射剂生产中可能产生质量问题的原因及解决方法作介绍。 (一)片剂生产过程中可能发生问题的分析及解决方法 1.松片 片剂压成后,硬度不够,表面有麻孔,用手指轻轻加压即碎裂,原因分析及解决方法: ①药物粉碎细度不够、纤维性或富有弹性药物或油类成分含量较多而混合不均匀。可将药物粉碎过100目筛、选用黏性较强的黏合剂、适当增加压片机的压力、增加油类药物吸收剂充分混匀等方法加以克服。 ②黏合剂或润湿剂用量不足或选择不当,使颗粒质地疏松或颗粒粗细分布不匀,粗粒与细粒分层。可选用适当黏合剂或增加用量、改进制粒工艺、多搅拌软材、混均颗粒等方法加以克服。 ③颗粒含水量太少,过分干燥的颗粒具有较大的弹性、含有结晶水的药物在颗粒干燥过程中失去较多的结晶水,使颗粒松脆,容易松裂片。故在制粒时,按不同品种应控制颗粒的含水量。如制成的颗粒太干时,可喷入适量稀乙醇(50%—60%),混匀后压片。 ④药物本身的性质。密度大压出的片剂虽有一定的硬度,但经不起碰撞和震摇。如次硝酸铋片、苏打片等往往易产生松片现象;密

度小,流动性差,可压性差,重新制粒。 ⑤颗粒的流动性差,填入模孔的颗粒不均匀。 ⑥有较大块或颗粒、碎片堵塞刮粒器及下料口,影响填充量。 ⑦压片机械的因素。压力过小,多冲压片机冲头长短不齐,车速过快或加料斗中颗粒时多时少。可调节压力、检查冲模是否配套完整、调整车速、勤加颗粒使料斗内保持一定的存量等方法克服。 2.裂片 片剂受到震动或经放置时,有从腰间裂开的称为腰裂;从顶部裂开的称为顶裂,腰裂和顶裂总称为裂片,原因分析及解决方法: ①药物本身弹性较强、纤维性药物或因含油类成分较多。可加入糖粉以减少纤维弹性,加强黏合作用或增加油类药物的吸收剂,充分混匀后压片。 ②黏合剂或润湿剂不当或用量不够,颗粒在压片时粘着力差。 ③颗粒太干、含结晶水药物失去过多造成裂片,解决方法与松片相同。 ④有些结晶型药物,未经过充分的粉碎。可将此类药物充分粉碎后制粒。 ⑤细粉过多、润滑剂过量引起的裂片,粉末中部分空气不能及时逸出而被压在片剂内,当解除压力后,片剂内部空气膨胀造成裂片,可筛去部分细粉与适当减少润滑剂用量加以克服。 ⑥压片机压力过大,反弹力大而裂片;车速过快或冲模不符合要求,冲头有长短,中部磨损,其中部大于上下部或冲头向内卷边,

制剂生产过程中常见问题和处理方法

生产过程中常见问题和处理方法 一、质量问题 制剂生产过程由于种种原因造成制剂的质量不合格,尤其是在片剂生产中,造成片剂质量问题的因素更多。现仅对片剂、胶囊剂及注射剂生产中可能产生质量问题的原因及解决方法作介绍。 (一)片剂生产过程中可能发生问题的分析及解决方法 1.松片 片剂压成后,硬度不够,表面有麻孔,用手指轻轻加压即碎裂,原因分析及解决方法: ①药物粉碎细度不够、纤维性或富有弹性药物或油类成分含量较多而混合不均匀。可将药物粉碎过100目筛、选用黏性较强的黏合剂、适当增加压片机的压力、增加油类药物吸收剂充分混匀等方法加以克服。 ②黏合剂或润湿剂用量不足或选择不当,使颗粒质地疏松或颗粒粗细分布不匀,粗粒与细粒分层。可选用适当黏合剂或增加用量、改进制粒工艺、多搅拌软材、混均颗粒等方法加以克服。 ; ③颗粒含水量太少,过分干燥的颗粒具有较大的弹性、含有结晶水的药物在颗粒干燥过程中失去较多的结晶水,使颗粒松脆,容易松裂片。故在制粒时,按不同品种应控制颗粒的含水量。如制成的颗粒太干时,可喷入适量稀乙醇(50%—60%),混匀后压片。 ④药物本身的性质。密度大压出的片剂虽有一定的硬度,但经不起碰撞和震摇。如次硝酸铋片、苏打片等往往易产生松片现象;密度小,流动性差,可压性差,重新制粒。 ⑤颗粒的流动性差,填入模孔的颗粒不均匀。 ⑥有较大块或颗粒、碎片堵塞刮粒器及下料口,影响填充量。 ⑦压片机械的因素。压力过小,多冲压片机冲头长短不齐,车速过快或加料斗中颗粒时多时少。可调节压力、检查冲模是否配套完整、调整车速、勤加颗粒使料斗内保持一定的存量等方法克服。 2.裂片 片剂受到震动或经放置时,有从腰间裂开的称为腰裂;从顶部裂开的称为顶裂,腰裂和顶裂总称为裂片,原因分析及解决方法: ①药物本身弹性较强、纤维性药物或因含油类成分较多。可加入糖粉以减少纤维弹性,加强黏合作用或增加油类药物的吸收剂,充分混匀后压片。 \ ②黏合剂或润湿剂不当或用量不够,颗粒在压片时粘着力差。 ③颗粒太干、含结晶水药物失去过多造成裂片,解决方法与松片相同。 ④有些结晶型药物,未经过充分的粉碎。可将此类药物充分粉碎后制粒。 ⑤细粉过多、润滑剂过量引起的裂片,粉末中部分空气不能及时逸出而被压在片剂内,当解除压力后,片剂内部空气膨胀造成裂片,可筛去部分细粉与适当减少润滑剂用量加以克服。 ⑥压片机压力过大,反弹力大而裂片;车速过快或冲模不符合要求,冲头有长短,中部磨损,其中部大于上下部或冲头向内卷边,均可使片剂顶出时造成裂片。可调节压力与车速,改进冲模配套,及时检查调换。 ⑦压片室室温低、湿度低,易造成裂片,特别是黏性差的药物容易产生。调节空调系统可以解决。 3.粘冲与吊冲

基于大数据的能力开放平台解决方案精编版

基于大数据的能力开放平台解决方案 1 摘要 关键字:大数据经分统一调度能力开放 运营商经过多年的系统建设和演进,内部系统间存在一些壁垒,通过在运营商的各个内部系统,如经分、VGOP、大数据平台、集团集市等中构建基于ESB 的能力开放平台,解决了系统间调度、封闭式开发、数据孤岛等系统问题,使得运营商营销能力和效率大大提高。 2 问题分析 2.1 背景分析 随着市场发展,传统的开发模式已经无法满足业务开发敏捷性的要求。2014 年以来,某省运营商经营分析需求量激增,开发时限要求缩短,业务迭代优化需求频繁,原有的“工单-开发”模式平均开发周期为4.5 天,支撑负荷已达到极限。能力开放使业务人员可以更便捷的接触和使用到数据,释放业务部门的开发能力。 由于历史原因,业务支撑系统存在经分、VGOP、大数据平台、集团集市等多套独立的运维系统,缺乏统一的运维管理,造成系统与系统之间的数据交付复杂,无法最大化 的利用系统资源。统一调度的出现能够充分整合现有调度系统,减少运维工作量,提升维护质量。 驱动力一:程序调度管理混乱,系统资源使用不充分

经分、大数据平台、VGOP、集团集市平台各自拥有独立的调度管理,平台内程序基本是串行执行,以经分日处理为例,每日运行时间为20 个 小时,已经严重影响到了指标的汇总展示。 驱动力二:传统开发模式响应慢,不能满足敏捷开发需求 大数据平台已成为一个数据宝库,已有趋势表明,只依赖集成商与业 务支撑人员的传统开发模式已经无法快速响应业务部门需求,提升数据价值。 驱动力三:大数据平台丰富了经分的数据源,业务部门急待数据开放 某省运营商建立了面向企业内部所有部门的大数据平台,大数据平台 整合了接入B域、O 域、互联网域数据,近100 余个数据接口,共计820T 的数据逐步投入生产。大数据平台增强了传统经分的数据处理的能力,成为公司重要的资产,但是传统经分数据仓库的用户主要面向业支内部人员,限制了数据的使用人员范围和数据的使用频度,已经无法满足公司日益发展的业务需求,数据的开放迫在眉睫。 2.2 问题详解 基于背景情况分析,我们认为主要问题有三个: 1、缺乏统一的调度管理,维护效率低下 目前经分系统的日处理一般是使用SHELL 脚本开发的,按照串行调度的思路执行。进行能力开放后,目前的系统架构无法满足开发者提交的大量程序执行调度的运维需求。如果采用统一调度的设计思路则基于任务的数据表依赖进行任务解耦及调度,将大大简化调度配置工作和提高系统的

片剂裂片、松片解决办法

片剂生产松片、裂片、粘冲与吊冲、片重差异超限的原因 及解决方案 在药品生产的一线,常常会遇到各种各样的小问题,而就是这些细节,往往能影响产品的质量水准。本文从实际经验出发,对于片剂 生产中出现的“病症”给与诊断分析,并给出了详实“处方”。希 望能给一线生产人员提供一定的帮助。 1:病症:松片,即片剂压成后,硬度不够,表面有麻孔,用手指轻 轻加压即碎裂。 处方: ①药物粉碎细度不够、纤维性或富有弹性药物或油类成分含量较多 而混合不均匀。可将药物粉碎过100目筛、选用黏性较强的黏合剂、适当增加压片机的压力、增加油类药物吸收剂充分混匀等方法加以 克服。 ②黏合剂或润湿剂用量不足或选择不当,使颗粒质地疏松或颗粒粗 细分布不匀,粗粒与细粒分层。可选用适当黏合剂或增加用量、改 进制粒工艺、多搅拌软材、混均颗粒等方法加以克服。 ③颗粒含水量太少,过分干燥的颗粒具有较大的弹性、含有结晶水 的药物在颗粒干燥过程中失去较多的结晶水,使颗粒松脆,容易松 裂片。故在制粒时,按不同品种应控制颗粒的含水量。如制成的颗 粒太干时,可喷入适量稀乙醇(50%- 60%),混匀后压片。 ④药物本身的性质。密度大压出的片剂虽有一定的硬度,但经不起 碰撞和震摇。如次硝酸铋片、苏打片等往往易产生松片现象;密度小,流动性差,可压性差,重新制粒。 ⑤颗粒的流动性差,填入模孔的颗粒不均匀。 ⑥有较大块或颗粒、碎片堵塞刮粒器及下料口,影响填充量。 ⑦压片机械的因素。压力过小,多冲压片机冲头长短不齐,车速过 快或加料斗中颗粒时多时少。可调节压力、检查冲模是否配套完整、调整车速、勤加颗粒使料斗内保持一定的存量等方法克服。 2:病症:裂片,即片剂受到震动或经放置时,从腰间裂开的称为腰裂;顶部裂开的称为顶裂,腰裂和顶裂总称为裂片。

APP手机客户端开发技术方案-完整版

手机客户端技术方案 中国电信集团系统集成有限责任公司内蒙古分公司 2010年5月 手机客户端技术方案 2 目录 述 “. 3 2需求分析 “ 3系统设计目 . .4 3.1建设意义 “. 3,2建设原 3.3建设模式 “ 4技术解决方案 “. 4,1移动中间件系统概述“, 4.2系统架 构.. 4.3系统组 4,4移动化原理

4.5中间件服务器配置 “. 5系统功能设 6手机适配型 7配置清单“. 手机客户端技术方案 3 1概述 为了提升企事业单位信息化管理水平,提高各级部门的办公效率,加强单位内部 的执行力、凝聚力,自上而下咼度重视信息化系统的建设工作,实现日常公文收 发审批、工作安排、公告通知等日常办公的统一管理,显的日趋重要。 在当前信息化管理平台的基础上,各企事业单位希望引入移动信息化技术,为相关职能部门及工作人员提供手机移动办公,将办公信息化延伸至使用 人员的手机上,实现随时、随地办公,以便能够推动各级部门的精确化、 高效化管理。 中国电信内蒙古分公司作为业界领先的移动信息化解决方案提供商,己经在区内 成功实施了多个综合办公移动化适配项目。内蒙古电信公司有足够的实力将本系 统建设成为一套精品的移动办公信息化平台 2需求分析 传统的信息化管理系统面临的问题: 1)传统办公的缺陷导致了企事业单位整体对外竞争力的降低、工作效率的 低下、成本的增加。 2)发布通知公告,采用人工或者电话、口头通知方式难免出现疏忽与意外,造成遗漏、延误、缺席等。 需求描述: 定制开发企事业单位移动办公系统,包括以下具体内容:定制开发移动办公手 机客户端系统,包括windows mobile、windows等手机操作系统的手机客户端软件;搭建中间件服务器。 定制要求:

片剂裂片的原因及解决方法

片剂裂片得原因及解决方法 片剂受到震动或经放置后从腰间裂开称“裂片”,从顶部脱落一层称“顶裂”、其产生原因及解决办法为: 1、压片物料细粉过多,或颗粒过粗、过细;或原料为针、片状结晶,且结晶过大,粘合剂未进入晶体内部引起裂片,可采用与松片相同得处理方法医学教育`网搜集整理。 2、颗粒中油类成分较多或药物含纤维成分较多时易引起裂片,可分别加用吸收剂或糖粉克服。 3、颗粒过干或药物失去过多结晶水引起裂片,可喷洒适量稀乙醇湿润,或与含水量较大得颗粒掺合后压片。 4、冲模不合要求,如模圈因磨擦而造成中间孔径大于口部直径,片剂顶出时易裂片、冲头摩损向内卷边,上冲与模圈不吻合,压力不均匀,使片剂部分受压过大而造成顶裂,可更换冲模解决、 5、压力过大,或车速过快,颗粒中空气未逸出造成裂片,可调节压力或减慢车速克服。 一:松片 松片就是压片时经常遇到得问题,会影响压片与包衣。松片主要与颗粒质量、压片机运行有密切得关系、颗粒质量就是压好片子得关键,因此,制粒工艺对于片剂质量尤为重要。影响颗粒质量得因素主要有以下几方面: 1. 中药材成分得影响、如有些中药材中含有大量得纤维成分。由于这些药材弹性大、黏性小,致使颗粒松散、片子硬度低、对此,在实际操作中可采用适宜得溶媒及方法,将此类药材中得有效成分提取浓缩,再进行颗粒制备,以降低颗粒弹性,提高可压性,进而提高片剂硬度;对含油脂量大得药材,压片亦易引起松片,如果这些油脂属有效成分,制粒时应加入适量吸收剂(如碳酸钙)等来吸油,如果这些油脂为无效成分,可用压榨法或其她脱脂法脱脂,减少颗粒油量,增加其内聚力,从而提高片子硬度。 2. 中药材粉碎度得影响。如果中药材细粉不够细,制成得颗粒黏结性不强,易使片剂松散。因此,药粉要具有一定细度,这就是制好颗粒、压好药片得前提。 3。黏合剂与湿润剂得影响。黏合剂与湿润剂在制粒中占有重要地位,其品种得选择与用量正确与否,都直接影响颗粒质量。选择黏合剂、湿润剂应视药粉性质而定,如就是全生药粉压片,应选择黏性强得黏合剂,如就是全浸膏压片,而浸膏粉中树脂黏液质成分较多,则必须选用80%以上浓度得乙醇作湿润剂。黏合剂用量太少,则颗粒细粉过多,会产生松片。 4、颗粒中水分得影响。颗粒中得水分对片剂有很大影响,适量得水分能增加脆碎粒子得塑性变形,减少弹性,有利于压片,而过干得颗粒弹性大、塑性小,难以被压成片。但如果含水量太高,也会使药片松软,甚至黏冲或堵塞料斗,从而影响压片。故每一种中药片剂其颗粒含水量必须控制在适宜范围。 另外,如果由于压片机运行时压力不足、压片机运行转速过快、冲头长短不齐而出现松片现象,可适当调大压力或减慢转速、更换冲头、如压力足够而仍出现松片现象,则应考虑其她原因,切勿强加压力,以免损害压片机。 二:裂片

某大型企业大数据平台整体解决方案

某大型企业数据平台整体解决方案

目录 1项目概述 (15) 1.1建设背景 (15) 1.1.1集团已有基础 (15) 1.1.2痛点及需提升的能力 (15) 1.1.3大数据趋势 (16) 1.2建设目标 (16) 1.2.1总体目标 (16) 1.2.2分阶段建设目标 (17) 1.3与相关系统的关系 (18) 1.3.1数据分析综合服务平台 (18) 1.3.2量收系统 (19) 1.3.3金融大数据平台 (20) 1.3.4各生产系统 (20) 1.3.5CRM (20) 1.4公司介绍和优势特点 (20) 1.4.1IDEADATA (20) 1.4.2TRANSWARP (22) 1.4.3我们的优势 (24) 2业务需求分析 (27) 2.1总体需求 (27)

2.2.1数据采集 (29) 2.2.2数据交换 (29) 2.2.3数据存储与管理 (29) 2.2.4数据加工清洗 (30) 2.2.5数据查询计算 (31) 2.3数据管控 (32) 2.4数据分析与挖掘 (32) 2.5数据展现 (33) 2.6量收系统功能迁移 (34) 3系统架构设计 (35) 3.1总体设计目标 (35) 3.2总体设计原则 (35) 3.3案例分析建议 (37) 3.3.1中国联通大数据平台 (37) 3.3.2恒丰银行大数据平台 (49) 3.3.3华通CDN运营商海量日志采集分析系统 (63) 3.3.4案例总结 (69) 3.4系统总体架构设计 (70) 3.4.1总体技术框架 (70) 3.4.2系统总体逻辑结构 (74)

3.4.4系统接口设计 (83) 3.4.5系统网络结构 (88) 4系统功能设计 (91) 4.1概述 (91) 4.2平台管理功能 (92) 4.2.1多应用管理 (92) 4.2.2多租户管理 (96) 4.2.3统一运维监控 (97) 4.2.4作业调度管理 (117) 4.3数据管理 (119) 4.3.1数据管理框架 (119) 4.3.2数据采集 (122) 4.3.3数据交换 (125) 4.3.4数据存储与管理 (127) 4.3.5数据加工清洗 (149) 4.3.6数据计算 (150) 4.3.7数据查询 (170) 4.4数据管控 (193) 4.4.1主数据管理 (193) 4.4.2元数据管理技术 (195)

片剂及其生产过程中常见问题和处理方法

片剂及其生产过程中常见问题和处理方法

片剂及其生产过程中常见问题和处理方法 于亮1 马飞2 (1.山东聊城建设学校,山东聊城252000;2.聊城万合工业制造有限公司,山东聊城252022) 摘要:通过对片剂及片剂生产过程中可能出现的问题和处理方法简单介绍,阐述了片剂生产过程中造成质量问题的诸多因素,为保证片剂质量提供了一些解决和预防的办法和经验。 关键词:片剂;片重超差;问题;处理方法 1 片剂 片剂可定义为用压制或模制的方法制成的含药物的固体制剂,可用稀释剂,也可不用。从19世纪后期开始片剂已经广泛使用并一直深受欢迎,到19世纪末随着压片设备的出现和不断改进,片剂的生产和应用得到了迅速的发展。近十几年来,片剂生产技术与机械设备方面也有较大的发展,如沸腾制粒、全粉末直接压片、半薄膜包衣、新辅料、新工艺等。总之,目前片剂已成为品种多、产量大、用途广,使用和贮运方便,质量稳定的剂型之一,片剂在中国以及其他许多国家的药典所收载的制剂总量中,均占1/3以上,可见应用之广。 1.1 片剂的特点 1.1.1 片剂的优点 (1)一般情况下片剂的溶出速率及生物利用度较丸剂好; (2)剂量准确,片剂内药物含量差异较小; (3)质量稳定,片剂为干燥固体,且某些易氧化变质及潮解的药物可借包衣加以保护,所以光线、空气、水分等对其影响较小; (4)携带、运输、服用较为方便; (5)可实现机械化生产,产量大,成本低,卫生标准也容易达到。 1.1.2 片剂的缺点 (1)片剂中药物的溶出速率较散剂及胶囊剂慢,其生物利用度稍差些; (2)儿童和昏迷病人不易吞服; (3)含挥发性成分的片剂贮存较久时含量下降。

Scala从基础到开发实战

Scala从基础到开发实战 对于进化缓慢的Java跟C++语言来说,目前Scala无疑更适应现代化特质的语言,语法简洁,同时兼备函数式编程与面向对象编程,具有令人耳目一新的编程范式。而运行在Java 虚拟机上的编译环境使得其具有很多的现有工具与类库,拥有快速的可靠的解释器和编译器。 本课程是Scala语言基础课程,面向没有或仅有少量编程语言基础的同学,当然,具有一定的Java或C、C++语言基础将有助于本课程的学习。在本课程内,将更注重scala的各种语言规则和应用,通过学习本课程能具备初步的Scala语言实际编程能力。 Scala最近的红火也得益于Spark分布式内存计算平台的兴起,由于其惊人的计算速度,Spark将要革命Hadoop的说法尘嚣日上,但学习Spark的一项瓶颈是其原生语言Scala并不为大众所熟知,即使是资深程序员,从未听说过Scala者大有人在,于是本门课程也可以称为Spark系列的前置课程,供深入学习大数据技术的同仁们进行热身运动。 课程大纲: 第一课:Scala介绍——如何安装Scala REPL、SBT、IDE,编写简单的Scala程序;函数式编程简介 第二课:Scala的class和object,Scala的变量、类的介绍 第三课:Scala的基本数据类型、控制语句 第四课:高阶函数、Currying、尾递归 第五课:数据结构:List、Map、Set 第六课:组合和继承 第七课:Trait 第八课:响应式编程介绍 第九课:Akka框架(一)——akka的基本用法 第十课:Akka框架(二)——actor的监控 第十一课:Akka框架(三)——网络编程 第十二课:Akka框架(四)——akka使用技巧

大数据平台安全解决方案

Solution 解决方案 大数据平台安全解决方案 防止数据窃取和泄露确保数据合规使用避免数据孤岛产生 方案价值 大数据平台安全解决方案为大数据平台提供完善的数据安全 防护体系,保护核心数据资产不受侵害,同时保障平台的大数据能被安全合规的共享和使用。 数据安全防护体系以至安盾?智能安全平台为核心进行建设。智能安全平台支持三权分立、安全分区、数据流转、报警预警和审计追溯等五种安全策略,以及嵌入式防火墙、访问控制、安全接入协议等三道安全防线,保证安全体系在系统安 全接入、安全运维、数据流转、数据使用、数据导出脱敏、用户管理、用户行为审计追溯等方面的建设,保障大数据平台安全高效运行。 智能安全平台提供安全云桌面,保证数据不落地的访问方式, 并可根据需求提供高性能计算资源和图形处理资源,并支持“N+M”高可靠性架构,保证云桌面的稳定运行,为平台用户提供安全高效的数据使用环境。 提供数据不落地的访问方式以及完善的文档审批和流转功能 提供五种安全策略和三道安全防线提供严格的用户权限管理和强大的用户行为审计和追溯功能 提供高性能、高可靠稳定运行的大数据使用环境 方案亮点 如欲了解有关志翔科技至安盾? ZS-ISP、至明? ZS-ISA安全探针产品的更多信息,请联系您的志翔科技销售代表,或访问官方网站:https://www.sodocs.net/doc/af1037673.html, 更多信息 志翔科技是国内创新型的大数据安全企业,致力于为政企客户提供核心数据保护和业务风险管控两个方向的产品及服务。志翔科技打破传统固定访问边界,以数据为新的安全中心,为企业构筑兼具事前感知、发现,事中阻断,事后溯源,并不断分析与迭代的安全闭环,解决云计算时代的“大安全”挑战。志翔科技是2017年IDC中国大数据安全创新者,2018年安全牛中国网络安全50强企业。2019年,志翔云安全产品入选Gartner《云工作负载保护平台市场指南》。 关于志翔科技 北京志翔科技股份有限公司https://www.sodocs.net/doc/af1037673.html, 电话: 010- 82319123邮箱:contact@https://www.sodocs.net/doc/af1037673.html, 北京市海淀区学院路35号世宁大厦1101 邮编:100191 扫码关注志翔

片剂裂片的原因及解决方法

片剂裂片的原因及解决方法 片剂受到震动或经放置后从腰间裂开称“裂片”,从顶部脱落一层称“顶裂”。其产生原因及解决办法为: 1、压片物料细粉过多,或颗粒过粗、过细;或原料为针、片状结晶,且结晶过大,粘合剂未进入晶体内部引起裂片,可采用与松片相同的处理方法医学教育`网搜集整理。 2、颗粒中油类成分较多或药物含纤维成分较多时易引起裂片,可分别加用吸收剂或糖粉克服。 3、颗粒过干或药物失去过多结晶水引起裂片,可喷洒适量稀乙醇湿润,或与含水量较大的颗粒掺合后压片。 4、冲模不合要求,如模圈因磨擦而造成中间孔径大于口部直径,片剂顶出时易裂片。冲头摩损向内卷边,上冲与模圈不吻合,压力不均匀,使片剂部分受压过大而造成顶裂,可更换冲模解决。 5、压力过大,或车速过快,颗粒中空气未逸出造成裂片,可调节压力或减慢车速克服。 一:松片 松片是压片时经常遇到的问题,会影响压片与包衣。松片主要与颗粒质量、压片机运行有密切的关系。颗粒质量是压好片子的关键,因此,制粒工艺对于片剂质量尤为重要。影响颗粒质量的因素主要有以下几方面:

1. 中药材成分的影响。如有些中药材中含有大量的纤维成分。由于这些药材弹性大、黏性小,致使颗粒松散、片子硬度低。对此,在实际操作中可采用适宜的溶媒及方法,将此类药材中的有效成分提取浓缩,再进行颗粒制备,以降低颗粒弹性,提高可压性,进而提高片剂硬度;对含油脂量大的药材,压片亦易引起松片,如果这些油脂属有效成分,制粒时应加入适量吸收剂(如碳酸钙)等来吸油,如果这些油脂为无效成分,可用压榨法或其他脱脂法脱脂,减少颗粒油量,增加其内聚力,从而提高片子硬度。 2. 中药材粉碎度的影响。如果中药材细粉不够细,制成的颗粒黏结性不强,易使片剂松散。因此,药粉要具有一定细度,这是制好颗粒、压好药片的前提。 3. 黏合剂与湿润剂的影响。黏合剂与湿润剂在制粒中占有重要地位,其品种的选择和用量正确与否,都直接影响颗粒质量。选择黏合剂、湿润剂应视药粉性质而定,如是全生药粉压片,应选择黏性强的黏合剂,如是全浸膏压片,而浸膏粉中树脂黏液质成分较多,则必须选用80%以上浓度的乙醇作湿润剂。黏合剂用量太少,则颗粒细粉过多,会产生松片。 4. 颗粒中水分的影响。颗粒中的水分对片剂有很大影响,适量的水分能增加脆碎粒子的塑性变形,减少弹性,有利于压片,而过干的颗粒弹性大、塑性小,难以被压成片。但如果含水量太高,也会使药片松软,甚至黏冲或堵塞料斗,从而影响压片。故每一种中药片剂

大数据开发新手学习指南(经典)

上市公司,官网:https://www.sodocs.net/doc/af1037673.html, 大数据开发初学者该如何学习 导读: 第一章:初识Hadoop 第二章:更高效的WordCount 第三章:把别处的数据搞到Hadoop上 第四章:把Hadoop上的数据搞到别处去 第五章:快一点吧,我的SQL 第六章:一夫多妻制 第七章:越来越多的分析任务 第八章:我的数据要实时 第九章:我的数据要对外 第十章:牛逼高大上的机器学习 经常有初学者会问,自己想往大数据方向发展,该学哪些技术,学习路线是什么样的,觉得大数据很火,就业很好,薪资很高……首先,如果你确定了想往这个方面发展,先考虑自己的过去从业经历、专业、兴趣是什么。计算机专业——操作系统、硬件、网络、服务器?软件专业——软件开发、编程、写代码?还是数学、统计学专业——对数据和数字特别感兴趣? 其实这就是想告诉你大数据的三个发展方向,平台搭建/优化/运维/监控、大数据开发/设计/架构、数据分析/挖掘。 先扯一下大数据的4V特征: ?数据量大,TB->PB ?数据类型繁多,结构化、非结构化文本、日志、视频、图片、地理位置等;

上市公司,官网:https://www.sodocs.net/doc/af1037673.html, ?商业价值高,但是这种价值需要在海量数据之上,通过数据分析与机器学习更快速的挖掘出来; ?处理时效性高,海量数据的处理需求不再局限在离线计算当中。 现如今,正式为了应对大数据的这几个特点,开源的大数据框架越来越多,越来越强,先列举一些常见的: 文件存储:Hadoop HDFS、Tachyon、KFS 离线计算:Hadoop MapReduce、Spark 流式、实时计算:Storm、Spark Streaming、S4、Heron K-V、NOSQL数据库:HBase、Redis、MongoDB 资源管理:YARN、Mesos 日志收集:Flume、Scribe、Logstash、Kibana 消息系统:Kafka、StormMQ、ZeroMQ、RabbitMQ 查询分析:Hive、Impala、Pig、Presto、Phoenix、SparkSQL、Drill、Flink、Kylin、Druid 分布式协调服务:Zookeeper 集群管理与监控:Ambari、Ganglia、Nagios、Cloudera Manager 数据挖掘、机器学习:Mahout、Spark MLLib 数据同步:Sqoop 任务调度:Oozie 1.1 学会百度与Google

高校科研大数据平台解决方案

教学科研大数据平台 解决方案

目录 1.概述 (3) 1.1.背景 (3) 1.2.建设目标 (3) 1.3.建设的步骤和方法 (3) 2.教学科研大数据平台概要 (4) 2.1.架构设计 (4) 2.2.教学科研大数据平台优势 (6) 2.2.1.应用优势 (6) 2.2.2.未来发展优势 (8) 3.教学科研大数据平台设计 (8) 3.1.大数据资源池 (9) 3.1.1.cProc云计算 (9) 3.1.1.1.cProc云计算概述 (9) 3.1.1.2.数据立方 (10) 3.1.1.3.混合存储策略 (15) 3.1.1.4.云计算核心技术 (15) 3.1.1.4.1.数据处理集群的可靠性与负载均衡技术 (15) 3.1.1.4.2.计算与存储集群的可靠性与负载均衡 (19) 3.1.1.4.3.计算与存储集群的负载均衡处理 (21) 3.1.1.4.4.分布式文件系统的可靠性设计 (23) 3.1.1.4.5.分布式数据立方可靠性设计 (23) 3.1.1.4.6.分布式并行计算可靠性设计 (25) 3.1.1.4.7.查询统计计算可靠性鱼负载均衡设计 (25) 3.1.1.4.8.数据分析与数据挖掘 (27) 3.1.1.4.9.cProc云计算优势 (35) 3.1.2.cStor云存储 (36) 3.1.2.1.cStor云存储介绍 (36) 3.1.2.2.cStor云存储架构 (38) 3.1.2.3.Stor云存储关键技术 (43) 3.1.2.4.数据安全诊断技术 (44) 3.1.2.5.cStor云存储优势 (45) 3.2.大数据教学基础平台 (46) 3.2.1.Hadoop架构 (46) 3.2.2.Hadoop关键技术 (47) 3.2.3.Hadoop优势 (51) 3.2.4.Hadoop教学 (51)

制剂生产过程中常见问题和处理方法doc20

制剂生产过程中常见问题和处 理方法doc20 制剂生产过程中常见问题和处理方法 一、质量问题 制剂生产过程由于种种原因造成制剂的质量不合格,尤其是在片剂生产中,造成片剂质量问题的因素更多。现仅对片剂、胶囊剂及注射剂生产中可能产生质量问题的原因及解决方法作介绍。 (一)片剂生产过程中可能发生问题的分析及解决方法 1.松片 片剂压成后,硬度不够,表面有麻孔,用手指轻轻加压即碎裂, 原因分析及解决方法: ①药物粉碎细度不够、纤维性或富有弹性药物或油类成分含量较多而混合不均匀。可将药物粉碎过100目筛、选用黏性较强的黏合剂、适当增加压片机的压力、增加油类药物吸收剂充分混匀等方法加以克服。

②黏合剂或润湿剂用量不足或选择不当,使颗粒质地疏松或颗粒粗细分布不匀,粗粒与细粒分层。可选用适当黏合剂或增加用量、改进制粒工艺、多搅拌软材、混均颗粒等方法加以克服。 ③颗粒含水量太少,过分干燥的颗粒具有较大的弹性、含有结 晶水的药物在颗粒干燥过程中失去较多的结晶水,使颗粒松脆,容易松裂片。故在制粒时,按不同品种应控制颗粒的含水量。如制成的颗粒太干时,可喷入适量稀乙醇(50汇60%,混匀后压片。 ④药物本身的性质。密度大压出的片剂虽有一定的硬度,但经 不起碰撞和震摇。如次硝酸铋片、苏打片等往往易产生松片现象;密度小,流动性差,可压性差,重新制粒。 ⑤颗粒的流动性差,填入模孔的颗粒不均匀。 ⑥有较大块或颗粒、碎片堵塞刮粒器及下料口,影响填充量。 ⑦压片机械的因素。压力过小,多冲压片机冲头长短不齐,车速过快或加料斗中颗粒时多时少。可调节压力、检查冲模是否配套完整、调整车速、勤加颗粒使料斗内保持一定的存量等方法克服。 2.裂片 片剂受到震动或经放置时,有从腰间裂开的称为腰裂;从顶部裂开的称为顶裂,腰裂和顶裂总称为裂片,原因分析及解决方法: ①药物本身弹性较强、纤维性药物或因含油类成分较多。可加入糖粉以减少纤维弹性,加强黏合作用或增加油类药物的吸收剂,充分混匀后压片。 ②黏合剂或润湿剂不当或用量不够,颗粒在压片时粘着力差。

用Apache Spark进行大数据处理——第一部分:入门介绍

用Apache Spark进行大数据处理——第一部分:入门介绍 什么是Spark Apache Spark是一个围绕速度、易用性和复杂分析构建的大数据处理框架。最初在2009年由加州大学伯克利分校的AMPLab开发,并于2010年成为Apache的开源项目之一。与Hadoop和Storm等其他大数据和MapReduce技术相比,Spark有如下优势。 首先,Spark为我们提供了一个全面、统一的框架用于管理各种有着不同性质(文本数据、图表数据等)的数据集和数据源(批量数据或实时的流数据)的大数据处理的需求。 Spark可以将Hadoop集群中的应用在内存中的运行速度提升100倍,甚至能够将应用在磁盘上的运行速度提升10倍。 Spark让开发者可以快速的用Java、Scala或Python编写程序。它本身自带了一个超过80个高阶操作符集合。而且还可以用它在shell中以交互式地查询数据。 除了Map和Reduce操作之外,它还支持SQL查询,流数据,机器学习和图表数据处理。开发者可以在一个数据管道用例中单独使用某一能力或者将这些能力结合在一起使用。 在这个Apache Spark文章系列的第一部分中,我们将了解到什么是Spark,它与典型的MapReduce解决方案的比较以及它如何为大数据处理提供了一套完整的工具。 Hadoop和Spark Hadoop这项大数据处理技术大概已有十年历史,而且被看做是首选的大数据集合处理的解决方案。MapReduce是一路计算的优秀解决方案,不过对于需要多路计算和算法的用例来说,并非十分高效。数据处理流程中的每一步都需要一个Map阶段和一个Reduce阶段,而且如果要利用这一解决方案,需要将所有用例都转换成MapReduce模式。 在下一步开始之前,上一步的作业输出数据必须要存储到分布式文件系统中。因此,复制和磁盘存储会导致这种方式速度变慢。另外Hadoop解决方案中通常会包含难以安装和管理的集群。而且为了处理不同的大数据用例,还需要集成多种不同的工具(如用于机器学习的Mahout和流数据处理的Storm)。 如果想要完成比较复杂的工作,就必须将一系列的MapReduce作业串联起来然后顺序执行这些作业。每一个作业都是高时延的,而且只有在前一个作业完成之后下一个作业才能开始启动。 而Spark则允许程序开发者使用有向无环图(DAG)开发复杂的多步数据管道。而且还支持跨有向无环图的内存数据共享,以便不同的作业可以共同处理同一个数据。

(完整word版)农村大数据平台解决方案

农村大数据平台解决方案

时间:2018年9月

1大数据服务基础平台 (1) 2农村大数据资源中心 (2) 2.1涉农信息基础大数据 (2) 2.2农业产业技术数据 (2) 2.3农村生活信息服务数据 (3) 2.4政务应用数据 (3) 3大数据共享平台 (3) 4大数据分析平台 (3) 4.1区域经济分析 (4) 4.2生产智能化大数据平台 (4) 4.3农产品质量安全追溯大数据应用 (5) 4.4农产品产销信息监测预警大数据分析 (5) 5智慧农业云平台 (6) 6大数据精准扶贫 (6) 7农村网络舆情监测平台 (7)

农村大数据平台解决方案 根据《关于实施乡村振兴战略的意见》(中发〔2018〕1号)、《农业部办公厅关于印发〈农业农村大数据试点方案〉的通知》(农办市〔2016〕30号)、《农业部关于印发〈”十三五”全国农业农村信息化发展规划〉的通知》(农市发〔2016〕5号)、《农业部关于推进农业农村大数据发展的实施意见》(农市发〔2015〕6号)和《国务院关于印发促进大数据发展行动纲要的通知》(国发〔2015〕50号)等有关部署文件要求,公司经过大量的调研和论证,集中技术力量研发的一整套针对我国农村农业现状的大数据平台产品体系,包含农村大数据基础服务平台、农村大数据资源中心、大数据共享平台、大数据分析平台、智慧农业云平台、大数据精准扶贫、农村网络舆情监测平台等产品。 1大数据服务基础平台 作为农村大数据平台的核心与基础,集成了大数据平台的多个底层组件,提供分布式存储(HDFS)、分布式计算、协调服务管理、数据仓库SQL服务、NoSQL数据库服务,分布式内存计算,ETL 调度与操作,实时流处理、分布式内存、索引搜索、数据库联邦查询、MPP数据库服务,图数据库和时序数据库等功能和服务。同时支持大数据的分布式机器学习算法比如多重估值算法。 平台基于镇平县农业大数据研究的个性化需求,形成一系列相关公开发布数据的采集机制,将数据采集的相关程序设计并编写完善,部署此套机制在平台上周期运转;为管理人员与数据工程师提供数据的浏览,对数据进行查询、展现和基础统计分析等初步应用,实现农业大数据分析人员的交流平台。 1

片剂产生松片,裂片,粘冲与吊冲,片重差异超限的原因及解决办法

片剂产生松片,裂片,粘冲与吊冲,片重差异超限的原因及解决办法 在药品生产的一线,常常会遇到各种各样的问题,而就是这些细节,往往能影响产品的质量水准。本文从实际经验出发,对于片剂生产中出现的“病症”给予诊断分析,并给出了详细“处方”。希望能给一线生产人员提供一定的帮助。 一,松片:即片挤压成后,硬度不够,表面有嘛空,用手轻压即碎裂。 1,药物粉碎细度不够,纤维性或富含弹性药物或油类成分含量较多而混合不均匀。可将药物粉碎过100目筛,选用黏性较强的粘合剂,适当增加压片机压力,增加油类药物吸收剂充分混匀等方法加以克服。 2,粘合剂或润湿剂用量不足或选择不当,使颗粒质地疏松或颗粒粗细分布不均,粗粒与细粒分层。可选用适当粘合剂或增加用量,改进制粒工艺,多搅拌软材,混匀颗粒等方法加以克服。 3,颗粒含水量太少,过分干燥的颗粒具有较大的弹性,含有结晶水的药物在克里干燥的过程中容易失去较多的结晶水,使颗粒松脆,容易裂片。故在制粒时,按不同品种应控制颗粒的含水量。如制成的颗粒太干时,可喷入适量稀乙醇(50%-60%),混匀后压片。4,药物本身性质。密度大压出的片剂虽有一定的硬度,但经不起碰撞和震摇。入次硝酸铋片,苏打片等往往易产生松片现象;密度小,流动性差,可压性差,重新制粒。 5,颗粒的流动性差,填入膜孔的颗粒不均匀。 6,有较大块或颗粒,碎片堵塞刮料器及下料口,影响填充量。 7,压片机的因素。压力过小,多冲压片机冲头长短不齐,车速过快或加料斗中颗粒时多时少。可调节压力,检查冲模是否配套完整,调整车速,勤加颗粒使料斗内保持一定的存量等方法克服。 二,裂片:即片剂受到震动或经放置时,从腰间裂开的称腰裂:顶部裂开的称顶裂 1,药物本身弹性较强,纤维性药物或因油类成分见多。可加入糖粉以减少纤维弹性,加强粘合作用或增加油类药物的吸收剂,充分混匀后压片。 2,粘合剂或润湿剂不当或用量不够,颗粒在压片时黏着力差。 3,颗粒太干,含结晶水药物失去过多造成裂片,解决办法同松片。 4,有些结晶性药物,未经过充分的粉碎。可将此类药物充分粉碎后制粒。 5,细粉过多,润滑剂过量引起裂片,粉末中部分空气不能及时逸出而被压在片剂内,当接触压力后,片剂内部空气膨胀造成裂片,可筛去部分细分或适当减少润滑剂用量加以克服。 6,压片机压力过大,反弹力大而裂片;车速过快或冲模不符合要求,冲头有长短,中部磨损,其中部大于上下部或冲头向内卷边,均可使片剂顶出时造成裂片。可调节压力与车速,改进冲模配套,及时检查调换。 7,压片室室温低,湿度低,一造成裂片,特别是粘性差的药物容易产生。调节空调系统可以解决。 三,粘冲与吊冲:即压片时片剂表面细粉被冲头或冲模粘附,只是表面不光,不平有凹痕,刻字冲头更易发生粘冲现象。吊冲边的边缘粗糙哟纹路。 1,颗粒含水量过多,含引湿性易受潮的药物,操作室温度与湿度过高易产生粘冲。应注意适当干燥,降低操作室温度,湿度避免引湿性药物受潮等。 2,润滑剂用量过少或含量不均,细粉过多。应适当增加润滑剂用量或充分混合,解决粘冲问题。 3,冲头表面不干净,有防锈油或润滑油,新冲模表面粗糙或刻字太深有菱角。可将冲头搽干净,调换不合规格的冲模或用微量液状石蜡在刻字冲头表面是字面润滑。此外,入为机械发热造成粘冲时应检查原因,检修设备。

利用Scala语言开发Spark应用程序

利用Scala语言开发Spark应用程序 park内核是由Scala语言开发的,因此使用Scala语言开发Spark应用程序是自然而然的事情。如果你对Scala语言还不太熟悉,可以阅读网络教程A Scala Tutorial for Java Programmers或者相关Scala书籍进行学习。 AD: Spark内核是由Scala语言开发的,因此使用Scala语言开发Spark应用程序是自然而然的事情。如果你对Scala语言还不太熟悉,可以阅读网络教程A Scala Tutorial for Java Programmers或者相关Scala书籍进行学习。 本文将介绍3个Scala Spark编程实例,分别是WordCount、TopK和SparkJoin,分别代表了Spark 的三种典型应用。 1. WordCount编程实例 WordCount是一个最简单的分布式应用实例,主要功能是统计输入目录中所有单词出现的总次数,编写步骤如下: 步骤1:创建一个SparkContext对象,该对象有四个参数:Spark master位置、应用程序名称,Spark安装目录和jar存放位置,对于Spark On Y ARN而言,最重要的是前两个参数,第一个参数指定为yarn-standalone ,第二个参数是自定义的字符串,举例如下: valsc=newSparkContext(args(0), WordCount ,System.getenv( SPARK_HOME ),Seq(System.getenv( SPARK_TEST_JAR ))) 步骤2:读取输入数据。我们要从HDFS上读取文本数据,可以使用SparkCon valtextFile=sc.textFile(args(1)) 当然,Spark允许你采用任何Hadoop InputFormat,比如二进制输入格式SequenceFileInputFormat,此时你可以使用SparkContext中的hadoopRDD函数,举例如下: valinputFormatClass=classOf[SequenceFileInputFormat[Text,Text]]varhadoopRdd=sc.hadoopRDD(c onf,inputFormatClass,classOf[Text],classOf[Text]) 或者直接创建一个HadoopRDD对象: varhadoopRdd=newHadoopRDD(sc,conf,classOf[SequenceFileInputFormat[Text,Text,classOf[Text],c lassOf[Text]) 步骤3:通过RDD转换算子操作和转换RDD,对于WordCount而言,首先需要从输入数据中每行字符串中解析出单词,水草玛瑙 https://www.sodocs.net/doc/af1037673.html,然后将相同单词放到一个桶中,最后统计每个桶中每个单词出现的频率,举例如下: valresult=hadoopRdd.flatMap{case(key,value)= value.toString().split( \\s+ }.map(word= (word,1)).reduceByKey(_+_) 其中,flatMap函数可以将一条记录转换成多条记录(一对多关系),map函数将一条记录转换为另一条记录(一对一关系),高山茶 https://www.sodocs.net/doc/af1037673.html, reduceByKey函数将key相同的数据划分到一个桶中,并以key为单位分组进行计算,这些函数的具体含义可参考:Spark Transformation。步骤4:将产生的RDD数据集保存到HDFS上。可以使用SparkContext中的saveAsTextFile哈数将数据集保存到HDFS目录下,默认采用Hadoop提供的TextOutputFormat,每条记录以(key,value)的形式打印输出,你也可以采用saveAsSequenceFile函数将数据保存为SequenceFile格式等,举例如下: result.saveAsSequenceFile(args(2)) 当然,一般我们写Spark程序时,需要包含以下两个头文件: importorg.apache.spark._importSparkContext._ WordCount完整程序已在Apache Spark学习:利用Eclipse构建Spark集成开发环境一文中进行了介绍,在次不赘述。 需要注意的是,指定输入输出文件时,需要指定hdfs的URI,比如输入目录是hdfs:hadoop-testtmpinput,输出目录是hdfs:hadoop-testtmpoutput,其中,hdfs:hadoop-test 是由Hadoop配置文件core- site.xml中参数https://www.sodocs.net/doc/af1037673.html,指定的,具体替换成你的配置即可。 2. TopK编程实例