openstack 单网卡安装多节点

一.

准备系统 操作系统:ubunt12.04 server 64(桌面也 ok)

1.将你的系统升级到最新

1 2

sudo apt-get update sudo aptitude uograde

下面的这些操作大家最好都用 root 用户来操作, sudo passwd root 这个可以设置 ubuntu root su 2.设置本机的 ip

1

sudo vim /etc/network/interfaces

将下面的设置复制进去 这个 ip 是可以更改的,如果改变亦需要保持后续的 ip 都跟着更改

1 2 3 4 5 6 7 8 9 10 11

auto lo iface lo inet loopback

# The primary network interface auto eth0 iface eth0 inet static address 192.168.1.2 netmask 255.255.255.0 broadcast 192.168.1.255 gateway 192.168.1.1 dns-nameservers 202.117.128.2 #根据自己的环境设置好

然后重启网络,让配置生效:

1

/etc/init.d/networking restart

2.安装 bridge

1

apt-get install bridge-utils

重启网络

1

/etc/init.d/networking restart

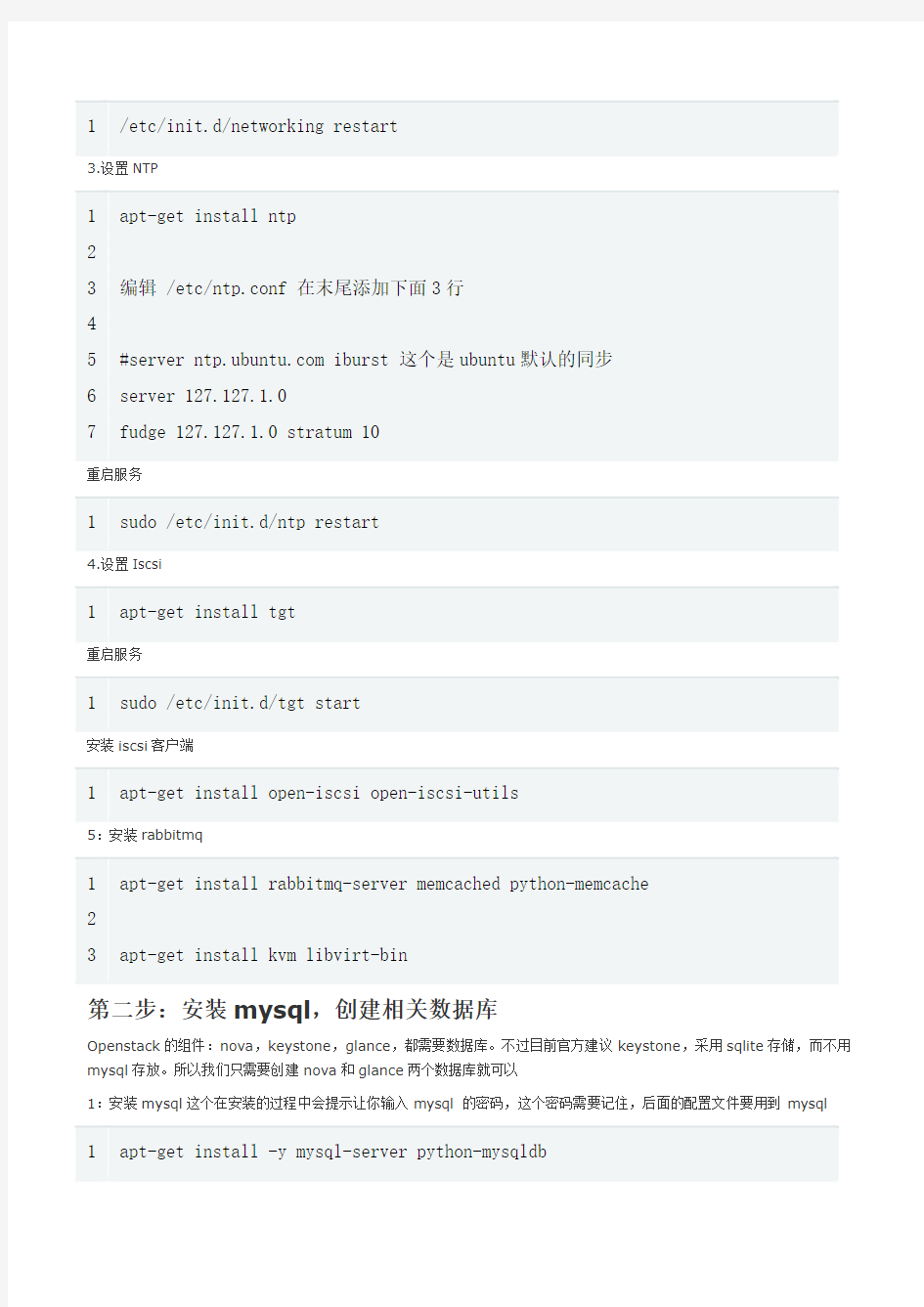

3.设置 NTP

1 2 3 4 5 6 7

apt-get install ntp

编辑 /etc/ntp.conf 在末尾添加下面 3 行

#server https://www.sodocs.net/doc/3c7152670.html, iburst 这个是 ubuntu 默认的同步 server 127.127.1.0 fudge 127.127.1.0 stratum 10

重启服务

1

sudo /etc/init.d/ntp restart

4.设置 Iscsi

1

apt-get install tgt

重启服务

1

sudo /etc/init.d/tgt start

安装 iscsi 客户端

1

apt-get install open-iscsi open-iscsi-utils

5:安装 rabbitmq

1 2 3

apt-get install rabbitmq-server memcached python-memcache

apt-get install kvm libvirt-bin

第二步:安装 mysql,创建相关数据库

Openstack 的组件:nova,keystone,glance,都需要数据库。不过目前官方建议 keystone,采用 sqlite 存储,而不用 mysql 存放。所以我们只需要创建 nova 和 glance 两个数据库就可以 1:安装 mysql 这个在安装的过程中会提示让你输入 mysql 的密码,这个密码需要记住,后面的配置文件要用到 mysql

1

apt-get install -y mysql-server python-mysqldb

让 mysql 支持外部访问

1

sed -i 's/127.0.0.1/0.0.0.0/g' /etc/mysql/https://www.sodocs.net/doc/3c7152670.html,f

然后重启服务

1

service mysql restart

-----这个安装不安装无所谓

安装 phpmyadmin

为了方便,可以把 phpmyadmin 装上,可以比较方便管理数据库

1

apt-get install phpmyadmin

2.创建数据库 nova 数据库,管理员:novadbadmin,密码是:lost glance 数据库,管理员:glancedbadmin,密码是:lost 如果你修改密码,后面很多配置都需要相应更改。

1 2 3 4 5 6

mysql -uroot -p CREATE DATABASE nova; GRANT ALL PRIVILEGES ON nova.* TO 'novadbadmin'@'%' IDENTIFIED BY 'lost'; CREATE DATABASE glance; GRANT ALL PRIVILEGES ON glance.* TO 'glancedbadmin'@'%' IDENTIFIED BY 'lost'; quit

三:安装和配置 keystone

1:安装 keystone

1

apt-get install keystone python-keystone python-keystoneclient

2:配置 keystone 需要修改 /etc/keystone/keystone.conf 两个地方

默认定义的 token 就是 ADMIN,我使用 admin 作为 token

1 2 3 4 5 6

[DEFAULT] bind_host = 0.0.0.0 public_port = 5000 admin_port = 35357 #admin_token = ADMIN admin_token =admin

还有另外一个地方是

1 2 3 4

[catalog] #driver = keystone.catalog.backends.sql.Catalog driver = keystone.catalog.backends.templated.TemplatedCatalog template_file = /etc/keystone/default_catalog.templates

重启服务

1

service keystone restart

3: 导入数据 这个是通过修改 devstack 的 keystone_data.sh 脚本。实现导入数据。如果你上面的设置都和我一样,那直接运行这个脚本 就可以。 https://www.sodocs.net/doc/3c7152670.html,/system/files/user/4/keystone_data.sh_.txt

1 2

wget https://www.sodocs.net/doc/3c7152670.html,/system/files/user/4/keystone_data.sh_.txt mv keystone_data.sh_.txt keystone_data.sh

让脚本可运行

1

chmod +x keystone_data.sh

运行脚本, 如果你修改的默认的用户名和密码,你需要修改脚本。修改两个地方 第一个是登录 dashboard 的 admin 的密码 第二个就是 keystone 的 token

1 2 3

#ADMIN_PASSWORD=${ADMIN_PASSWORD:-hastexo} ADMIN_PASSWORD=${ADMIN_PASSWORD:-admin} SERVICE_PASSWORD=${SERVICE_PASSWORD:-$ADMIN_PASSWORD}

4 5 6 7

#export SERVICE_TOKEN="hastexo" export SERVICE_TOKEN="admin" #这个密码是可以自己定的 ,测试环境可以统一用 admin

export SERVICE_ENDPOINT="http://localhost:35357/v2.0" SERVICE_TENANT_NAME=${SERVICE_TENANT_NAME:-service}

然后运行这个脚本

1

./keystone_data.sh

顺利运行,会什么都没有输出 root@openstack:~# echo $? 0 root@openstack:~# keystone --tenant=admin --username=admin --password=hastexo --auth_url=http://127.0.0.1:5000/v2.0 user-list 看到这些,就说明 keystone 安装正常。 接下来就是添加环境变量 Sudo vim /etc/profile # 在最后填上这些就 ok

1 2 3 4

export OS_TENANT_NAME=admin export OS_USERNAME=admin export OS_PASSWORD=admin export OS_AUTH_URL="http://localhost:5000/v2.0/"

然后运行注意修改 profile 文件后,如果不重启不会马上起作用,如果不想重启,可以 Source /etc/profile keystone user-list

四:安装和配置 glance

1:安装软件 apt-get install glance glance-api glance-client glance-common glance-registry python-glance 2:配置/etc/glance/glance-api-paste.ini 修改文件最后 3 行,这些设置都是 keystone 导入数据的时候设置的。

1 2 3

改成

admin_tenant_name = %SERVICE_TENANT_NAME% admin_user = %SERVICE_USER% admin_password = %SERVICE_PASSWORD%

1 2 3

admin_tenant_name =admin admin_user =admin admin_password =admin

3:设置 /etc/glance/glance-registry-paste.ini 也是修改文件最后 3 行,和上面是一样的。

1 2 3

改成

admin_tenant_name = %SERVICE_TENANT_NAME% admin_user = %SERVICE_USER% admin_password = %SERVICE_PASSWORD%

1 2 3

admin_tenant_name =admin admin_user =admin admin_password =admin

4:配置/etc/glance/glance-registry.conf 修改

#sql_connection = sqlite:////var/lib/glance/glance.sqlite同时在末尾添加两行

1 2

[paste_deploy] flavor = keystone

5:配置/etc/glance/glance-api.conf 在末尾添加两行

1 2

[paste_deploy] flavor = keystone

6:同步数据库 目前 glance 需要手工同步数据库。你装一个 phpmyadmin,先确认 glance 数据库没任何内容。

1 2

glance-manage version_control 0 glance-manage db_sync

成功之后会输出:

重启服务

1 2 3 4 5 6 7 8

运行

service glance-api restart && service glance-registry restart1

7:验证 glance 服务是否正常

这个如果添加了环境变量 可以直接运行 glance index

export OS_TENANT_NAME=admin export OS_USERNAME=admin export OS_PASSWORD=a export OS_AUTH_URL="http://localhost:5000/v2.0/"

glance index 没有任何的输出。表示正常。 #echo $?

下面会输出 0 ,表示正常。

# glance –version glance 2012.1 8:下载镜像并上传 ubuntu 官方专门提供 image,https://www.sodocs.net/doc/3c7152670.html,。不过一定要注意 这些镜像,都是必须使用密钥登录,直接用用户名密码是无法的登录的。 下载镜像记住:这个镜像可以提前下载好 https://www.sodocs.net/doc/3c7152670.html,/precise/current/ 这应该是 ubuntu 提供的最新的稳定的镜像。

1

wget https://www.sodocs.net/doc/3c7152670.html,/precise/current/precise-server-cloudimg-amd64-disk1.

2

glance add name="Ubuntu 12.04 cloudimg amd64" is_public=true container_format=ovf disk_format=qcow2 < /root/precise-server-cloudimg-amd64-disk1.img

#/root/precise-server-cloudimg-amd64-disk1.img

这个是放置镜像的路径,我们可以提前自

己先下载好这个镜像,使用 wget 命令下载 比如:/home/ubunut(当前用户)/openstack 则添加镜像的命令为: glance add name="Ubuntu 12.04 cloudimg amd64" is_public=true container_format=ovf disk_format=qcow2 上传完镜像后。在运行 glance index 或者

1

glance –username=admin –password=admin –tenant=admin –auth_url=http://127.0.0.1:5000/v2.0 index

就可以看到上传的 image。

五:安装配置 nova

1:安装 nova 相关组件

1

apt-get install nova-api nova-cert nova-common nova-compute nova-compute-kvm nova-doc nova-network nova-objectstore nova-scheduler nova-volume python-nova python-novaclient nova-consoleauth python-novnc novnc

2:配置 /etc/nova/nova.conf 把 nova.conf 原来的内容删除掉。直接贴下面内容。重点需要注意的是, 如果你是在虚拟机里测试 Openstack。你需要把默认的虚拟化引擎从 kvm 改成 qemu。 还有就是修改 /etc/nova/nova-compute.conf 将默认的虚拟化引擎从 kvm 改成 qemu。

1 2 3 1 2 3

root@openstack:~# cat /etc/nova/nova-compute.conf

--libvirt_type=kvm root@openstack:~# cat /etc/nova/nova.conf --dhcpbridge_flagfile=/etc/nova/nova.conf --dhcpbridge=/usr/bin/nova-dhcpbridge

4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32

--logdir=/var/log/nova --state_path=/var/lib/nova --lock_path=/var/lock/nova --allow_admin_api=true --use_deprecated_auth=false --auth_strategy=keystone --scheduler_driver=nova.scheduler.simple.SimpleScheduler --s3_host=192.168.1.2 --ec2_host=192.168.1.2 --rabbit_host=192.168.1.2 --cc_host=192.168.1.2 --nova_url=http://192.168.1.2:8774/v1.1/ --routing_source_ip=192.168.1.2 --glance_api_servers=192.168.1.2:9292 --image_service=nova.image.glance.GlanceImageService --iscsi_ip_prefix=10.0.0 --sql_connection=mysql://novadbadmin:lost@192.168.1.2/nova --ec2_url=http://192.168.1.2:8773/services/Cloud --keystone_ec2_url=http://192.168.1.2:5000/v2.0/ec2tokens --api_paste_config=/etc/nova/api-paste.ini --libvirt_type=kvm --libvirt_use_virtio_for_bridges=true --start_guests_on_host_boot=true --resume_guests_state_on_host_boot=true #novnc --novnc_enabled=true --novncproxy_base_url= http://192.168.1.2:6080/vnc_auto.html --vncserver_proxyclient_address=127.0.0.1 --vncserver_listen=127.0.0.1

33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48

# network specific settings --network_manager=https://www.sodocs.net/doc/3c7152670.html,work.manager.FlatDHCPManager --public_interface=eth0 --flat_interface=eth0 --flat_network_bridge=br100 --fixed_range=10.0.0.32/27 --floating_range=192.168.1.32/27 --network_size=32 --flat_network_dhcp_start=192.168.1.33 --flat_injected=False --force_dhcp_release --iscsi_helper=tgtadm --connection_type=libvirt --root_helper=sudo nova-rootwrap #--verbose --verbose=False

3:配置/etc/nova/api-paste.ini 也是修改文件最后 3 行,

1 2 3

改成

admin_tenant_name = %SERVICE_TENANT_NAME% admin_user = %SERVICE_USER% admin_password = %SERVICE_PASSWORD%

1 2 3

admin_tenant_name =admin admin_user =admin admin_password =admin

4:停止和重启 nova 相关服务

1

for a in libvirt-bin nova-network nova-compute nova-api nova-objectstore nova-scheduler novn "$a" restart; done

当然也可以自己建立一个脚本 touch /home/Ubuntu/openstack/restartnova.sh

cd 进入到对应的目录 gedit/vim #!/bin/bash for a in libvirt-bin nova-network nova-compute nova-api nova-objectstore nova-scheduler novnc nova-volume nova-consoleauth; do service "$a" restart; done restartnova.sh #直接将下面的文件 copy 就 ok 记得 chmod +x restartnova.sh

5:同步数据库

1

nova-manage db sync

创建网络

1

nova-manage network create private --fixed_range_v4=10.0.0.32/27 --num_networks=1 --bridg --network_size=32

设定 floating IP

1

nova-manage floating create --ip_range=192.168.1.32/27

设置权限

1

chown -R nova:nova /etc/nova

再重启相关服务或者执行 ./restartnava.sh

1

for a in libvirt-bin nova-network nova-compute nova-api nova-objectstore nova-scheduler novn "$a" restart; done

6:检查 nova 服务 nova-manage service list 如果你的服务都正常,这个时候会看到几个服务和几个笑脸

六:创建 VM

1: 创建密钥 # ssh-keygen 一路回车,就可以了默认存储在 /root/.ssh/ 2:上传密钥到数据库

1

nova keypair-add --pub_key .ssh/id_rsa.pub key1

这个时候,就可以查看到上传的 key 4:开始创建虚拟机 打开防火墙

1 2 3

nova secgroup-add-rule default tcp 1 65535 0.0.0.0/0 nova secgroup-add-rule default udp 1 65535 0.0.0.0/0 nova secgroup-add-rule default icmp -1 -1 0.0.0.0/0

查看镜像的ID

创建虚拟机

1

root@openstack:~# nova boot --flavor 1 --image cbcc3785-dfe6-4100-9f7c-04be4d8d70bb --key ubuntu12.04

查看虚拟机

1

root@openstack:~# nova show ubuntu12.04(上面创建的)

这个时候,就可以直接 ssh 到虚拟机上。

1

ssh -i .ssh/id_rsa ubuntu@10.0.0.34

这样就可以登录服务器。 七:安装和配置 Dashbaord 1:安装 dashbaord

1

apt-get install libapache2-mod-wsgi openstack-dashboard

这个时候,你就可以登录 dashboard

1 2 3 4

http://192.168.1.2

user:admin

5

pass: admin

具体得看你当前的设置

然后你就可以方便的使用它来管理镜像和虚拟机。

安装多节点

Ubuntu 12.04 Openstack Essex 安装(多节点)

相对于 controller 节点,安装多节点也就是多了 compute 节点,这样 controller 节点仅仅是作为整个云平台的 控件,而所有的实例都是跑在 compute 节点上 具体安装步骤如下:本文档摘自陈沙克博客,其流程我亲自测试,没问题 一:准备要求跟上面一样,尽量用 root 权限用户操作或者 sodo 1:设置网络 /etc/network/interface

auto lo iface lo inet loopback auto eth0 iface eth0 inet static address 10.1.199.18 hwaddress ether 00:25:90:67:ce:0c netmask 255.255.255.0 network 10.1.199.0 gateway 10.1.199.1 dns-search https://www.sodocs.net/doc/3c7152670.html, dns-nameservers 8.8.8.8 auto eth1 iface eth1 inet manual up ifconfig eth1 up

安装 bridge 和 iscsi 相关,虚拟机使用 nova-volume 服务

apt-get -y install open-iscsi open-iscsi-utils bridge-utils

重启网络服务

/etc/init.d/networking restart

2:设置环境变量

cat >/root/novarc <

source novarc echo "source novarc">>.bashrc

2:设置 NTP

apt-get -y install ntp

编辑 /etc/ntp.conf, 指向控制节点的 ntp 服务器

# Use Ubuntu's ntp server as a fallback. #server https://www.sodocs.net/doc/3c7152670.html, server 10.1.199.17 #这个 ip 记住了不是随便填的,是您 controller 节点的 ip

或者运行下面命令

sed -i -e " s/server https://www.sodocs.net/doc/3c7152670.html,/server $CONTROLLER_IP/g" /etc/ntp.conf

二:安装 Openstack 1:安装软件 计算节点,至少是需要安装 nova-api,nova-network,nova-compute,还需要安装 keystone client,

apt-get install -y nova-api nova-compute-kvm

nova-common nova-compute \ \

nova-network

python-nova python-novaclient \ python-keystone python-keystoneclient

2: 编辑 /etc/nova/api-paste.ini , 修改末尾 3 行

#admin_tenant_name = %SERVICE_TENANT_NAME% #admin_user = %SERVICE_USER% #admin_password = %SERVICE_PASSWORD% admin_tenant_name = service admin_user = nova admin_password = password # 这些都是可以改变的,具体需要整个安装过程统一就行

或者运行下面命令,直接复制控制节点的文件过来就可以。

scp root@$CONTROLLER_IP:/etc/nova/api-paste.ini /etc/nova/

3:编辑/etc/nova/nova.conf 文件, 这个文件和控制节点区别不大,就是 vnc 的地方,需要调整一下。

scp root@$CONTROLLER_IP:/etc/nova/nova.conf /etc/nova/nova.conf

修改 vnc 设置

###### NOVNC CONSOLE novnc_enabled=true novncproxy_base_url= http://10.1.199.17:6080/vnc_auto.html

vncserver_proxyclient_address=10.1.199.18 vncserver_listen=10.1.199.18

或者直接使用下面命令实现修改,其实就是用 eth0 的 IP 替换。

sed -i

's/^vncserver_proxyclient_address.*$/vncserver_proxyclient_address='"$(/sbin/ifconfig eth0 | awk '/inet addr/ {print $2}' | cut -f2 -d ":")"'/g'

/etc/nova/nova.conf

sed -i 's/^vncserver_listen.*$/vncserver_listen='"$(/sbin/ifconfig eth0 | awk '/inet addr/ {print $2}' | cut -f2 -d ":")"'/g' /etc/nova/nova.conf

4:设置目录权限

chown -R nova:nova /etc/nova

5:重启服务

service libvirt-bin restart service nova-network restart

service nova-compute restart service nova-api restart

创建一个脚本,这样比较方便。restart.sh

#!/bin/bash a in libvirt-bin nova-network nova-compute \ nova-api ; do service "$a" stop; done for a in libvirt-bin nova-network nova-compute \ nova-api ; do service "$a" start; done

for

root@node18:~# chmod +x restart.sh root@node18:~# ./restart.sh libvirt-bin stop/waiting nova-network stop/waiting nova-compute stop/waiting nova-api stop/waiting libvirt-bin start/running, process 4642 nova-network start/running, process 4662 nova-compute start/running, process 4673 nova-api start/running, process 4688

这时候大功告成。可以运行 nova-manage service list 查看结果 就是这么简单呵呵

OpenStack安装文档

OpenStack Nova安装手册 作者: yz 日期: 2011-11-27 版本: v0.3 网址: https://www.sodocs.net/doc/3c7152670.html,

目录 实验环境 (3) 架构部署 (3) 服务器系统安装 (3) 控制节点安装 (4) NTP时钟服务安装 (4) MYSQL数据库服务安装 (4) RABBITMQ消息队列服务安装 (5) NOVA服务安装 (5) GLANCE镜像存储服务安装 (5) KEYSTONE、noVNC、Dashboard服务相关依赖包安装 (5) KEYSTONE认证服务安装 (5) https://www.sodocs.net/doc/3c7152670.html,PUTE扩展库安装 (8) OPENSTACKX扩展库安装 (8) PYTHON-NOVACLIENT扩展库安装 (8) QUANTUM模块安装 (9) OPENSTACK-DASHBOARD控制面板安装 (9) noVNC服务安装 (11) NOVA服务配置 (12) GLANCE镜像存储服务配置 (14) noVNC服务配置 (15) 计算节点安装 (16) NTP时钟同步配置 (16) NOVA服务安装 (16) NOVA服务配置 (17) DASHBOARD使用基础 (20) 建立Keypairs (20) 建立安全组 (20) 启动实例 (21) 通过VNC连接实例 (22) 为实例分配外网IP (23)

实验环境 硬件: DELL R410(1台) CPU:Intel(R) Xeon(R) CPU E5620 @ 2.40GHz * 2 内存:16GB 硬盘:300GB 网卡:Broadcom Corporation NetXtreme II BCM5716 Gigabit Ethernet * 2 DELL R710(1台) CPU:Intel(R) Xeon(R) CPU E5606 @ 2.13GHz * 2 内存:32GB 硬盘:250GB 网卡:Broadcom Corporation NetXtreme II BCM5709 Gigabit Ethernet * 4 系统: Ubuntu Server 11.04 x64 Openstack版本: Diablo 4 release(2011.3) 架构部署 机器型号/主机名外网IP 内网IP 作用 R410/r410-control1 60.12.206.111 192.168.1.2 控制节点 R710/r710-compute1 60.12.206.99 192.168.1.3 计算节点1 实例网段为10.0.0.0/24,floating ip为60.12.206.114,实例网段桥接在内网网卡上,网络模式采用FlatDHCP 服务器系统安装 1.Ubuntu server 11.04 x64使用默认安装方式 2.服务器外网使用eth0 3.服务器内网使用eth1 4.除apache及noVNC外,所有服务均监听内网IP

openstack安装、配置过程中常见问题及解决办法

openstack安装、配置过程中常见问题及解决办法: by-lilin == 问题一:由于网络节点只有2个物理网卡,当给网络节点配置虚拟子网(10.10.10.52,10.20.20.52)时,无法ping通计算节点网络(10.10.10.53/54/55,10.20.20.53/54/55)== 解决方法: 在网络节点其中一个物理网卡eth0安装虚拟网卡,构建虚拟vlan,实现同一个网卡分配2个不同网段的IP地址(10.10.10.52和10.20.20.52)。 安装步骤如下所示: **安装vlan(vconfig)和加载8021g模块: # aptitude install vlav # modprobe 8021g # lsmod |grep -i 8021q **使用linux cvonfig命令配置vlan(在eth0网卡上虚拟两个vlav端口,端口号为5、7): # vconfig add eth0 5 Added VLAN with VID == 5 to IF -:eth0 # vconfig add eth0 7 Added VLAN with VID == 7 to IF -:eth0 **设置VLAN的REORDER_HDR参数,默认就行了: # vconfig set_flag eth0.5 1 1 Set flag on device -:eth0.5:- Should be visible in /proc/net/vlan/eth0.5 # vconfig set_flag eth0.7 1 1 Set flag on device -:eth0.7:- Should be visible in /proc/net/vlan/eth0.7 **可以使用cat /proc/net/vlan/eth0.5查看eth0.5参数: # cat /proc/net/vlan/eth0.5 eth0.5 VID: 5 REORDER_HDR: 1 dev->priv_flags: 1 total frames received 623 total bytes received 32353 Broadcast/Multicast Rcvd 606 total frames transmitted 71 total bytes transmitted 9420 Device: eth0 INGRESS priority mappings: 0:0 1:0 2:0 3:0 4:0 5:0 6:0 7:0 EGRESS priority mappings:

详解双网卡绑定

Linux下的双网卡绑定bond0 em1 em2 一、什么是bonding Linux bonding 驱动提供了一个把多个网络接口设备捆绑为单个的网络接口设置来使用,用于网络负载均衡及网络冗余 二、bonding应用方向 1、网络负载均衡 对于bonding的网络负载均衡是我们在文件服务器中常用到的,比如把三块网卡,当做一块来用,解决一个IP地址,流量过大,服务器网络压力过大的问题。对于文件服务器来说,比如NFS或SAMBA文件服务器,没有任何一个管理员会把内部网的文件服务器的IP地址弄很多个来解决网络负载的问题。如果在内网中,文件服务器为了管理和应用上的方便,大多是用同一个IP地址。对于一个百M的本地网络来说,文件服务器在多个用户同时使用的情况下,网络压力是极大的,特别是SAMABA和NFS服务器。为了解决同一个IP地址,突破流量的限制,毕竟网线和网卡对数据的吞吐量是有限制的。如果在有限的资源的情况下,实现网络负载均衡,最好的办法就是bonding 2、网络冗余 对于服务器来说,网络设备的稳定也是比较重要的,特别是网卡。在生产型的系统中,网卡的可靠性就更为重要了。在生产型的系统中,大多通过硬件设备的冗余来提供服务器的可靠性和安全性,比如电源。bonding 也能为网卡提供冗余的支持。把多块网卡绑定到一个IP地址,当一块网卡发生物理性损坏的情况下,另一块网卡自动启用,并提供正常的服务,即:默认情况下只有一块网卡工作,其它网卡做备份 三、bonding实验环境及配置 1、实验环境 系统为:CentOS,使用2块网卡(em1、em2 ==> bond0)来实现bonding技术 2、bonding配置 第一步:先查看一下内核是否已经支持bonding 1)如果内核已经把bonding编译进内核,那么要做的就是加载该模块到当前内核;其次查看ifenslave该工具是否也已经编译 modprobe -l bond* 或者modinfo bonding modprobe bonding lsmod | grep 'bonding' echo 'modprobe bonding &> /dev/null' >> /etc/rc.local(开机自动加载bonding模块到内核) which ifenslave 注意:默认内核安装完后就已经支持bonding模块了,无需要自己手动编译 2)如果bonding还没有编译进内核,那么要做的就是编译该模块到内核 (1)编译bonding tar -jxvf kernel-XXX.tar.gz cd kernel-XXX

openstack安装详解

Centos6.4 Openstack 部署 官方推荐环境配置: Step 0: Prerequisites Software:Red Hat Enterprise Linux (RHEL) 6.4, or the equivalent version of one of the RHEL-based Linux distributions such as CentOS, Scientific Linux, etc., or Fedora 19 or later. See also RDO repository info for details on required repositories. Please name the host with a fully qualified domain name rather than a short-form name to avoid DNS issues with Packstack. Hardware: Machine with at least 2GB RAM, processors with hardware virtualization extensions, and at least one network adapter. 看了人家的要求果断放弃6.3,弃暗投明6.4 环境部署:VM+Centos6.4(64bit)(免费的水用谁知道它的好^_^) 看了源代码版的安装虚拟机的一篇配置方法(照抄了)

应用(没用的都关了吧,省的更新一大推没用的,留一个firfox足以) 因为要用到mysql数据库(Mysql全起之,嘿嘿)

某银行系统华为虚拟云桌面项目综合解决方案(完整版)

某银行系统 华为开发虚拟云桌面项目实施方案

目录 1项目概述 (4) 1.1项目背景 (4) 1.2项目目标 (4) 1.3需求分析 (5) 1.4硬件设备清单 (5) 1.5系统方案 (10) 2项目实施方案 (16) 2.1项目施工目标 (16) 2.2施工流程 (17) 2.3责任分工 (20) 2.3.1华为责任范围 (20) 2.3.2客户责任范围 (20) 2.3.3共同责任 (20) 2.3.4责任分工矩阵 (20) 2.4系统网络结构 (21) 2.5方案配置规划 (25) 2.5.1配置规划 (25) 2.5.2部署方案 (30) 2.5.3第三方软件清单(需要用户提供) (33) 2.5.4网络规划 (34) 2.6安全设计方案 (37) 用户名+域密码认证方案 (37) 2.7虚拟机快照备份设计方案 (37) 2.7.1备份需求分析 (37) 2.7.2虚拟机快照备份方案介绍 (38) 2.7.3备份策略设计 (42) 2.7.4备份窗口设计 (43) 2.8实施具体步骤 (43) 2.8.1系统网络准备: (43) 2.8.2华为虚拟化平台的部署: (43) 2.8.3华为桌面云组件的部署: (44) 2.9业务调测和发放 (46) 2.9.1软件调测 (46) 2.9.2模板制作 (46) 2.9.3终端配置 (46) 2.9.4业务发放 (46) 3实施后测试验收计划 (47) 3.1测试验收方案 (47) 3.2测试验收内容 (47)

3.3测试验收流程 (47) 3.3.1货物验收 (47) 3.3.2桌面云系统联机测试验收 (48)

服务器双网卡绑定知识讲解

双网卡绑定实践 Windows平台下常用的双网卡绑定软件有Intel PROSet、NICExpress。本文主要介绍用Intel PROset实现双网卡绑定的方法。 英特尔PROSet 是一个高级的配置实用程序,可用来测试英特尔网络适配器并配置标准和高级功能。通常Intel网卡的驱动包中就包含这个程序,在安装驱动的时候PROSet默认是被安装的。 测试环境: 测试机:R525 G3,Intel双千兆网卡 OS:windows 2003 server 企业版32位 终端:联想笔记本(用于测试服务器双网卡绑定效果) 步骤: 1、打开设备管理器,双击任意一块Intel 82576; 注意R525 G3默认有3块网卡,82574L是管理网口 2、在弹出的配置对话框中,选择分组页面。此时由于系统中的网卡没有进行绑定,因此此

时组下拉列表框是灰色不可选的,单击“新组”; 3、在弹出的“新组向导”对话框中,填写组的名称,下一步; 4、钩选需要绑定的两个网卡,下一步;

5、这里列出了可选择的网卡绑定的模式,常用的是容错和负载平衡。这里我们选择容错,单击下一步; 6、完成向导;

7、此时我们可以看到刚才的分组页面中组的下拉列表中已经有team1; 8、同时弹出的还有team1的属性对话框,单击设置页面,可以看到其中一块网卡状态为“活动”,另一块网卡装状态为“待命”。在此界面中还可进行删除组和修改组的操作,单击“修改组”;

9、在弹出的对话框中,可以设置双网卡的主从关系,如不进行设定,此关系是不固定的。即:当断掉当前活动状态的主网口时,待命的网口将接替主网口的位置,对外提供服务,并成为主网口。当之前断开的网口恢复后,主从关系不会改变,该网口变为待命状态。 10、固定主从关系,设置当前活动的网口为主适配器,待命网口为次适配器;

Openstack搭建

Openstack 云平台配置文档 一基本系统安装 1.Controller: a)硬件: i.CPU: 4核Intel(R) Core(TM) i5 CPU 750 @ 2.67GHz ii.内存:4G iii.硬盘:500G b)系统: Ubuntu11.04 Server 2.Node: a)硬件: i.CPU: 4核Intel(R) Core(TM) i5 CPU 750 @ 2.67GHz ii.内存:4G iii.硬盘:500G b)系统: Ubuntu11.04 Server 二安装Openstack Nova 1.配置网络: a)Controller: i. b)Node: i. 2.配置网桥 a)Controller:

i. ii.重启网络b)Node: i. ii.重启网络

3.NTP同步 a)sudo ntpdate https://www.sodocs.net/doc/3c7152670.html, 4.安装配置数据库(Controller) a)OpenStack Nova 需要数据库的支持,这里选用MySQL i.Sudo apt-get install mysql-server b)修改MySQL绑定地址,以便其他的节点服务器也能访问这个数据库: i.Sudo vi /etc/mysql/my.conf ii.#bind-address=127.0.0.1 -> bing-address =0.0.0.0 iii.Sudo /etc/init.d/mysql restart c)创建一个名为nova的数据库,并设置root从任何IP访问的权限和密码: i.Sudo mysql –uroot –pfdse –e ‘CREATE DATABASE nova;’ ii.Sudo mysql –uroot –pfdse –e “GRANT ALL PRIVILEGES ON *.* TO ‘root’@’%’WITH GRANT OPTION;” iii.Sudo mysql –uroot –pfdse –e “SET PASSWORD FOR ‘root’@’%’= PASSWORD(‘fdse’);” 5.安装Glance镜像服务(Controller) a)Sudo apt-get install glance 6.安装OpenStack Nova a)Controller: i.Sudo apt-get install rabbitmq-server nova-common nova-doc python-nova nova-api nova-network nova-volume nova-objectstore nova-scheduler nova-compute ii.Sudo apt-get install –y euca2ools iii.Sudo apt-get install –y unzip b)Node i.Sudo apt-get install –y nova-compute nova-volume python-nova nova-common vlan ii.Sudo apt-get install –y unzip iii.Sudo apt-get install –y euca2ools

openstack安装及应用碰到的问题

搭建时,创建rabbitmaq用户失败? 这个要看自己的hostname与命令行显示的主机名是否一致。 服务启动失败。 主要检查配置文件是否有错误,还有指定链接是否有问题。 虚拟机反应速度慢? 这个要看BIOS中虚拟化是否开启,在Nova.conf中libvirt下的virt-type=qemu的话不开启虚拟化也是可以建虚拟机的,但是反应速度真的很慢。将BIOS中的虚拟化开启,然后将virt-type=kvm就可以了。(egrep “vmx | svm”/proc/cpuinfo 这个只是显示CPU是否支持虚拟化,但是不是开启虚拟化) 负载均衡lbaas? 首先要安装lbaas的软件包,用yum search lbaas 查看lbaas有哪些软件包,安装以后更改配置文件, /etc/neutron/services/loadbalancer/haproxy/lbaas_agent.ini Linux Bridge interface_driver = neutron.agent.linux.interface.BridgeInterfaceDriver Open vSwitch interface_driver = neutron.agent.linux.interface.OVSInterfaceDriver 选择自己使用的路由方式,填写在default下。 在/etc/neutron/neutron.conf 中default下的service_plugins后加入,neutron_lbaas.services.loadbalancer.plugin.LoadBalancerPluginv2 在 /etc/neutron/neutron_lbaas.conf中service provider下加入service_provider = LOADBALANCERV2:Haproxy:neutron_lbaas.drivers.haproxy.plugin_driver.HaproxyOnHostPluginDr iver:default 。 重启neutron服务(最后用systemctl restart neutron*) 更改/etc/openstack-dashboard/local-settings中的OPENSTACK_NEUTRON_NETWORK选项中的enable_lb 为true。 重启HTTP服务。在dashboard里的网络里就可以看到负载均衡的选项了。

centos7安装配置openstack-kilo(详细部署实施版)

######################################安装service之前##################### 1.安装openstack-selinux和SQL数据库 RHEL and CentOS enable SELinux by default. Install the openstack-selinux package toautomatically manage security policies for OpenStack services: yum install openstack-selinux yum install mariadb mariadb-server MySQL-python 2.配置mariadb:Create and edit the /etc/my.cnf.d/mariadb_openstack.cnf file [mysqld] bind-address = 192.168.142.13 [mysqld] default-storage-engine = innodb innodb_file_per_table collation-server = utf8_general_ci init-connect = 'SET NAMES utf8' character-set-server = utf8 3.重启服务 systemctl enable mariadb.service systemctl start mariadb.service 4.加强mariadb数据库安全,这是root账户密码 mysql_secure_installation 5.安装信息队列

虚拟化云桌面

写在前面的话 这是笔者在进行项目环境部署的时候才用桌面环境图形化操作完成的KVM-SPICE 服务器环境的部署,并获得成功。 如果你要问笔者这个实验有什么意义? 桌面虚拟化技术并不是那么遥不可及,最近的项目涉及到这一部分,所以我就带来一篇文章来讲讲开源的虚拟化技术KVM-QEMU-SPICE来搭建一个虚拟机服务器然后来进行访问。 仍旧属于科普型的小文章,上次一篇文章《走近科学:了解SPICE用户手册》读者觉得没太大用处啊。那么我这次就来写一下Running的部分。 (如果发现笔者文章出现错误欢迎大家指出) 背景知识简介 首先我们要知道SPICE是redhat开发的开源的专门的桌面虚拟化数据传输协议,那么我们很自然的就会想到最容易搭建环境的地方一定是REDHAT系列的linux系统。

Plus:在此之前,笔者试着在ubuntu下搭建spice服务器,网上找了特别多的资料都没成功,然后配合笔者上一篇文章科学上网去安装SPICE服务的时候,出现了各种各样的奇葩的依赖问题,这时候笔者觉得在这样拖下去是绝对不可以的,于是毫不犹豫地投向了centos的怀抱。 下面开始讲一些预备知识,我不想大片大片去粘贴wiki的文章或者是什么并没有卵用的科普性的文章来介绍,我做的如下实验的背景。 关于KVM:KVM呢,简单来说就是一个虚拟化的“系统”,这个系统不是我们平时用的什么win,linux什么的系统,而是一个特定的能完成系统全虚拟化的嵌在linux系统里的可维护的开源的“软件”,那么关于KVM的介绍,我在文章末尾挂出传送门,大家有兴趣可以去了解一下。 关于QEMU:QEMU是可以图形化管理KVM虚拟机的一个工具,专门用来管理KVM的,所以通常都是与KVM同时出现,大家不要见怪。 关于SPICE:SPICE是KVM的C/S模型(如果不懂CS模型是什么,参见server-client模型),专用的数据传输协议。(SPICE相关的科普文章我发在了)其实KVM虚拟化桌面进行云端访问时也是可以使用VNC通道进行数据传输的,然而VNC虽然通用但是效率比起SPICE还是差的源,资源消耗也是非常大,如果你是用KVM-QEMU虚拟机的话,进行云端桌面访问建议使用SPICE协议。 那么我们预备的基础知识就讲完了。

dell服务器双网卡绑定与端口聚合

Broadcom Gigabit Ethernet Adapter Teaming 任何可用的千兆BRODCOM网卡都可以配置为TEAM的一部分.TEAMING是一种将多块千兆BRODCOM网卡绑定作为一个虚拟网卡.好处就是负载均衡. 通过选择每一个可用的千兆BRODCOM网卡并添加它们到负载均衡成员栏来创建TEAM.对于用户和应用程序,只看到一个虚的网卡. 负载均衡组中的成员共享绑定的数据流. 在一个基本的成员区域中,任一个千兆BRODCOM网卡都可以被指定为主成员负责数据流的控制,而指定为备用成员的网卡只有在所有的主 成员网卡都失败时,才开始接管数据流.一旦任一个主成员网卡恢复,数据马上由该主成员控制. 创建teaming包含下列几个步骤: * 打开BASP属性窗口 * 创建teams * 添加网卡到teams * 分配一个IP地址给teamss * 重启机器 BASP是适用于windows2003,windows2000,windowsNT,Redhat Liunx,NetWare的一个broadcom的中介型驱动程 序,需要先安装对应的broadcom网卡驱动程序. 目前它提供了负载均衡;错误冗余;VLAN高级功能,都通过创建teaming来实现. 注意: 一个team可以包含1到8个网卡,每个网卡都可以指定为主成员或备用成员. BASP的负载均衡;错误冗余功能支持与第三方厂商网卡在同一个team中协同工作. BASP FOR Windows 2000 & 20003 & NT提供以下选项: - 支持下列网卡作为故障应急(failover) Alteon AceNic,3COM 10/100 Server adapters;intel 10/1000 server

OpenStack安装配置

OpenStack安装配置篇 OpenStack是一套用来管理虚拟机的平台软件。它不是一个单一的软件,而是集成了很多个组件用来协同合作。简单的来说,譬如有十台服务器,在VMware的情况下,我们在每台服务器上安装esx或者esxi,然后装一台vcenter,在vcenter的管理界面里把十台服务器的esx通过域名或者ip加入,就能在vcenter里面统一管理。类似的,红帽也有virsh 这种管理虚拟机的程序。 在这里我不介绍其他的云平台的管理软件,只是介绍如何从技术角度来使用OpenStack。如果要作为生产环境的话,你还需要考虑更多,譬如架构,网络拓扑,存储的方式,节点的分布等等。 在本篇文章里,我将介绍采用ec2兼容认证的方式。所有组件安装在一台controller 上。 关键字定义 控制端:类似vcenter的管理系统。 节点:类似安装了esx的服务器。 nova组件:安装在节点上,让节点能按照控制端的命令来操作节点上的虚拟机或者存储。 glance组件:用来管理镜像。 环境准备 ubuntu 11.10,服务器双网卡 步骤 安装完基本的操作系统后 $ sudo apt-get update $ sudo apt-get upgrade $ sudo apt-get install bridge-utils #安装网桥软件 配置网络接口

在这里我的架构是eth0连接了外网,即我們可以访问的网口。eth1做了网桥,和节点之间通过一个交换机连接。这样的好处是,内部节点和控制器的流量都走br100的交换机,而不会影响虚拟机上的应用使用的网络。 $ sudo vi /etc/network/interfaces auto eth0 iface eth0 inet static address 192.168.200.21 netmask 255.255.255.0 network 192.168.200.0 broadcast 192.168.200.255 gateway 192.168.200.10 auto br100 iface br100 inet static bridge_ports eth1 bridge_stp off bridge_maxwait 0 bridge_fd 0 address 10.200.200.2 netmask 255.255.255.0 $ sudo /etc/init.d/networking restart 初期准备工作做好,接下来就是要安装关于nova,glance等组件 $ sudo apt-get install -y rabbitmq-server #安装MQ消息組件 $ sudo apt-get install -y python-greenlet python-mysqldb #安装Python dependencies 接下来安装各个nova组件及依赖 $ sudo apt-get install nova-volume nova-vncproxy nova-api nova-ajax-console-proxy $ sudo apt-get install nova-doc nova-scheduler nova-objectstore

openstack部署与管理-fuel介绍

OpenStack部署与管理之 Fuel介绍 成胜 汉柏科技有限公司

内容 Fuel简介 Fuel架构 Fuel功能 Fuel扩展 2

OpenStack部署 OpenStack发展很猛,很多朋友都很认同,为了解决OpenStack部署的问题,让安装,配置变得更加简单易用,很多公司都投入人力去做这个。说到部署,肯定和OS有关,对于OpenStack来说,无非就是Ubuntu还是CentOS,当然也会和OpenStack版本有关。 其实部署工具,最麻烦的地方,不是软件的配置和安装,而是网络。用户的网络情况太多,还有OpenStack本身的网络也很复杂。

部署工具: RDO: REDHAT出品,支持Redhat、CentOS等系统。RDO基于puppet部署各个组件,支持单节点或多节点部署,在Redhat系操作系统上使用非常方便。 devstack: 这个应该是最老的Fuel简介了,可以用来快速部署一个OpenStack测试环境,基于git最新代码部署服务,并将所有服务都起在screen中,不适合生产环境直接使用。 Fuel: Mirantis出品,支持在ubuntu和centos上通过web界面配置并部署OpenStack,应该是目前最为直观的Fuel简介。支持自动发现部署节点,并部署 OpenStackHA,对OpenStack作健康检查等。

Mirantis 一家很牛逼的OpenStack服务集成商,他是社区贡献排名前5名中唯一一个靠软件和服务吃饭的公司(其他分别是Red Hat, HP, IBM, Rackspace)。相对于其他几个社区发行版,Fuel的版本节奏很快,平均每两个月就能提供一个相对稳定的社区版。

云桌面建议方案

XX单位虚拟桌面解决方案建议书

目录 1 现状与需求分析........................................错误!未定义书签。 现状分析......................................错误!未定义书签。 用户需求分析..................................错误!未定义书签。 任务型用户............................... 错误!未定义书签。 知识型用户............................... 错误!未定义书签。 交付方式选型..................................错误!未定义书签。 任务型用户............................... 错误!未定义书签。 知识型用户............................... 错误!未定义书签。 方案目标与收益................................错误!未定义书签。 2 虚拟桌面方案总体概述..................................错误!未定义书签。 虚拟桌面交付架构总体介绍......................错误!未定义书签。 虚拟桌面交付技术介绍..........................错误!未定义书签。 流桌面................................... 错误!未定义书签。 独占桌面................................. 错误!未定义书签。 虚拟桌面交付产品介绍..........................错误!未定义书签。 桌面虚拟化............................... 错误!未定义书签。 服务器虚拟化............................. 错误!未定义书签。 3 详细设计..............................................错误!未定义书签。 逻辑架构设计..................................错误!未定义书签。 数据中心逻辑架构设计..................... 错误!未定义书签。 用户接入逻辑架构设计..................... 错误!未定义书签。 详细架构设计..................................错误!未定义书签。 数据中心详细架构设计..................... 错误!未定义书签。 用户接入详细架构设计..................... 错误!未定义书签。

iso安装openstack虚拟机

Openstackiso安装实例 用户指南 上海天玑科技股份有限公司 二零一五年十二月 版权所有? 2015 上海天玑科技股份有限公司。保留一切权利。 非经本公司书面许可,任何单位和个人不得擅自摘抄、复制本文档内容的部分或全部,并不得以任何形式传播。

商标声明 玑云均为上海天玑科技股份有限公司的注册商标。本文档提及的其他所有商标或注册商标,由各自的所有人拥有。 注意 您购买的产品、服务或特性等应受天玑公司商业合同和条款的约束,本文档中描述的全部或部分产品、服务或特性可能不在您的购买或使用范围之内。除非合同另有约定,天玑公司对本文档内容不做任何明示或默示的声明或保证。 由于产品版本升级或其他原因,本文档内容会不定期进行更新。除非另有约定,本文档仅作为使用指导,本文档中的所有陈述、信息和建议不构成任何明示或暗示的担保。 上海天玑科技股份有限公司 地址:上海市桂林路406号2号楼11-12层 网址:https://www.sodocs.net/doc/3c7152670.html, 邮箱:support@https://www.sodocs.net/doc/3c7152670.html, 24小时服务热线:400-820-2885 800-820-2885 前言 读者对象 本指南介绍了,在没有完整的镜像模板时,如何通过iso镜像在openstack平台中去创建虚拟机 本文档(本指南)主要适用于以下读者对象: ? 技术支持工程师 ? 系统管理员 ? 普通用户 符号约定 在本文中可能出现下列标志,它们所代表的含义如下。

表示有高度或中度潜在危险,一定会引起系统错误。 表示有潜在风险,可能会引起系统错误;或是需要引起用户注意的 地方 以本标志开始的文本能帮助您解决某个问题或节省您的时间。 以本标志开始的文本是正文的附加信息,是对正文的强调和补充。 修订记录 修改记录累积了每次文档更新的说明。最新版本的文档包含以前所有文档版本的更新内容。 文档版本01 (2015-08-20) 第一次正式发布。

虚拟化云桌面安装手册

VMware View 安装手册 2017年4月10日星期一

目录 VMware View 虚拟桌面安装手册_____________________________ 错误!未定义书签。 第1节环境准备__________________________________________ 错误!未定义书签。 基础架构:__________________________________________________ 错误!未定义书签。 组件:______________________________________________________ 错误!未定义书签。 VMwareView体系结构图________________________________________ 错误!未定义书签。 第2节vSphere 安装和配置 _______________________________ 错误!未定义书签。 安装vSphere 有两种方式:________________________________ 错误!未定义书签。 按下“F11” ______________________________________________ 错误!未定义书签。 选择默认“US Default"_____________________________________ 错误!未定义书签。 输入root 密码____________________________________________ 错误!未定义书签。 直接按“F11”选择“Install”______________________________ 错误!未定义书签。 选择“reboot(重启)”____________________________________ 错误!未定义书签。 等待重启完后,进入VMware ESXI 界面。____________________ 错误!未定义书签。 配置管理网络 _____________________________________________ 错误!未定义书签。 选择“IP Address ”_______________________________________ 错误!未定义书签。 第3节vSphere Client的安装______________________________ 错误!未定义书签。 下载vSphere Client客户端_________________________________ 错误!未定义书签。 打开“VMware vSphere Client”_____________________________ 错误!未定义书签。 进入 esxi 主机管理界面____________________________________ 错误!未定义书签。 第4节安装dc虚拟机 _____________________________________ 错误!未定义书签。 创建虚拟机dc _____________________________________________ 错误!未定义书签。 单击“新建虚拟机”________________________________________ 错误!未定义书签。 第5节在虚拟机VC内安装 Windwos 2008 R2 __________________ 错误!未定义书签。

网卡绑定教程

intel、博康、Marvell、NF网卡的动态负载均衡设置 部分内容由网上摘抄修改 Marvell网卡绑定教程 控制台及驱动下载:https://www.sodocs.net/doc/3c7152670.html,/product.aspx?P_ID=4zanuPTONhbnijk4 https://www.sodocs.net/doc/3c7152670.html,/pub/ASUS/mb/socket775/P5BV-C/DRIVER/CPA_Win32_56423.zip 控制台和驱动的安装就不说了,一直下一步就可以了! 现在打开控制台软件:

单击“add team”按钮,弹出下面窗口: 注:"teaming mode"选择"static"

OK分组"BOOT"创建完毕: 最后将网卡添加进刚刚建立的BOOT分组即可:

4网卡汇聚最终图:

NF网卡绑定教程 https://www.sodocs.net/doc/3c7152670.html,/Windows/nForce/9.28/9.28_nforce_winserv2003_32bit_international_whql.exe 下载解压,网卡驱动在Ethernet目录,网卡绑定软件在\Ethernet\NAM目录。 安装好之后,运行开始菜单的NVIDIA Corporation\NVIDIA Control Panel\networking项 显示如下界面,单击“Adjust teaming configuration”项

可以选择“use default teaming configuration”自动按默认设置组。 也可以选择“use custom teaming configuration”,弹出引导设置窗口。 选择自动负载均衡及容错“Load Balance and Failover”模式,点击下一步

云计算平台OpenStack学习教程

云计算平台OpenStack 学习教程 OpenStack 是一种免费的开源平台,帮助服务提供商实现类似于亚马逊EC2 和S3 的基础设施服务。OpenStack 当前有三个核心项目:计算(Nova),对象存储(Swift),镜像管理(Glance)。每个项目可以独立安装运行,该文档将帮助您快速学习OpenStack。

目录 OpenStack 背景现状 (3) OpenStack 是什么? (3) OpenStack 核心项目 (3) OpenStack 版本信息 (4) OpenStack 功能 (4) OpenStack 架构 (5) OpenStack 项目架构一: C ompute(Nova)的软件架构 (5) Nova 组件的作用 (6) Nova 的硬件架构 (7) Nova 功能介绍 (9) OpenStack 项目架构二: Swift 架构 (9) Swift 功能 (9) OpenStack 项目架构三– Glance 架构 (10) Glace 组件架构 (10) Glace 组件架构特性 (10) OpenStack 功能 (11) Openstack 创建i nstance 的流程 (11) OpenStack 在企业中的应用 (14)

OpenStack 背景现状 OpenStack 是由Rackspace Cloud 和NASA(美国航天局)于2010 年7 月开始共同开发支持, 整合了Rackspace 的Cloud Files platform 和NASA 的Nebula platform 技术,目的是能为任何一个组织创建和提供云计算服务。 目前,超过150 家公司参与了这个项目,包括Crtrix Systems, Dell, AMD, Intel, Cisco, HP 等。OpenStack 最近发布了Austin 产品,它是第一个开源的云计算平台,它是基于Rackspace 的 云服务器加上云服务,以及NASA 的Nebula 技术发布的。似乎是作为对此的响应,Amazon 为新用户提供一年的AWS免费使用方式。在OpenStack 发布Austin 之后,微软也宣称Windows Server 2008 R2 Hyper-V 可以与OpenStack 整合。微软会为https://www.sodocs.net/doc/3c7152670.html, 提供架构和 技术上的指引,它会编写必要的代码,从而OpenStack 能够在微软的虚拟平台上运行。 这些代码会在https://www.sodocs.net/doc/3c7152670.html, 上提供。 OpenStack 是什么? OpenStack 核心项目 OpenStack 是一种免费的开源平台,帮助服务提供商实现类似于亚马逊EC2 和S3 的基础设施服务。OpenStack 当前有三个核心项目:计算(Nova),对象存储(Swift),镜像管理(Glance)。每个项目可以独立安装运行。另外还有两个新增项目:身份验证(Keystone)和仪表盘(Horizon)。 OpenStack 计算是一个云控制器,用来启动一个用户或一个组的虚拟实例,它也用于配置每 个实例或项目中包含多个实例为某个特定项目的联网。 OpenStack 对象存储是一个在具有内置冗余和容错的大容量系统中存储对象的系统。对象存 储有各种应用,如备份或存档数据,存储图形或视频(流媒体数据传输到用户的浏览器), 储存二级或三级静态数据,发展与数据存储集成新的应用程序,当预测存储容量困难时存储 数据,创造弹性和灵活的云存储Web 应用程序。 OpenStack 镜像服务是一个查找和虚拟机图像检索系统。它可以配置三种方式:使用OpenStack 对象存储来存储图像;使用亚马逊S3 直接存储,或使用S3 对象存储作为S3 访问 中间存储。

相关文档

- (完整版)虚拟化云桌面方案测试报告

- 桌面云平台方案(云桌面)

- 某银行系统华为虚拟云桌面项目综合解决方案(完整版)

- 云桌面虚拟化方案

- 虚拟化云桌面安装手册

- 桌面虚拟化(云桌面办公系统)解决方案..

- 桌面虚拟化(云桌面办公系统)解决方案.. 共50页

- 叶子云桌面虚拟化使用说明书。

- 某银行系统华为虚拟云桌面项目综合解决方案(完整版)

- 桌面虚拟化云桌面办公系统解决方案51页PPT

- 云桌面虚拟化项目解决方案

- 华为虚拟化和桌面云解决方案ppt课件

- 云桌面建议方案

- 桌面虚拟化(云桌面办公系统)解决方案

- 云桌面(Dass)IDC解决方案

- 桌面虚拟化(云桌面方案)实施分析报告

- (完整版)虚拟化云桌面方案测试报告

- 某银行系统虚拟云桌面项目综合解决方案(完整版)

- 虚拟化云桌面方案测试报告.doc

- 虚拟化云桌面方案测试报告