Storm 的云计算在自动清分系统中的实时数据处理应用

一一收稿日期:2013-11-13;修回日期:2014-01-26三

一一作者简介:胡宇舟(1963-),男,湖南郴州人,高级工程师,博士,主要研究方向:云计算二信息管理系统;一范滨(1982-),男,山西太原人,工程师,主要研究方向:云计算二大数据处理;一顾学道(1939-),男,上海人,教授,博士,主要研究方向:云计算二通信系统;一缪力(1972-),男,湖南长沙人,副教授,博士,主要研究方向:云计算二程序分析三

文章编号:1001-9081(2014)S1-0096-04

基于Storm 的云计算在自动清分系统中的实时数据处理应用

胡宇舟1,范一滨1,顾学道2*

,缪一力2

(1.高新现代智能系统股份有限公司产品研发部,广东深圳518057;一2.高新现代智能系统有限股份公司博士后科研工作站,广东深圳518057)

(*通信作者电子邮箱guxuedao@126.com)

摘一要:针对轨道交通行业客流量逐年增大而带来的大数据问题,提出了采用Strom 云计算技术解决该问题的方法,并证明了云计算技术完全适用于轨道自动交通售检票(AFC )清分系统(ACC ),探讨了基于Storm 云计算在处理清分系统处理实时数据业务中的应用三实践表明,基于Storm 的云计算完全适用于轨道交通售检票清分系统的处理实时数据业务,成本低,容错好,运行稳定,效率高,硬件投资仅占单台服务器的十分之一,其扩展性与容错性均优于单台服务器三

关键词:Storm ;云计算;自动清分系统;大数据;轨道交通中图分类号:TP183一一文献标志码:A

Applicationofreal-timedataprocessingservicesin

automaticclearingcollectionsystembasedoncloudcomputingforStorm

HU Yuzhou 1,FAN Bin 1,GU Xuedao 2*

,MIAO Li 2

(1.Product Development Department,GaoXin Modern Intelligent System Corporation Limited,Shenzhen Guangdong 518057,China ;

2.Postal Doctor Program,GaoXin Modern Intelligent System Corporation Limited,Shenzhen Guangdong 518057,China )

Abstract:According to big data problem caused by yearly increased rail transit passenger flow,the paper presented a

method adopting Storm cloud computing technology to solve this problem,verified that cloud computing technology is suitable for rail transit Automatic Fare Collection (AFC)system and Automatic Clearing Collection (ACC)system,and discussed cloud computing application in processing real-time data of ACC.Practice indicates that cloud computing based on Storm is totally suitable for real-time data processing in rail transit ACC system with lower cost,better fault tolerant capability,stable

operation as well as higher efficiency.Its hardware investment covers only a tenth of single server,but its expansibility and

fault tolerance are both superior to single server.

Keywords:Storm;cloud computing;Automatic Clearing Collection (ACC)system;big data;rail traffic

0一引言

用云计算处理大数据被公认为是最有效的方式三目前大

数据量处理平台有Twitter 的Storm,Yahoo!的S4,Apache 的Storm,UC Berkeley AMPLab 的Spark,NokiaDisco,LexisNexis

的HPCC 等三其中Storm 和S4采用流处理,适用实时业务;其余的均为批处理,适用非实时业务三

为了解决交通拥堵,实现绿色出行,各城市都在建设包括地铁在内的轨道交通,轨道交通网络覆盖面越来越广,乘坐轨道交通的客流量也逐年增大,大数据处理问题日趋明显三其中轨道交通行业的自动清分(Automatic Clearing Collection,ACC)系统承担着线网化运营的管理工作,是线网化的数据中心,并承担着多运营商和多线路的清分功能,是轨道交通的行业核心系统;ACC 系统的数据可分为实时数据和非实时数据,其中实时数据处理选用了Storm三本文阐述在ACC 系统中采用基于Storm 云计算处理实时数据的系统设计和测试结果三

1一适用于ACC 系统数据处理的云计算

1.1一清分系统受单台服务器的限制

清分系统的主要特征是数据量大二持续计算与实时反馈

等三现在的清分系统都运行在单台服务器上,主要受到以下的一些限制:

1)存储量大小的限制:单台服务器的存储量是有限的,

随着时间的推移,清分系统的数据量会不断地增长三虽然可以通过删掉历史数据来减少数据的存储,但是只是折中方案,

毕竟每份数据都有它的价值三

2)异常中断的限制:虽然清分系统有容错备份,但也会遇到系统宕机三系统一旦出现异常,就会停止,这对于要求实时反馈的清分系统是不能容忍的三

3)服务器性能的利用限制:清分系统虽然要求持续计算

和实时反馈,但是极大多数是数据去重二分拆二组合等操作,计算工作量不大三清分系统运行在大型服务器上,没有充分发挥大型服务器的性能三

高性能二高可用二可扩展的云计算正是解决以上问题的最好的解决方案三

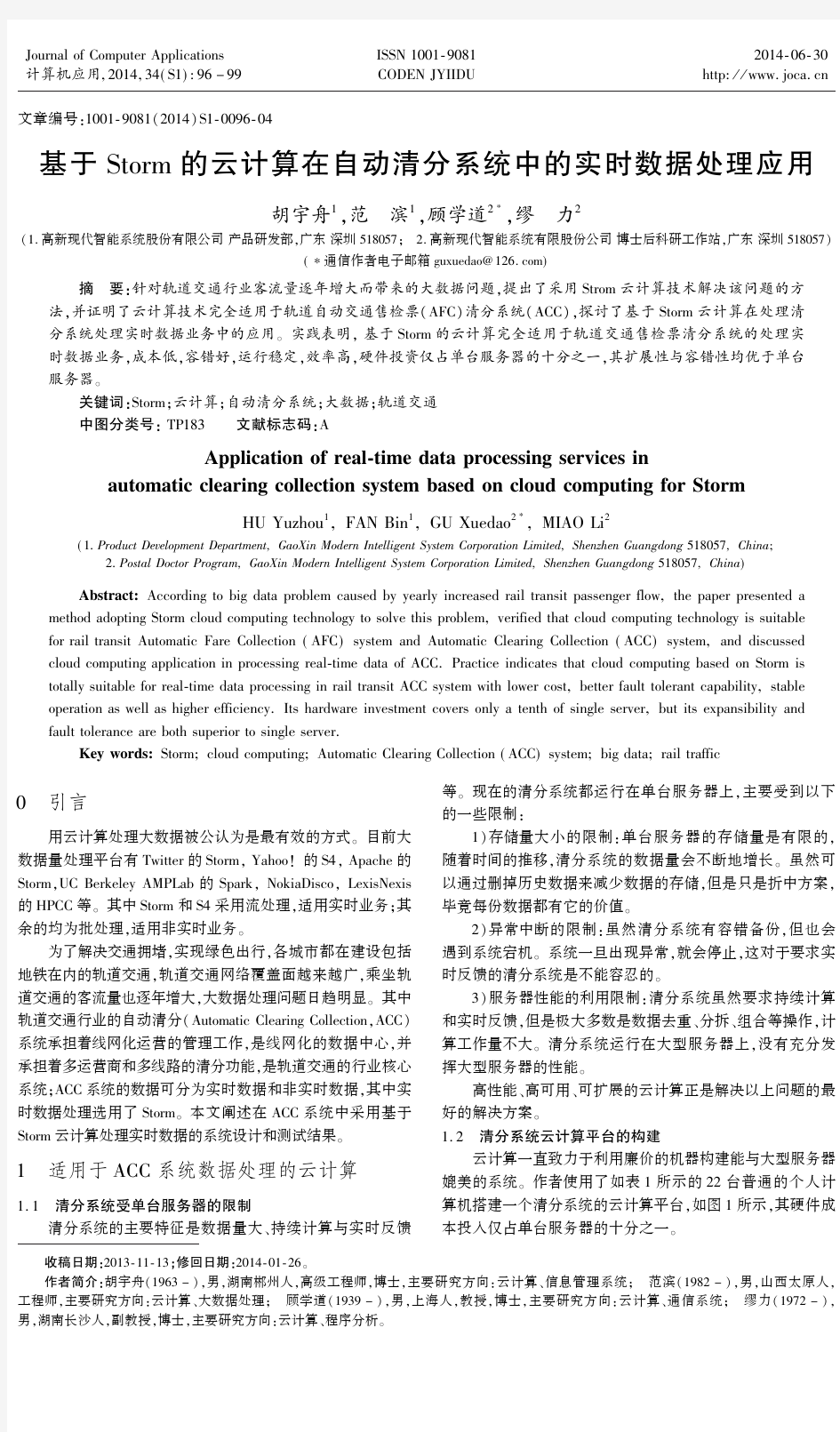

1.2一清分系统云计算平台的构建

云计算一直致力于利用廉价的机器构建能与大型服务器

媲美的系统三作者使用了如表1所示的22台普通的个人计算机搭建一个清分系统的云计算平台,如图1所示,其硬件成本投入仅占单台服务器的十分之一三

Journal of Computer Applications 计算机应用,2014,34(S1):96-99一

ISSN 1001-9081

CODEN JYIIDU 一

2014-06-30

http://www.joca.cn

表1一清分系统下的云计算平台的硬件设备配置表部件配置数量价格/元CPU酷睿i74700主频:3.9GHz12020

内存金士顿8GB DDR316002900

硬盘希捷Barracuda1TB72001400

主板技嘉GA-G41MT-S2PT1450

合计3770 22台表1配置的机器,总价不会超过十万元人民币,同时需要工作在万兆以太网的环境,硬件成本大大降低三需要说明的是:为了使系统可用,作者还开发一套云计算平台管理界面,如显示存储空间的利用率等三由于篇幅限制,这里不再赘述

三

图1一清分系统云计算平台构成

1.3一清分系统云计算平台性能测试

清分系统主要处理的是数据去重二数据合并二客流统计二

清分结算等三实际数据处理是一万行作为一个文件,每五分

钟以内向云计算平台发送数据三表2中的数据代表每处理一

万行记录的时间三由于云计算把计算任务分散到每台机器中

执行,所以计算时间不会递增很快,而递增的时间,主要消耗

在数据去重时查找数据的时间三

表2一清分系统下云计算平台性能测试统计表

文件数累积大小处理时间/s

12.5MB17

1025MB17

100250MB17

5001.25GB18

10002.5GB18

200050GB20

4000100GB20

这种计算性能,和运行在单台服务器上的清分系统性能

非常接近了,而成本却大大降低,显示出云计算平台的优势三

1.4一清分系统高可用性的实现

清分系统是一个实时服务系统,需要不断计算由通信系

统发来的数据三如果清分系统出问题或宕机,交易数据就会

累积,而且不能实时反馈客流数据,这是不能容忍的三云计算

采用副本备份容错二心跳检测和计算节点同构可互换等措施

来保障服务的高可用性三

每一份数据在云计算平台下,都会有几份副本分别存储

在不同的机器中,即使一台机器宕机,不会影响系统的正常运

行三云计算平台通过副本冗余机制,解决了高可用的问题,使

清分系统能够提供实时的数据处理,而不会出现中断三当某

台机器出现问题或宕机时,清分系统向运维人员发送邮件或

短信,及时通知他们检修三云计算的高可用性还体现在把集

群内的机器部署在几个机房,只要机房不同时出现断电情况,

不会影响清分系统的运行三

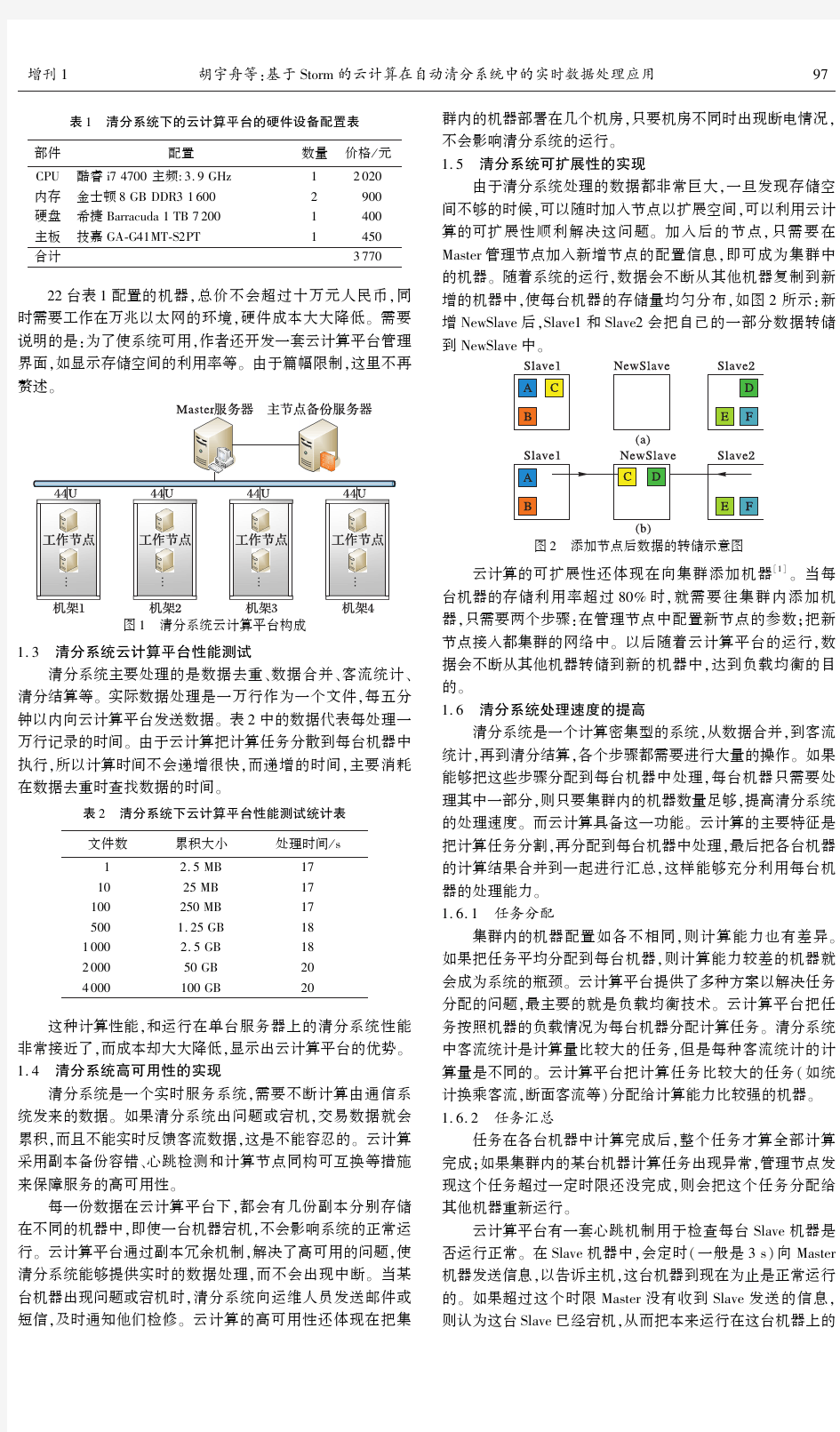

1.5一清分系统可扩展性的实现

由于清分系统处理的数据都非常巨大,一旦发现存储空

间不够的时候,可以随时加入节点以扩展空间,可以利用云计

算的可扩展性顺利解决这问题三加入后的节点,只需要在

Master管理节点加入新增节点的配置信息,即可成为集群中

的机器三随着系统的运行,数据会不断从其他机器复制到新

增的机器中,使每台机器的存储量均匀分布,如图2所示:新

增NewSlave后,Slave1和Slave2会把自己的一部分数据转储

到NewSlave中

三

图2一添加节点后数据的转储示意图

云计算的可扩展性还体现在向集群添加机器[1]三当每

台机器的存储利用率超过80%时,就需要往集群内添加机

器,只需要两个步骤:在管理节点中配置新节点的参数;把新

节点接入都集群的网络中三以后随着云计算平台的运行,数

据会不断从其他机器转储到新的机器中,达到负载均衡的目

的三

1.6一清分系统处理速度的提高

清分系统是一个计算密集型的系统,从数据合并,到客流

统计,再到清分结算,各个步骤都需要进行大量的操作三如果

能够把这些步骤分配到每台机器中处理,每台机器只需要处

理其中一部分,则只要集群内的机器数量足够,提高清分系统

的处理速度三而云计算具备这一功能三云计算的主要特征是

把计算任务分割,再分配到每台机器中处理,最后把各台机器

的计算结果合并到一起进行汇总,这样能够充分利用每台机

器的处理能力三

1.6.1一任务分配

集群内的机器配置如各不相同,则计算能力也有差异三

如果把任务平均分配到每台机器,则计算能力较差的机器就

会成为系统的瓶颈三云计算平台提供了多种方案以解决任务

分配的问题,最主要的就是负载均衡技术三云计算平台把任

务按照机器的负载情况为每台机器分配计算任务三清分系统

中客流统计是计算量比较大的任务,但是每种客流统计的计

算量是不同的三云计算平台把计算任务比较大的任务(如统

计换乘客流,断面客流等)分配给计算能力比较强的机器三

1.6.2一任务汇总

任务在各台机器中计算完成后,整个任务才算全部计算

完成;如果集群内的某台机器计算任务出现异常,管理节点发

现这个任务超过一定时限还没完成,则会把这个任务分配给

其他机器重新运行三

云计算平台有一套心跳机制用于检查每台Slave机器是

否运行正常三在Slave机器中,会定时(一般是3s)向Master

机器发送信息,以告诉主机,这台机器到现在为止是正常运行

的三如果超过这个时限Master没有收到Slave发送的信息,

则认为这台Slave已经宕机,从而把本来运行在这台机器上的

79增刊1胡宇舟等:基于Storm的云计算在自动清分系统中的实时数据处理应用一一一一

任务转移到其他的机器上运行三

清分系统中数据去重操作是比较典型的需要做汇总的操作三每一条数据都需求查找数据仓库中是否已经存在三在云计算下会把部分任务发送到不同的机器中查找,然后反馈结果到主机器中三如果某个任务计算失败,该任务会重新分配到其他的机器中执行,直到确定这条记录是否已经存在为止三

本文经过云计算平台的试验,认为目前轨道交通自动售检票的清分系统完全可以用廉价的个人计算机构成的云计算平处理,成本大为降低三

2一Storm 在清分系统实时数据的处理结果[2]

Storm 的使用关键是如何设计拓扑结构,只需要把清分系

统交易数据读取到Storm 中,再按照拓扑结构把数据分发到每台机器中处理,所以机器的数量决定了整个系统的处理能

力,当处理能力不够时可以增加机器三

本章主要阐述Storm 框架下清分系统的组成二架构设计二和性能测试等内容三

2.1一系统组成Storm 是一个实时分布式计算框架,并没有提供分布式存

储功能,所以在清分系统中使用MySQL作为数据库三原系统是采用Oracle 数据库,所以不存在数据迁移问题三

系统组成示意图如图3所示,试验系统达到如图1所示的22台机器,图中共有三种节点:Nimbus 节点二Supervisor 节点和MySQL节点三Nimbus 节点是Storm 框架的管理节点,负责把任务发送到每台机器中执行,相当于Hadoop 中的namenode 节点[3],但是不存在单点故障问题三如果Nimbus 节点宕机,系统还能正常运行,只是无法进行任务调度三Supervisor 节点是具体的工作节点,负责计算由Nimbus 节点分发的任务,相当于Hadoop 中的datanode 节点[3]三MySQL

节点是数据存储节点,接收来自各个Supervisor 节点发送的数据三为了避免数据库宕机导致的数据丢失问题,并实现系统的高可用性,MySQL采用经典的主从复制架构,可以减轻数据的写入和读取的负担

三

图3一清分系统Storm 架构组成示意图

2.2一体系架构设计

Storm 下的清分系统可以分为三层架构:数据源层二数据

处理层和持久层三如图4所示,其中数据源层由Spout 组件负责,数据处理层由Bolt 组件负责

三

图4一Storm 下的体系架构示意图

2.2.1一数据源层

Storm 框架有明确的分层架构:Spout 和Bolt,前者负责读

数据,后者负责计算任务三Spout 把任务发送给Bolt 后,任务就结束了,后台的守护线程AckTask 负责跟踪任务到达Bolt 后是否执行成功三Storm 是一个可靠的数据处理框架三

Spout 组件中需要把从通信系统传送过来的数据进行格

式化,并负责异常检查二数据去重等操作,最后把完整的二正常的交易数据发送到Bolt 中,如图5所示

三

图5一Spout 组件处理过程

2.2.2一数据处理层

数据处理由Storm 框架的Bolt 组件负责三从Spout 发送

任务到Bolt 中有很多种分组方式,如直接分组二随机分组二广播分组等三由于清分系统比较简单,不需要复杂的分组方式,只需要把任务发散到各台机器中执行,所以采用比较简单的随机分组方式三

数据处理组件主要计算清分系统中实时性要求比较高的客流统计数据,数据统计完成后,把客流数据批量插入到数据库中三插入完成后,AckTask 守护线程会通知Storm 框架,该任务已经完成,可以结束了三处理过程如图6所示

三

图6一Bolt 组件处理过程

2.2.3一持久层

持久层采用MySQL作为数据库三为了保证高可用性,系

统采用多台MySQL并设计为主从复制架构三考虑到数据最后需要作关联查询,最后需要把数据进行汇总三数据库关系图如图7所示三图中双向箭头的机器都是互为主从结构的机器,最后一台机器为数据汇总机器三这种架构实现了读写分离,有效减轻了清分系统中频繁的数据插入,并且数据汇总后,数据可以进行各种关联查询

三

图7一MySQL集群关系图

2.3一性能测试

Storm 下的测试内容和Hadoop 的是一样的[3]都是采用每

一万行作为一个文件,传入Storm 中进行处理三为了节省时间,把文件传入的时间间隔为30s三每行记录用制表符把每

个字段值分割开三

测试方法是每30s 往系统中传入一个一万行记录的文件,大小为2.5MB三让系统连续运行,以观察系统的稳定性三

清分系统实时数据主要包括客流数据二票卡及票库数据,设备状态数据和运营模式数据以及联机数据等三

试验系统共测试了700万的实时数据插入,性能走向图

89一一一一

计算机应用第34卷

如图8所示三图中最低点为22s,最高点为67

s三

图8一Storm 下的清分系统性能走向图

图8中有突起的部分,是由于机器测试的过程中进行了其他的操作,系统资源被占用才导致计算时间变长三图中的数据还是有上升的趋势,分析原因后是由于随着数据量的增大,去重的时间会变长三

传统的数据去重是一个全局搜索的过程,但是清分系统数据量巨大的场景下,如果想要快速去重,不能再去查找数据库,而需要一种针对该问题的数据结构 Bloom Filter三关于该部分的内容会另文再述三

3一结语

轨道交通行业清分系统的主要特征是数据量大和要求持

续计算与实时反馈等三运行在传统的单台大中型服务器上的清分系统,主要受到存储量大小和异常中断的限制,没有充分利用服务器性能三因为清分系统虽然要求持续计算和实时反馈,但是计算工作量不是很大,没有充分利用大中型服务器的性能,这对服务器是一种极大的浪费三

清分系统处理的数据,都是以万行记录作为文件数据三一个计算过程就是对这万行记录进行操作,包括数据合并二客流统计二清分结算等三而这些计算工作量并非很大,完全可以在普通PC 上完成,只要把这些计算任务都分散到每台机器中执行三因此,分布式云计算的架构是非常适合清分系统的业务处理三一一经过试验系统的搭建和数据迁移,试验系统的稳定运行和相关数据,表明基于Strom 云计算搭建而成的低成本PC 集群平台整体性能与单台服务器性能相近,其硬件投资仅占单台服务器的十分之一,并可通过扩展PC 来增强其整体的计算性能,其扩展性与容错性均优于单台服务器,并更适合解决

轨道交通的大数据问题,适用于售检票清分系统的实时数据处理业务三参考文献:

[1]一辛大欣,刘飞.Hadoop 集群性能优化技术研究[J].电脑知识与

技术,2011,7(22):5484-5486.

[2]一范滨.Storm 使用总结[R].深圳:高新现代智能系统股份有限公

司技术报告,2013.

[3]一胡宇舟.基于Hadoop 的云计算在清分系统中批处理数据应用[R].深圳:高新现代智能系统股份有限公司,2013.

[4]一刘鹏.云计算[M].2版.北京:电子工业出版社,2011.

[5]一雷万云.云计算 技术二平台及应用案例[M].北京:清华大学出版社.2011.

[6]一姚宏宇,田溯宁.云计算:大数据时代的系统工程[M].北京:电

子工业出版社,2013.[7]一周洪波.云计算:技术二应用二标准和商业模式[M].北京:电子工业出版社,2011.

[8]一RHOTON J.云计算:企业实施手册[M].朱丽,姜怡华,等译.

北京:机械工业出版社,2011.

[9]一徐强,王振江.云计算:应用开发实践[M].北京:机械工业出版

社,2012.

[10]一(英)迈尔-舍恩伯格,(英)库克耶.大数据时代[M].盛杨燕,

周涛,等译.杭州:浙江人民出版社,2013.[11]一FRANKS B.驾驭大数据[M].黄海,车皓阳,王悦,译.北京:人民邮电出版社,2013.

[12]一郭晓科.大数据[M].北京:清华大学出版社,2013.

(上接第95页)

一一从实验的结果可以看出,本文算法MRCDA (基于MapReduce 模型的OBB 碰撞检测算法)虽然在时间复杂度与其他算法相比并没有改善,但是在运行帧频和运行速度上有着明显的优势三这是因为检测过程在并行模型MapReduce 下分布式地运行三

5一结语

碰撞检测的速度是历来研究的一个热点问题,本文分析

了碰撞检测的效率问题,并通过研究云计算和层次包围盒的相关技术提出了一种基于MapReduce 的OBB 碰撞检测算法,从而提高检测的速度三但是,实验结果是在各个节点计算能力和网络传输能力基本相同的环境下研究的,对于复杂的异构环境研究还有待进一步的探索三参考文献:

[1]一SMITHA,KITAMURA Y,TAKEMURA H,et al.A simple and ef-ficient method for accurate collision detection among deformable pol-yhedral objects in arbitrary motion[C]//VRAIS'95:Proceedings of

the Virtual Reality Annual International Symposium.Washington,DC:IEEE Computer Society,1995:136-145.

[2]一王志强,洪嘉振,杨辉.碰撞检测问题研究综述[J].软件学报,1999,10(5):545-549.

[3]一石教英.虚拟现实基础及使用算法[M].北京:科学出版社,

2002.

[4]一DEAN J,GHEMAWAT S.MapReduce:simplified data processing

on large clusters [C]//OSDI2004:Proceedings of the 6th Confer-

ence on Symposium Opearting Systems Design &Implementation.Berkeley:USENIXAssociation,2004,6:10-10.[5]一边美玲,任建平.包围盒碰撞检测技术的研究[J].机械管理开发,2008(2):27-28.

[6]一马登武,孙隆和,佟明安.虚拟场景中的碰撞检测算法[J].火力

与指挥控制,2004,29(4):45-48.

[7]一GOTTSCHALK S,LIN M,MANOCHA D.OBB-trees:a hierarchi-cal structure for rapid interference detection[C]//SIGGRAPH'96:Proceedings of the 23rd Annual Conference on Computer Graphics

and Interactive Techniques.New York:ACM,1996:171-180.[8]一王冬冬,王琰,祁燕.基于树状层次有向包围盒的碰撞检测算法[J].沈阳理工大学学报,2006,25(5):13-15.[9]一魏迎梅,吴泉源,石教英.虚拟环境中的碰撞检测方法[J].计算机工程与科学,2001,23(2):44-47.

[10]一张德丰.云计算实战[M].1版.北京:清华大学出版社,2012.

[11]一COHEN J D,LIN MC,MANOCHA D,et al.I-COLLIDE:An

interactive and exact collision detection system for large-scale envi-

ronments[C]//I3D'95:Proceedings of the 1995Symposium on In-teractive 3D Graphics.New York:ACM,1995:189-196.[12]一RITTER J.An efficient bounding sphere [M]//Graphics Gems.

San Diego:Academic Press,1990:301-303.

99增刊1胡宇舟等:基于Storm 的云计算在自动清分系统中的实时数据处理应用一一一一

基于Storm的云计算在自动清分系统中的实时数据处理应用

作者:胡宇舟, 范滨, 顾学道, 缪力, HU Yuzhou, FAN Bin, GU Xuedao, MIAO Li

作者单位:胡宇舟,范滨,HU Yuzhou,FAN Bin(高新现代智能系统股份有限公司产品研发部,广东深圳,518057), 顾学道,缪力,GU Xuedao,MIAO Li(高新现代智能系统有限股份公司博士后科研工

作站,广东深圳,518057)

刊名:

计算机应用

英文刊名:Journal of Computer Applications

年,卷(期):2014(z1)

本文链接:https://www.sodocs.net/doc/315345198.html,/Periodical_jsjyy2014z1029.aspx

storm集群的自适应调度算法

Adaptive Online Scheduling in Storm Leonardo Aniello aniello@dis.uniroma1.it Roberto Baldoni baldoni@dis.uniroma1.it Leonardo Querzoni querzoni@dis.uniroma1.it Research Center on Cyber Intelligence and Information Security and Department of Computer,Control,and Management Engineering Antonio Ruberti Sapienza University of Rome ABSTRACT Today we are witnessing a dramatic shift toward a data-driven economy,where the ability to e?ciently and timely analyze huge amounts of data marks the di?erence between industrial success stories and catastrophic failures.In this scenario Storm,an open source distributed realtime com-putation system,represents a disruptive technology that is quickly gaining the favor of big players like Twitter and Groupon.A Storm application is modeled as a topology,i.e. a graph where nodes are operators and edges represent data ?ows among such operators.A key aspect in tuning Storm performance lies in the strategy used to deploy a topology, i.e.how Storm schedules the execution of each topology component on the available computing infrastructure.In this paper we propose two advanced generic schedulers for Storm that provide improved performance for a wide range of application topologies.The?rst scheduler works o?ine by analyzing the topology structure and adapting the de-ployment to it;the second scheduler enhance the previous approach by continuously monitoring system performance and rescheduling the deployment at run-time to improve overall performance.Experimental results show that these algorithms can produce schedules that achieve signi?cantly better performances compared to those produced by Storm’s default scheduler. Categories and Subject Descriptors D.4.7[Organization and Design]:Distributed systems Keywords distributed event processing,CEP,scheduling,Storm 1.INTRODUCTION In the last few years we are witnessing a huge growth in information production.IBM claims that“every day,we create2.5quintillion bytes of data-so much that90%of the data in the world today has been created in the last two Permission to make digital or hard copies of all or part of this work for personal or classroom use is granted without fee provided that copies are not made or distributed for pro?t or commercial advantage and that copies bear this notice and the full citation on the?rst page.To copy otherwise,to republish,to post on servers or to redistribute to lists,requires prior speci?c permission and/or a fee. DEBS’13,June29–July3,2013,Arlington,Texas,USA. Copyright2013ACM978-1-4503-1758-0/13/06...$15.00.years alone”[15].Domo,a business intelligence company, has recently reported some?gures[4]that give a perspective on the sheer amount of data that is injected on the internet every minute,and its heterogeneity as well:3125photos are added on Flickr,34722likes are expressed on Facebook, more than100000tweets are done on Twitter,etc.This apparently unrelenting growth is a consequence of several factors including the pervasiveness of social networks,the smartphone market success,the shift toward an“Internet of things”and the consequent widespread deployment of sensor networks.This phenomenon,know with the popular name of Big Data,is expected to bring a strong growth in economy with a direct impact on available job positions;Gartner says that the business behind Big Data will globally create4.4 million IT jobs by2015[1]. Big Data applications are typically characterized by the three V s:large volumes(up to petabytes)at a high veloc-ity(intense data streams that must be analyzed in quasi real-time)with extreme variety(mix of structured and un-structured data).Classic data mining and analysis solutions quickly showed their limits when faced with such loads.Big Data applications,therefore,imposed a paradigm shift in the area of data management that brought us several novel approaches to the problem represented mostly by NoSQL databases,batch data analysis tools based on Map-Reduce, and complex event processing engines.This latter approach focussed on representing data as a real-time?ow of events proved to be particularly advantageous for all those appli-cations where data is continuously produced and must be analyzed on the?https://www.sodocs.net/doc/315345198.html,plex event processing engines are used to apply complex detection and aggregation rules on intense data streams and output,as a result,new events.A crucial performance index in this case is represented by the average time needed for an event to be fully analyzed,as this represents a good?gure of how much the application is quick to react to incoming events. Storm[2]is a complex event processing engine that,thanks to its distributed architecture,is able to perform analytics on high throughput data streams.Thanks to these character-istics,Storm is rapidly conquering reputation among large companies like Twitter,Groupon or The Weather Chan-nel.A Storm cluster can run topologies(Storm’s jargon for an application)made up of several processing components. Components of a topology can be either spouts,that act as event producers,or bolts that implement the processing logic.Events emitted by a spout constitute a stream that can be transformed by passing through one or multiple bolts where its events are processed.Therefore,a topology repre-

大数据分析平台技术要求

大数据平台技术要求 1.技术构架需求 采用平台化策略,全面建立先进、安全、可靠、灵活、方便扩展、便于部署、操作简单、易于维护、互联互通、信息共享的软件。 技术构架的基本要求: ?采用多层体系结构,应用软件系统具有相对的独立性,不依赖任何特定的操作系统、特定的数据库系统、特定的中间件应用服务器和特定的硬 件环境,便于系统今后的在不同的系统平台、不同的硬件环境下安装、 部署、升级移植,保证系统具有一定的可伸缩性和可扩展性。 ?实现B(浏览器)/A(应用服务器)/D(数据库服务器)应用模式。 ?采用平台化和构件化技术,实现系统能够根据需要方便地进行扩展。2. 功能指标需求 2.1基础平台 本项目的基础平台包括:元数据管理平台、数据交换平台、应用支撑平台。按照SOA的体系架构,实现对我校数据资源中心的服务化、构件化、定制化管理。 2.1.1元数据管理平台 根据我校的业务需求,制定统一的技术元数据和业务元数据标准,覆盖多种来源统计数据采集、加工、清洗、加载、多维生成、分析利用、发布、归档等各个环节,建立相应的管理维护机制,梳理并加载各种元数据。 具体实施内容包括: ●根据业务特点,制定元数据标准,要满足元数据在口径、分类等方面的 历史变化。 ●支持对元数据的管理,包括:定义、添加、删除、查询和修改等操作,

支持对派生元数据的管理,如派生指标、代码重新组合等,对元数据管 理实行权限控制。 ●通过元数据,实现对各类业务数据的统一管理和利用,包括: ?基础数据管理:建立各类业务数据与元数据的映射关系,实现统一的 数据查询、处理、报表管理。 ?ETL:通过元数据获取ETL规则的描述信息,包括字段映射、数据转 换、数据转换、数据清洗、数据加载规则以及错误处理等。 ?数据仓库:利用元数据实现对数据仓库结构的描述,包括仓库模式、 视图、维、层次结构维度描述、多维查询的描述、立方体(CUBE)的 结构等。 ●元数据版本控制及追溯、操作日志管理。 2.1.2数据交换平台 结合元数据管理模块并完成二次开发,构建统一的数据交换平台。实现统计数据从一套表采集平台,通过数据抽取、清洗和转换等操作,最终加载到数据仓库中,完成整个数据交换过程的配置、管理和监控功能。 具体要求包括: ●支持多种数据格式的数据交换,如关系型数据库:MS-SQLServer、MYSQL、 Oracle、DB2等;文件格式:DBF、Excel、Txt、Cvs等。 ●支持数据交换规则的描述,包括字段映射、数据转换、数据转换、数据 清洗、数据加载规则以及错误处理等。 ●支持数据交换任务的发布与执行监控,如任务的执行计划制定、定期执 行、人工执行、结果反馈、异常监控。 ●支持增量抽取的处理方式,增量加载的处理方式; ●支持元数据的管理,能提供动态的影响分析,能与前端报表系统结合, 分析报表到业务系统的血缘分析关系; ●具有灵活的可编程性、模块化的设计能力,数据处理流程,客户自定义 脚本和函数等具备可重用性; ●支持断点续传及异常数据审核、回滚等交换机制。

大数据处理技术的总结与分析

数据分析处理需求分类 1 事务型处理 在我们实际生活中,事务型数据处理需求非常常见,例如:淘宝网站交易系统、12306网站火车票交易系统、超市POS系统等都属于事务型数据处理系统。这类系统数据处理特点包括以下几点: 一就是事务处理型操作都就是细粒度操作,每次事务处理涉及数据量都很小。 二就是计算相对简单,一般只有少数几步操作组成,比如修改某行得某列; 三就是事务型处理操作涉及数据得增、删、改、查,对事务完整性与数据一致性要求非常高。 四就是事务性操作都就是实时交互式操作,至少能在几秒内执行完成; 五就是基于以上特点,索引就是支撑事务型处理一个非常重要得技术. 在数据量与并发交易量不大情况下,一般依托单机版关系型数据库,例如ORACLE、MYSQL、SQLSERVER,再加数据复制(DataGurad、RMAN、MySQL数据复制等)等高可用措施即可满足业务需求。 在数据量与并发交易量增加情况下,一般可以采用ORALCERAC集群方式或者就是通过硬件升级(采用小型机、大型机等,如银行系统、运营商计费系统、证卷系统)来支撑. 事务型操作在淘宝、12306等互联网企业中,由于数据量大、访问并发量高,必然采用分布式技术来应对,这样就带来了分布式事务处理问题,而分布式事务处理很难做到高效,因此一般采用根据业务应用特点来开发专用得系统来解决本问题。

2数据统计分析 数据统计主要就是被各类企业通过分析自己得销售记录等企业日常得运营数据,以辅助企业管理层来进行运营决策。典型得使用场景有:周报表、月报表等固定时间提供给领导得各类统计报表;市场营销部门,通过各种维度组合进行统计分析,以制定相应得营销策略等. 数据统计分析特点包括以下几点: 一就是数据统计一般涉及大量数据得聚合运算,每次统计涉及数据量会比较大。二就是数据统计分析计算相对复杂,例如会涉及大量goupby、子查询、嵌套查询、窗口函数、聚合函数、排序等;有些复杂统计可能需要编写SQL脚本才能实现. 三就是数据统计分析实时性相对没有事务型操作要求高。但除固定报表外,目前越来越多得用户希望能做做到交互式实时统计; 传统得数据统计分析主要采用基于MPP并行数据库得数据仓库技术.主要采用维度模型,通过预计算等方法,把数据整理成适合统计分析得结构来实现高性能得数据统计分析,以支持可以通过下钻与上卷操作,实现各种维度组合以及各种粒度得统计分析。 另外目前在数据统计分析领域,为了满足交互式统计分析需求,基于内存计算得数据库仓库系统也成为一个发展趋势,例如SAP得HANA平台。 3 数据挖掘 数据挖掘主要就是根据商业目标,采用数据挖掘算法自动从海量数据中发现隐含在海量数据中得规律与知识。

19252-storm入门到精通-storm1

Storm简介

Storm简介 ?实时计算需要解决一些什么问题?实现一个实时计算系统?Storm基本概念 ?Storm使用场景 ?Storm分组机制

Storm简介 ?实时计算需要解决一些什么问题 伴随着信息科技日新月异的发展,信息呈现出爆发式的膨胀,人们获取信息的途径也更加多样、更加便捷,同时对于信息的时效性要求也越来越高。举个搜索场景中的例子,当一个卖家发布了一条宝贝信息时,他希望的当然是这个宝贝马上就可以被卖家搜索出来、点击、购买啦,相反,如果这个宝贝要等到第二天或者更久才可以被搜出来,估计这个大哥就要骂娘了。再举一个推荐的例子,如果用户昨天在淘宝上买了一双袜子,今天想买一副泳镜去游泳,但是却发现系统在不遗余力地给他推荐袜子、鞋子,根本对他今天寻找泳镜的行为视而不见,估计这哥们心里就会想推荐你妹呀。其实稍微了解点背景知识的码农们都知道,这是因为后台系统做的是每天一次的全量处理,而且大多是在夜深人静之时做的,那么你今天白天做的事情当然要明天才能反映出来啦。

Storm简介 ?实现一个实时计算系统 全量数据处理使用的大多是鼎鼎大名的hadoop或者hive,作为一个批处理系统,hadoop 以其吞吐量大、自动容错等优点,在海量数据处理上得到了广泛的使用。但是,hadoop不擅长实时计算,因为它天然就是为批处理而生的,这也是业界一致的共识。否则最近这两年也不会有 s4,storm,puma这些实时计算系统如雨后春笋般冒出来啦。先抛开s4,storm,puma这些系统不谈,我们首先来看一下,如果让我们自己设计一个实时计算系统,我们要解决哪些问题。

大数据分析平台技术要求

大数据平台技术要求 1. 技术构架需求 采用平台化策略,全面建立先进、安全、可靠、灵活、方便扩展、便于部署、操作简单、易于维护、互联互通、信息共享的软件。 技术构架的基本要求: 采用多层体系结构,应用软件系统具有相对的独立性,不依赖任何特定的操作系统、特定的数据库系统、特定的中间件应用服务器和特定的硬 件环境,便于系统今后的在不同的系统平台、不同的硬件环境下安装、 部署、升级移植,保证系统具有一定的可伸缩性和可扩展性。 实现B(浏览器)/A(应用服务器)/D(数据库服务器)应用模式。 采用平台化和构件化技术,实现系统能够根据需要方便地进行扩展。2. 功能指标需求 2.1基础平台 本项目的基础平台包括:元数据管理平台、数据交换平台、应用支撑平台。按照SOA的体系架构,实现对我校数据资源中心的服务化、构件化、定制化管理。 2.1.1元数据管理平台 根据我校的业务需求,制定统一的技术元数据和业务元数据标准,覆盖多种来源统计数据采集、加工、清洗、加载、多维生成、分析利用、发布、归档等各个环节,建立相应的管理维护机制,梳理并加载各种元数据。 具体实施内容包括: ●根据业务特点,制定元数据标准,要满足元数据在口径、分类等方面的 历史变化。 ●支持对元数据的管理,包括:定义、添加、删除、查询和修改等操作,

支持对派生元数据的管理,如派生指标、代码重新组合等,对元数据管 理实行权限控制。 ●通过元数据,实现对各类业务数据的统一管理和利用,包括: ?基础数据管理:建立各类业务数据与元数据的映射关系,实现统一 的数据查询、处理、报表管理。 ?ETL:通过元数据获取ETL规则的描述信息,包括字段映射、数据转 换、数据转换、数据清洗、数据加载规则以及错误处理等。 ?数据仓库:利用元数据实现对数据仓库结构的描述,包括仓库模式、 视图、维、层次结构维度描述、多维查询的描述、立方体(CUBE) 的结构等。 ●元数据版本控制及追溯、操作日志管理。 2.1.2数据交换平台 结合元数据管理模块并完成二次开发,构建统一的数据交换平台。实现统计数据从一套表采集平台,通过数据抽取、清洗和转换等操作,最终加载到数据仓库中,完成整个数据交换过程的配置、管理和监控功能。 具体要求包括: ●支持多种数据格式的数据交换,如关系型数据库:MS-SQLServer、MYSQL、 Oracle、DB2等;文件格式:DBF、Excel、Txt、Cvs等。 ●支持数据交换规则的描述,包括字段映射、数据转换、数据转换、数据 清洗、数据加载规则以及错误处理等。 ●支持数据交换任务的发布与执行监控,如任务的执行计划制定、定期执 行、人工执行、结果反馈、异常监控。 ●支持增量抽取的处理方式,增量加载的处理方式; ●支持元数据的管理,能提供动态的影响分析,能与前端报表系统结合, 分析报表到业务系统的血缘分析关系; ●具有灵活的可编程性、模块化的设计能力,数据处理流程,客户自定义 脚本和函数等具备可重用性; ●支持断点续传及异常数据审核、回滚等交换机制。

论Storm分布式实时计算工具

龙源期刊网 https://www.sodocs.net/doc/315345198.html, 论Storm分布式实时计算工具 作者:沈超邓彩凤 来源:《中国科技纵横》2014年第03期 【摘要】互联网的应用催生了一大批新的数据处理技术,storm分布式实时处理工具以其强大的数据处理能力、可靠性高、扩展性好等特点,在近几年得到越来越广泛的关注和应用。 【关键词】分布式实时计算流处理 1 背景及特点 互联网的应用正在越来越深入的改变人们的生活,互联网技术也在不断发展,尤其是大数据处理技术,过去的十年是大数据处理技术变革的十年,MapReduce,Hadoop以及一些相关 的技术使得我们能处理的数据量比以前要大得多得多。但是这些数据处理技术都不是实时的系统,或者说,它们设计的目的也不是为了实时计算。没有什么办法可以简单地把hadoop变成一个实时计算系统。实时数据处理系统和批量数据处理系统在需求上有着本质的差别。 然而大规模的实时数据处理已经越来越成为一种业务需求了,而缺少一个“实时版本的hadoop”已经成为数据处理整个生态系统的一个巨大缺失。而storm的出现填补了这个缺失。Storm出现之前,互联网技术人员可能需要自己手动维护一个由消息队列和消息处理者所组成的实时处理网络,消息处理者从消息队列取出一个消息进行处理,更新数据库,发送消息给其它队列等等。不幸的是,这种方式有以下几个缺陷: 单调乏味:技术人员花费了绝大部分开发时间去配置把消息发送到哪里,部署消息处理者,部署中间消息节点—设计者的大部分时间花在设计,配置这个数据处理框架上,而真正关心的消息处理逻辑在代码里面占的比例很少。 脆弱:不够健壮,设计者要自己写代码保证所有的消息处理者和消息队列正常运行。 伸缩性差:当一个消息处理者的消息量达到阀值,需要对这些数据进行分流,配置这些新的处理者以让他们处理分流的消息。 Storm定义了一批实时计算的原语。如同hadoop大大简化了并行批量数据处理,storm的这些原语大大简化了并行实时数据处理。storm的一些关键特性如下: 适用场景广泛:storm可以用来处理消息和更新数据库(消息流处理),对一个数据量进行持续的查询并返回客户端(持续计算),对一个耗资源的查询作实时并行化的处理(分布式方法调用),storm的这些基础原语可以满足大量的场景。

大数据处理平台构架设计说明书

大数据处理平台及可视化架构设计说明书 版本:1.0 变更记录

目录 1 1. 文档介绍 (3) 1.1文档目的 (3) 1.2文档范围 (3) 1.3读者对象 (3) 1.4参考文献 (3) 1.5术语与缩写解释 (3) 2系统概述 (4) 3设计约束 (5) 4设计策略 (6) 5系统总体结构 (7) 5.1大数据集成分析平台系统架构设计 (7) 5.2可视化平台系统架构设计 (11) 6其它 (14) 6.1数据库设计 (14) 6.2系统管理 (14) 6.3日志管理 (14)

1 1. 文档介绍 1.1 文档目的 设计大数据集成分析平台,主要功能是多种数据库及文件数据;访问;采集;解析,清洗,ETL,同时可以编写模型支持后台统计分析算法。 设计数据可视化平台,应用于大数据的可视化和互动操作。 为此,根据“先进实用、稳定可靠”的原则设计本大数据处理平台及可视化平台。 1.2 文档范围 大数据的处理,包括ETL、分析、可视化、使用。 1.3 读者对象 管理人员、开发人员 1.4 参考文献 1.5 术语与缩写解释

2 系统概述 大数据集成分析平台,分为9个层次,主要功能是对多种数据库及网页等数据进行访采集、解析,清洗,整合、ETL,同时编写模型支持后台统计分析算法,提供可信的数据。 设计数据可视化平台 ,分为3个层次,在大数据集成分析平台的基础上实现大实现数据的可视化和互动操作。

3 设计约束 1.系统必须遵循国家软件开发的标准。 2.系统用java开发,采用开源的中间件。 3.系统必须稳定可靠,性能高,满足每天千万次的访问。 4.保证数据的成功抽取、转换、分析,实现高可信和高可用。

大数据处理综合处理服务平台的设计实现分析范文

大数据处理综合处理服务平台的设计与实现 (广州城市职业学院广东广州510405) 摘要:在信息技术高速发展的今天,金融业面临的竞争日趋激烈,信息的高度共享和数据的安全可靠是系统建设中优先考虑的问题。大数据综合处理服务平台支持灵活构建面向数据仓库、实现批量作业的原子化、参数化、操作简单化、流程可控化,并提供灵活、可自定义的程序接口,具有良好的可扩展性。该服务平台以SOA为基础,采用云计算的体系架构,整合多种ETL技术和不同的ETL工具,具有统一、高效、可拓展性。该系统整合金融机构的客户、合约、交易、财务、产品等主要业务数据,提供客户视图、客户关系管理、营销管理、财务分析、质量监控、风险预警、业务流程等功能模块。该研究与设计打破跨国厂商在金融软件方面的垄断地位,促进传统优势企业走新型信息化道路,充分实现了“资源共享、低投入、低消耗、低排放和高效率”,值得大力发展和推广。 关键词:面向金融,大数据,综合处理服务平台。 一、研究的意义 目前,全球IT行业讨论最多的两个议题,一个是大数据分析“Big Data”,一个是云计算“Cloud Computing”。中

国五大国有商业银行发展至今,积累了海量的业务数据,同时还不断的从外界收集数据。据IDC(国际数据公司)预测,用于云计算服务上的支出在接下来的5 年间可能会出现3 倍的增长,占据IT支出增长总量中25%的份额。目前企业的各种业务系统中数据从GB、TB到PB量级呈海量急速增长,相应的存储方式也从单机存储转变为网络存储。传统的信息处理技术和手段,如数据库技术往往只能单纯实现数据的录入、查询、统计等较低层次的功能,无法充分利用和及时更新海量数据,更难以进行综合研究,中国的金融行业也不例外。中国五大国有商业银行发展至今,积累了海量的业务数据,同时还不断的从外界收集数据。通过对不同来源,不同历史阶段的数据进行分析,银行可以甄别有价值潜力的客户群和发现未来金融市场的发展趋势,针对目标客户群的特点和金融市场的需求来研发有竞争力的理财产品。所以,银行对海量数据分析的需求是尤为迫切的。再有,在信息技术高速发展的今天,金融业面临的竞争日趋激烈,信息的高度共享和数据的安全可靠是系统建设中优先考虑的问题。随着国内银行业竞争的加剧,五大国有商业银行不断深化以客户为中心,以优质业务为核心的经营理念,这对银行自身系统的不断完善提出了更高的要求。而“云计算”技术的推出,将成为银行增强数据的安全性和加快信息共享的速度,提高服务质量、降低成本和赢得竞争优势的一大选择。

大数据分析平台

一、数据分析平台层次解析 大数据分析处理架构图 数据源:除该种方法之外,还可以分为离线数据、近似实时数据和实时数据。按照图中的分类其实就是说明了数据存储的结构,而特别要说的是流数据,它的核心就是数据的连续性和快速分析性; 计算层:内存计算中的Spark是UC Berkeley的最新作品,思路是利用集群中的所有内存将要处理的数据加载其中,省掉很多I/O开销和硬盘拖累,从而加快计算。而Impala思想来源于Google Dremel,充分利用分布式的集群和高效存储方式来加快大数据集上的查询速度,这也就是我上面说到的近似实时查询;底层的文件系统当然是HDFS独大,也就是Hadoop的底层存储,现在大数据的技术除了微软系的意外,基本都是HDFS作为底层的存储技术。上层的YARN就是MapReduce的第二版,和在一起就是Hadoop最新版本。基于之上的应用有Hive,Pig Latin,这两个是利用了SQL的思想来查询Hadoop上的数据。 关键:利用大数据做决策支持。R可以帮你在大数据上做统计分析,利用R语言和框架可以实现很专业的统计分析功能,并且能利用图形的方式展现;而Mahout就是一个集数据挖掘、决策支持等算法于一身的工具,其中包含的都是

基于Hadoop来实现的经典算法,拿这个作为数据分析的核心算法集来参考还是很好的。 如此一个决策支持系统要怎么展现呢?其实这个和数据挖掘过程中的展现一样,无非就是通过表格和图标图形来进行展示,其实一份分类详细、颜色艳丽、数据权威的数据图标报告就是呈现给客户的最好方式!至于用什么工具来实现,有两个是最好的数据展现工具,Tableau和Pentaho,利用他们最为数据展现层绝对是最好的选择。 二、规划的数据平台产品AE(Accelerate Engine) 支持下一代企业计算关键技术的大数据处理平台:包括计算引擎、开发工具、管理工具及数据服务。计算引擎是AE的核心部分,提供支持从多数据源的异构数据进行实时数据集成、提供分布式环境下的消息总线、通过Service Gateway能够与第三方系统进行服务整合访问;设计了一个分布式计算框架,可以处理结构化和非结构化数据,并提供内存计算、规划计算、数据挖掘、流计算等各种企业计算服务。Data Studio包括了数据建模、开发、测试等集成开发环境。管理工具包括了实施、客户化及系统管理类工具。AE平台还可以通过UAP开发者社区提供丰富的数据服务。 AE架构图

物联网大数据处理中实时流计算系统的实践

170 ?电子技术与软件工程 Electronic Technology & Software Engineering 数据库技术 ? Data Base Technique 【关键词】大数据 实时计算 物联网 实践 物联网是在互联网应用的基础上进行了进一步拓展。其主要具有移动、智能、多节点的特点。而Spark 为大数据实时计算工作提供了一个优良的数据储存计算引擎,其在实际数据应用过程中,可利用自身优良的计算性能及多平台兼容特性,实现大数据混合计算处理。因此为了保证物联网数据处理效率,对大数据混合计算模式在物联网中的实践应用进行适当分析具有非常重要的意义。 1 基于Spark的大数据混合计算模型 基于Spark 的大数据混合计算模式在实际设计过程中,首先需要进行数据源的确定,经过逐步处理后将其进行计算储存,并通过实时查询数据库进行提前数据Web 接口的设置。在这个基础上,将不同数据源数据通过分布式处理模式进行移动、收集、分发。然后利用Spark 数据批处理工作,综合采用直接走流处理、程序批处理的方式,将实施应用数据调到已核算完毕的计算结果中间。最后基于物联网应用特点,将数据源数据内部数据移动、收集及分发批处理模块进行有机整合,并结合大数据域内数据处理需求,逐渐利用SparklShark 架构代替MapreducelHIve 结构。在这个基础上进行Spark 混合计算规则融入,最终形成完善的Spark 混合计算模型架构。 2 大数据实时计算在物联网中的实践 2.1 以流处理为基础的用量实时计算系统 以流处理为基础的用量实时计算系统在物联网中的实践应用,主要是利用开源分布式 物联网大数据处理中实时流计算系统的实践 文/吴海建1 吕军2 软件结构的架设,结合Flume 数据收集模块的 设置。同时将物联网中不同数据源进行接入差异化分析。在这个基础上利用消息缓存系统保障模块,将用量实时计算系统内部相关模块间进行解耦设置。同时结合流式计算框架的运行,保障系统并行计算性能拓展问题的有效处理。在具体基于流处理的用量实时计算系统设置过程中,主要包括数据收集、数据处理、数据存储、数据处理等几个模块。首先在数据收集模块设置环节,主要采用Flume 集群,结合海量日志采集、传输、集成等功能的处理,可从exec 、text 等多数据源进行数据收集。Flume 集群的处理核心为代理,即在完整数据收集中心的基础上,通过核心事件集合,分别采用话 单文件代理、计费消息代理等模式,对文件、消息进行收集处理。需要注意的是,在消息接收之后,需要将不同代理数据进行统一数据格式的处理,从而保证整体消息系统的核心统一。其次在实际应用过程中,以流处理为基础的大数据实时计算模型在数据接入环节,主要采用Kafka 集群,其在实际运行中具有较为优良的吞吐量。而且分布式订阅消息发布的新模式,也可以在较为活跃的流式数据处理中发挥优良的效用。在以流处理为基础的用量实时计算系统运行过程中,Kafka 集群主要针对O (1)磁盘数据,其主要通过对TB 级别的消息进行储存处理,并维持相应数据在对应磁盘数据结构中的平稳运行。同时在实际运行中,Kafka 集群还可以依据消息储存日期进行消息类别划分,如通过对消息生产者、消息消费者等相应类别的划分,可为元数据信息处理效率的提升提供依据。 数据处理框架主要采用Storm 集群,其主要具有容错率高、开源免费、分布式等优良特点。在基于Storm 集群的数据处理框架计算过程中,可通过实时计算图状结构的设计,进行拓扑集群提交。同时通过集群中主控节点分发代码设置,实现数据实时过滤处理。在实际运行过程中,基于Storm 集群的数据处理框架,具有Spout 、Bolt 两种形式。前者为数据信息发送,而后者为数据流转换。通过模块间数据传输,Storm 集群也可以进行流量区域分析、自动化阈值检查、流量区域分析等模块的集中处理。数据储存模块主要采用Redis 集群,其在实际处理过程中,主要采用开源式的内部储存结构,通过高速缓存消息队列的设置,可为多种数据类型处理提供依据,如有效集合、列表、字符串、散列表等。2.2 算例分析 在实际应用过程中,基于流处理的大数据实时计算模型需要对多种维度因素进行综合分析,如运营商区域组成维度、时间段储存方案、APN 、资费组处理等。以某个SIM 卡数据处理为例,若其ID 为12345678,则在实际处理中主要包括APN1、APN2两个APN 。若其为联通域内的SIM 卡,则其运营商代码为86。这种情况下就可以对其进行高峰时段及非高峰时段进行合理处理,分为为0、1。而资费组就需要进行All 默认程度的处理,若当前流量话费总体使用量为1.6KB ,则APN1、APN2分别使用流量为1.1/0.4KB 。而在高峰时段、非高峰时段流量损耗为1.1/0.5KB 。这种情况下,就需要对整体区域维度及储存变动情况进行合理评估。在这一环节储存变动主要为Storm 集群,即为消息系统-流量区域分析-流量区域累积-自动化规则阈值检测/区域组合统计-缓存系统。 3 结束语 综上所述,从长期而言,基于Spark 的大数据混合计算模式具有良好的应用优势,其可以通过批处理、流计算、机器学习、图分析等模式的综合应用,满足物联网管理中的多个场景需要。而相较于以往物联网平台而已,基于流处理的大数据实时处理系统具有更为优良的数据压力处理性能。通过多种集群的整合,基于流处理的大数据实时处理系统在我国物联网平台将具有更加广阔的应用前景。 参考文献 [1]欧阳晨.海关应用大数据的实践与思考 [J].海关与经贸研究,2016,37(03):33-43. [2]余焯伟.物联网与大数据的新思考[J]. 通讯世界,2017(01):1-2. [3]孙学义.物联网与大数据的新思考[J]. 科研,2017(03):00200-00200. 作者简介 吴海建(1980-),男,浙江省衢州市人。硕士研究生,中级工程师。研究方向为人工智能。 作者单位 1.中电海康集团有限公司 浙江省杭州市 310012 2.中国电子科技集团第五十二研究所 浙江省杭州市 310012

storm

Storm是Twitter所提出的一个分布式计算系统,最初的目的是为了能将Twitter上一些最新的动态实时推送给用户,但随着它的发展,Twitter的工程师逐渐把Storm进行高层抽象,最终形成这么一个实时计算框架。Storm内部逻辑并不复杂,而且使用起来非常简单,这使得它能更容易的被其他开发者应用到他们自己的产品中去,开发人员可以利用Storm完成一些或简单或复杂的实时计算。而Storm作为这么一个分布式计算框架,它最耀眼的一个特点就是它的容错机制,它可以保证所发送出来的数据都不会丢失,达到记录级的容错,并且在速度上非常优秀,能进行实时计算。。 2.3.1 Storm Storm具有以下优点: 1.简单的编程模型。Storm提供spout和bolt原语,降低了进行海量数 据实时处理的复杂度。 2.服务化。提供计算模型的抽象,作为一个计算框架,支持热部署, 即时提交或下线Topology。 3.支持多种编程语言。默认支持Clojure、java、Ruby和Python等语言, 但也通过实现一个Storm通信协议就可以增加对其他语言的支持, 语言扩展性好。 4.容错性。Fail-fast系统,通过Zookeeper进行任务协作,nimbus和 supervisor集群不保存任务状态,重启机器结点也不影响。 5.水平扩展。数据处理在线程、进程和机器节间都可以并行。 6.高可靠性的消息处理。Storm保证不会丢失数据,每次所发送出去的 消息都会被处理。如果某个消息的处理超过响应时间,则会从源头 重新发送该消息。 7.快速。因为Storm在底层所使用的数据传输方式是ZeroMQ,其被誉 为是最高性能的消息队列,而且它流式模型设计也保证了任何消息 都能实时响应。 Storm当前存在的问题: 1.目前Storm中nimbus机器只有一个,这就导致如果宕机,则新的Topology 无法提交,这样的话只能靠人工进行重启,不能实现自动化。 2.Storm虽然支持多语言开发,但其核心部分内容是由Clojure语言编写, 虽然它的性能很高,并且具有流程计算的优势,但也使得维护成本增加。 2.3.2 Storm架构 Storm集群主要由两类节点组成,master和worker,它们一般都是一对多

基于Storm与Hadoop的日志数据实时处理研究

目录 摘要 ................................................................................................................................... I Abstract ........................................................................................................................... III 第1章绪论 .. (1) 1.1 研究背景与意义 (1) 1.2 国内外研究进展 (1) 1.3 研究方案 (5) 1.4 本文结构组织 (7) 第2章相关技术研究 (9) 2.1 分布式基础架构Hadoop研究 (9) 2.2 实时计算框架Storm研究 (11) 第3章日志数据实时处理平台架构研究 (15) 3.1 需求分析 (15) 3.2 平台架构 (15) 3.3 离线分析与实时分析结果的整合 (17) 3.4 分布式集群实验环境部署 (19) 3.5 小结 (21) 第4章日志数据的分布式采集与存储 (23) 4.1 开源日志收集系统研究 (23) 4.2 基于Flume的日志数据采集研究 (24) 4.3 基于HBase的日志数据存储研究 (26) 4.4 日志采集存储应用 (29) 4.5 实验与结果分析 (34) 4.6 小结 (37) 第5章基于MapReduce的日志数据离线分析 (39) 5.1 离线分析概述 (39) 5.2 离线知识提取 (39) 5.3 实验结果与分析 (47) 5.4 小结 (52) 第6章基于Storm的日志流数据实时分析 (55) 6.1 实时分析概述 (55) i

大数据可视化分析平台介绍

大数据可视化分析平台 一、背景与目标 基于邳州市电子政务建设的基础支撑环境,以基础信息资源库(人口库、法人库、宏观经济、地理库)为基础,建设融合业务展示系统,提供综合信息查询 展示、信息简报呈现、数据分析、数据开放等资源服务应用。实现市府领导及相 关委办的融合数据资源视角,实现数据信息资源融合服务与创新服务,通过系统达到及时了解本市发展的综合情况,及时掌握发展动态,为政策拟定提供依据。 充分运用云计算、大数据等信息技术,建设融合分析平台、展示平台,整合 现有数据资源,结合政务大数据的分析能力与业务编排展示能力,以人口、法人、地理,人口与地理,法人与地理,实现基础展示与分析,融合公安、交通、工业、教育、旅游等重点行业的数据综合分析,为城市管理、产业升级、民生保障提供 有效支撑。 二、政务大数据平台 1、数据采集和交换需求:通过对各个委办局的指定业务数据进 行汇聚,将分散的数据进行物理集中和整合管理,为实现对数据的分析提供数据支撑。将为跨机构的各类业务系统之间的业务协同,提供统一和集中的数据交互共享服务。包括数据交换、共享和ETL等功能。 2、海量数据存储管理需求:大数据平台从各个委办局的业务系 统里抽取的数据量巨大,数据类型繁杂,数据需要持久化的存储和访问。不论是结构化数据、半结构化数据,还是非结构化数据,经过数 据存储引擎进行建模后,持久化保存在存储系统上。存储系统要具备高可靠性、快速查询能力。 3、数据计算分析需求:包括海量数据的离线计算能力、高效即 席数据查询需求和低时延的实时计算能力。随着数据量的不断增加, 需要数据平台具备线性扩展能力和强大的分析能力,支撑不断增长的

相关文档

- Spark流式计算-深入理解Spark Streaming-与Storm的对比

- 一种基于Storm和Mongodb的分布式实时日志数据存储与处理系统的设计与

- 基于Storm的实时大数据处理

- 基于Storm进行实时网络攻击检测

- Storm:大数据流式计算及应用实践

- 基于案例讲解Storm实时流计算

- Storm分布式实时计算在物联网系统中的应用

- 基于Storm的云计算在自动清分系统中的实时数据处理应用

- 论Storm分布式实时计算工具

- 基于Storm的大容量实时人脸检索系统

- 第8章-Storm—基于拓扑的流数据实时计算系统

- 基于storm的实时计算架构

- 基于Storm与Hadoop的日志数据实时处理研究

- 分布式实时计算系统Storm

- 第8章 Storm基于拓扑的流数据实时计算系统

- 基于案例讲解Storm实时流计算

- 物联网大数据处理中实时流计算系统的实践