性能测试报告范例

测试目的:

考虑到各地区的用户数量和单据量的增加会给服务器造成的压力不可估计,为确保TMS系统顺利在各地区推广上线,决定对TMS系统进行性能测试,重点为监控服务器在并发操作是的资源使用情况和请求响应时间。

测试内容

测试工具

主要测试工具为:LoadRunner11

辅助软件:截图工具、Word

测试结果及分析

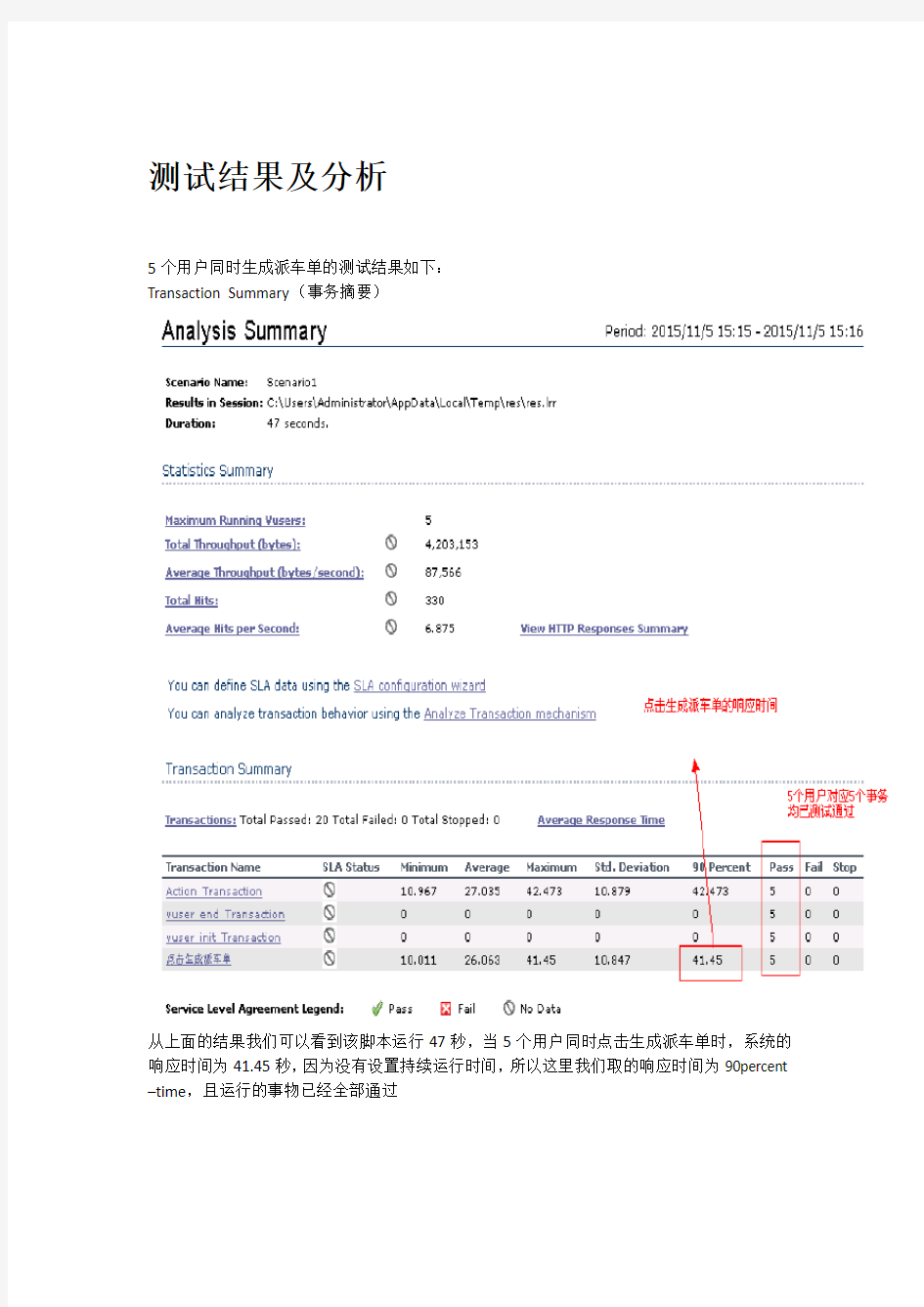

5个用户同时生成派车单的测试结果如下:

Transaction Summary(事务摘要)

从上面的结果我们可以看到该脚本运行47秒,当5个用户同时点击生成派车单时,系统的响应时间为41.45秒,因为没有设置持续运行时间,所以这里我们取的响应时间为90percent –time,且运行的事物已经全部通过

事务概论图,该图表示本次场景共5个事务(每个用户点击一次生成派车单为1个事务),且5个事务均已pass,绿色表色pass,如出现红色则表示产生error

从上图可以看到服务器的CPU平均值为14.419% ,离最大参考值90%相差甚远;且趋势基本成一直线状,表示服务器响应较为稳定,5个用户操作5个900托运单的单据对服务器并没有产生过大的压力。

“Hits per Second(每秒点击数)”反映了客户端每秒钟向服务器端提交的请求数量,这里服务器每秒响应9,771次请求;如果客户端发出的请求数量越多,与之相对的“Average Throughput (吞吐量)”也应该越大。图中可以看出,两种图形的曲线都正常并且几乎重合,说明服务器能及时的接受客户端的请求,并能够返回结果。

按照上述策略,我们得出的最终测试结果为:

生成派车单:

1个用户,300个托运单点击生成派车单,响应时间7.34秒

5个用户,900个托运单点击生成派车单,响应时间41.45秒

单据匹配:

单用户1000箱,20000个商品,上传匹配时间8秒

五个用户2500箱,40000个商品,同时上传匹配耗时2分25秒

自由派车:

单条线路917个托运单下载,响应时间1分40秒

上述结果是在公司内网,测试环境上进行的测试,可能与实际会有偏差

同时本次压测过程发现了3个bug

BUG#25680 【测试环境-1.0.5】五个用户,每个用户同时上传500个单据时,系统报异常(提示用户请求取消当前操作) --待修复

BUG#25519【1.0.5】RF装车界面,当待装车明细过大(超过20000箱)时,点击明细按钮会导致RF崩溃,且明细数量也不正确!--已发版待验证

BUG#25545 【测试环境-1.0.4】PC创建派车计划,多个用户同时选择同条线路,可以选到同样的托运单并审核成功。 --待修复

结论

本次性能测试得出的结果具有一定参考价值,用户数量和数据量也比较切进现场实际情况,所得的各项响应时间在用户可接受的范围,因此本次性能测试通过。

路由器功能性测试报告

A2路由器DQA测试报告

目录 测试环境 (4) 测试设备及环境 (4) 测试硬件 (4) 测试软件 (4) 测试环境 (4) 一、设置向导 (5) 静态IP地址 (5) DHCP客户端 (5) PPPOE 拨号 (6) 二、模式设置 (6) 网关模式 (6) 桥接模式 (7) 无线网络服务提供商 (7) 三、无线 (8) 基本设置 (8) 禁用无线网络接口 (8) 无线网络频段测试 (8) 多AP设置 (9) 无线模式测试 (9) 网络服务标识测试 (10) 信道带宽测试 (10) 信道测试 (11) 广播网络服务标识 (11) 数率测试 (12) 显示活跃的客户端 (12) 扩展网络服务标识 (13) 高级设置 (13) 发射功率测试 (13) 安全 (14) 访问控制 (14) WDS 设置 (14) 站点扫描 (15) WPS 设置 (15) 时间表 (16) 四、 TCP/IP 设置 (16) 局域网设置 (16) 局域网IP地址更改测试 (16) 局域网DHCP地址范围、DHCP 测试 (17) 局域网静态DHCP测试 (17) 广域网设置 (18)

静态IP地址 (18) DHCP客户端 (18) PPPOE 拨号 (19) WAN口带宽测试 (19) WAN口启用PING (20) 在WAN口上启用WEB 访问 (20) 五、防火墙 (21) 端口过滤 (21) IP地址过滤 (21) MAC地址过滤 (21) 端口转发 (22) URL过滤 (22) 隔离区(DMZ) (23) 虚拟局域网 (23) 六、服务质量控制 (23) 下载限速 (23) 上传限速 (24) 七、管理 (24) 状态 (24) 统计信息 (25) 动态域名服务 (25) 时区设置 (25) 拒绝服务攻击 (26) 日志记录 (26) 升级固件 (26) 八、测试结论 (28)

氢氧燃料电池性能测试实验报告

氢氧燃料电池性能测试 实验报告 Company Document number:WTUT-WT88Y-W8BBGB-BWYTT-19998

氢氧燃料电池性能测 试实验报告 学号: 姓名:冯铖炼 指导老师:索艳格 一、实验目的 1.了解燃料电池工作原理 2.通过记录电池的放电特性,熟悉燃料电池极化特性 3.研究燃料电池功率和放电电流、燃料浓度的关系 4.熟悉电子负载、直流电源的操作 二、工作原理 氢氧燃料电池以氢气作燃料为还原剂,氧气作氧化剂氢氧燃料电池,通过燃料的燃烧反应,将化学能转变为电能的电池,与原电池的工作原理相同。 氢氧燃料电池工作时,向氢电极供应氢气,同时向氧电极供应氧气。氢、氧气在电极上的催化剂作用下,通过电解质生成水。这时在氢电极上有多余的电子而带负电,在氧电极上由于缺少电子而带正电。接通电路后,这一类似于燃烧的反应过程就能连续进行。

工作时向负极供给燃料(氢),向正极供给氧化剂(氧气)。氢在负极上的催化剂的作用下分解成正离子H+和电子e-。氢离子进入电解液中,而电子则沿外部电路移向正极。用电的负载就接在外部电路中。在正极上,氧气同电解液中的氢离子吸收抵达正极上的电子形成水。这正是水的电解反应的逆过程。 氢氧燃料电池不需要将还原剂和氧化剂全部储藏在电池内的装置氢氧燃料电池的反应物都在电池外部它只是提供一个反应的容器 氢气和氧气都可以由电池外提供燃料电池是一种化学电池,它利用物质发生化学反应时释出的能量,直接将其变换为电能。从这一点看,它和其他化学电池如锌锰干电池、铅蓄电池等是类似的。但是,它工作时需要连续地向其供给反应物质——燃料和氧化剂,这又和其他普通化学电池不大一样。由于它是把燃料通过化学反应释出的能量变为电能输出,所以被称为燃料电池。 具体地说,燃料电池是利用水的电解的逆反应的"发电机"。它由正极、负极和夹在正负极中间的电解质板所组成。最初,电解质板是利用电解质渗入多孔的板而形成,2013年正发展为直接使用固体的电解质。 工作时向负极供给燃料(氢),向正极供给氧化剂(空气,起作用的成分为氧气)。氢在负极分解成正离子H+和电子e-。当氢离子进入电解液中,而电子就沿外部电路移向正极。用电的负载就接在外部电路中。在正极上,空气中的氧同电解液中的氢离子吸收抵达正极上的电子形成水。这正是水的电解反应的逆过程。此过程水可以得到重复利用,发电原理与可夜间使用的太阳能电池有异曲同工之妙。 燃料电池的电极材料一般为惰性电极,具有很强的催化活性,如铂电极、活性碳电极等。 利用这个原理,燃料电池便可在工作时源源不断地向外部输电,所以也可称它为一种"发电机"。 一般来讲,书写燃料电池的化学反应方程式,需要高度注意电解质的酸碱性。在正、负极上发生的电极反应不是孤立的,它往往与电解质溶液紧密联系。如氢—氧燃料电池有酸式和碱式两种: 若电解质溶液是碱、盐溶液则

性能测试分析报告案例

***系统性能测试报告 V1.0 撰稿人:******* 时间:2011-01-06

目录 1.测试系统名称及测试目标参考 (3) 2.测试环境 (3) 3.场景设计 (3) 3.1测试场景 (3) 3.1测试工具 (4) 4.测试结果 (4) 4.1登录 (4) 4.2发送公文 (6) 4.3收文登记 (8)

1.测试系统名称及测试目标参考 被测系统名称:*******系统 系统响应时间判断原则(2-5-10原则)如下: 1)系统业务响应时间小于2秒,用户对系统感觉很好; 2)系统业务响应时间在2-5秒之间,用户对系统感觉一般; 3)系统业务响应时间在5-10秒之间,用户对系统勉强接受; 4)系统业务响应时间超过10秒,用户无法接受系统的响应速度。 2.测试环境 网络环境:公司内部局域网,与服务器的连接速率为100M,与客户端的连接速率为10/100M 硬件配置: 3.场景设计 3.1测试场景 间

间 间 3.1测试工具 ●测试工具:HP LoadRunner9.0 ●网络协议:HTTP/HTTPS协议 4.测试结果 4.1登录 ●运行1小时后实际登录系统用户数,用户登录后不退出,一直属于在线状态,最 终登录的用户达到9984个;

●响应时间 ●系统资源

服务器的系统资源表现良好(CPU使用率为14%,有15%的物理内存值)。磁盘等其他指标都表现正常,在现有服务器的基础上可以满足9984个在线用户。 4.2发送公文 运行时间为50分钟,100秒后300个用户全部加载成功,300个用户开始同时进行发文,50分钟后,成功发文数量如下图所示,成功发文17792个,发文失败37 个;

Monkey测试性能报告

Monkey测试性能报告 软件简介 Monkey测试是Android自动化测试的一种手段。Monkey测试本身非常简单,就是模拟用户的按键输入,触摸屏输入,手势输入等,看设备多长时间会出异常。 当Monkey程序在模拟器或真实设备运行的时候,程序会产生一定数量或一定时间内的随机模拟用户操作的事件, 如点击,按键,手势等,以及一些系统级别的事件。通常也称随机测试或者稳定性测试。 软件特点 monkey测试的原理就是利用socket通讯的方式来模拟用户的按键输入,触摸屏输入,手势输入等,看设备多长时间会出异常。当Monkey程序在模拟器或设备运行的时候,如果用户出发了比如点击,触摸,手势或一些系统级别的事件的时候,它就会产生随机脉冲,所以可以用Monkey用随机重复的方法去负荷测试你开发的软件。测试案例 Windows下: 1、通过eclipse启动一个Android的emulator 2、在命令行中输入:adb devices查看设备连接情况 C:\Documents and Settings\Administrator>adb devices List of devices attached emulator-5554 device

3、在有设备连接的前提下,在命令行中输入:adb shell进入shell界面 C:\Documents and Settings\Administrator>adb shell # 4、查看data/data文件夹下的应用程序包。注:我们能测试的应用程序包都在这个目录下面 C:\Documents and Settings\Administrator>adb shell # ls data/data ls data/data com.google.android.btrouter com.android.providers.telephony com.android.mms com.android.providers.downloads com.android.deskclock com.android.email com.android.providers.media com.android.settings jp.co.omronsoft.openwnn https://www.sodocs.net/doc/245846846.html,erdictionary

性能测试工具LoadRunner实验报告

性能测试工具LoadRunner实验报告 一、概要介绍 1.1 软件性能介绍 1.1.1 软件性能的理解 性能是一种指标,表明软件系统或构件对于其及时性要求的符合程度;同时也是产品的特性,可以用时间来进行度量。 表现为:对用户操作的响应时间;系统可扩展性;并发能力;持续稳定运行等。1.1.2 软件性能的主要技术指标 响应时间:响应时间=呈现时间+系统响应时间 吞吐量:单位时间内系统处理的客户请求数量。(请求数/秒,页面数/秒,访问人数/秒) 并发用户数:业务并发用户数; [注意]系统用户数:系统的用户总数;同时在线用户人数:使用系统过程中同时在线人数达到的最高峰值。 1.2 LoadRunner介绍 LoadRunner是Mercury Interactive的一款性能测试工具,也是目前应用最为广泛的性能测试工具之一。该工具通过模拟上千万用户实施并发负载,实时性能监控的系统行为和性能方式来确认和查找问题。 1.2.1 LoadRunner工具组成 虚拟用户脚本生成器:捕获最终用户业务流程和创建自动性能测试脚本,即我们在以后说的产生测试脚本; 压力产生器:通过运行虚拟用户产生实际的负载; 用户代理:协调不同负载机上虚拟用户,产生步调一致的虚拟用户; 压力调度:根据用户对场景的设置,设置不同脚本的虚拟用户数量;

监视系统:监控主要的性能计数器; 压力结果分析工具:本身不能代替分析人员,但是可以辅助测试结果的分析。 1.2.2 LoadRunner工具原理 代理(Proxy)是客户端和服务器端之间的中介人,LoadRunner就是通过代理方式截获客户端和服务器之间交互的数据流。 1)虚拟用户脚本生成器通过代理方式接收客户端发送的数据包,记录并将其转发给服务器端;接收到从服务器端返回的数据流,记录并返回给客户端。 这样服务器端和客户端都以为在一个真实运行环境中,虚拟脚本生成器能通过这种方式截获数据流;虚拟用户脚本生成器在截获数据流后对其进行了协议层上的处理,最终用脚本函数将数据流交互过程体现为我们容易看懂的脚本语句。 2)压力生成器则是根据脚本内容,产生实际的负载,扮演产生负载的角色。 3)用户代理是运行在负载机上的进程,该进程与产生负载压力的进程或是线程协作,接受调度系统的命令,调度产生负载压力的进程或线程。 4)压力调度是根据用户的场景要求,设置各种不同脚本的虚拟用户数量,设置同步点等。 5)监控系统则可以对数据库、应用服务器、服务器的主要性能计数器进行监控。 6)压力结果分析工具是辅助测试结果分析。 二、LoadRunner测试过程 2.1 计划测试 定义性能测试要求,例如并发用户的数量、典型业务流程和所需响应时间等。 2.2 创建Vuser脚本 将最终用户活动捕获(录制、编写)到脚本中,并对脚本进行修改,调试等。协议类型:取决于服务器端和客户端之间的通信协议;

Linux 性能测试与分析报告

Linux 性能测试与分析 Linux 性能测试与分析 Revision History 1 性能测试简介 l 性能测试的过程就是找到系统瓶颈的过程。 l 性能测试(包括分析和调优)的过程就是在操作系统的各个子系统之间取得平衡的过程。l 操作系统的各个子系统包括: ?CPU

?Memory ?IO ?Network 他们之间高度依赖,互相影响。比如: 1. 频繁的磁盘读写会增加对存的使用 2. 大量的网络吞吐,一定意味着非常可观的CPU利用率 3. 可用存的减少可能增加大量的swapping,从而使系统负载上升甚至崩溃 2 应用程序类型 性能测试之前,你首先需要判断你的应用程序是属于那种类型的,这可以帮助你判断哪个子系统可能会成为瓶颈。 通常可分为如下两种: CPU bound –这类程序,cpu往往会处于很高的负载,当系统压力上升时,相对于磁盘和存,往往CPU首先到达瓶颈。Web server,mail server以及大部分服务类程序都属于这一类。 I/O bound –这类程序,往往会频繁的访问磁盘,从而发送大量的IO请求。IO类应用程序往往利用cpu发送IO请求之后,便进入sleep状态,从而造成很高的IOWAIT。数据库类程序,cache服务器往往属于这种类型。 3 CPU

3.1 性能瓶颈 3.1.1 运算性能瓶颈 作为计算机的计算单元,其运算能力方面,可能出现如下瓶颈: 1. 用户态进程CPU占用率很高 2. 系统态(核态)CPU占用率很高 测试CPU的运算性能,通常是通过计算圆周率来测试CPU的浮点运算能力和稳定性。据说Pentium CPU的一个运算bug就是通过计算圆周率来发现的。圆周率的计算方法,通常是计算小数点后104万位,通过比较运算时间来评测CPU的运算能力。 常用工具: 1. SUPER PI(π) 2. Wprime 与SuperPI不同的是,可以支持多核CPU的运算速度测试 3. FritzChess 一款国际象棋测试软件,测试每秒钟可运算的步数 突破CPU的运算瓶颈,一般只能靠花钱。比如提高时钟频率,提高L1,L2 cache容量或不断追求新一代的CPU架构: Core -> Nehalem(E55x,如r710,dsc1100) -> Westmere –> Sandy Bridge 3.1.2 调度性能瓶颈 CPU除了负责计算之外,另一个非常重要的功能就是调度。在调度方面,CPU可能会出现如下性能瓶颈: 1. Load平均值超过了系统可承受的程度 2. IOWait占比过高,导致Load上升或是引入新的磁盘瓶颈 3. Context Switch过高,导致CPU就像个搬运工一样,频繁在寄存器(CPU Register)和运行队列(run queue)之间奔波 4. 硬中断CPU占比接近于100% 5. 软中断CPU占比接近于100% 超线程 超线程芯片可以使得当前线程在访问存的间隙,处理器可以使用它的机器周期去执行另外一个线程。一个超线程的物理CPU可以被kernel看作是两个独立的CPU。 3.2 典型监控参数 图1:top

性能测试报告范例

测试目的: 考虑到各地区的用户数量和单据量的增加会给服务器造成的压力不可估计,为确保TMS系统顺利在各地区推广上线,决定对TMS系统进行性能测试,重点为监控服务器在并发操作是的资源使用情况和请求响应时间。 测试内容 测试工具 主要测试工具为:LoadRunner11 辅助软件:截图工具、Word

测试结果及分析 5个用户同时生成派车单的测试结果如下: Transaction Summary(事务摘要) 从上面的结果我们可以看到该脚本运行47秒,当5个用户同时点击生成派车单时,系统的响应时间为41.45秒,因为没有设置持续运行时间,所以这里我们取的响应时间为90percent –time,且运行的事物已经全部通过

事务概论图,该图表示本次场景共5个事务(每个用户点击一次生成派车单为1个事务),且5个事务均已pass,绿色表色pass,如出现红色则表示产生error

从上图可以看到服务器的CPU平均值为14.419% ,离最大参考值90%相差甚远;且趋势基本成一直线状,表示服务器响应较为稳定,5个用户操作5个900托运单的单据对服务器并没有产生过大的压力。

“Hits per Second(每秒点击数)”反映了客户端每秒钟向服务器端提交的请求数量,这里服务器每秒响应9,771次请求;如果客户端发出的请求数量越多,与之相对的“Average Throughput (吞吐量)”也应该越大。图中可以看出,两种图形的曲线都正常并且几乎重合,说明服务器能及时的接受客户端的请求,并能够返回结果。 按照上述策略,我们得出的最终测试结果为: 生成派车单: 1个用户,300个托运单点击生成派车单,响应时间7.34秒 5个用户,900个托运单点击生成派车单,响应时间41.45秒 单据匹配: 单用户1000箱,20000个商品,上传匹配时间8秒 五个用户2500箱,40000个商品,同时上传匹配耗时2分25秒 自由派车: 单条线路917个托运单下载,响应时间1分40秒 上述结果是在公司内网,测试环境上进行的测试,可能与实际会有偏差

软件功能测试报告

软件功能测试报告1.概述 软件名称: 软件版本: (同时注明软件软本和测试包的cvs版本) 开发经理:申请单号: 测试人员: 测试日期: 测试内容: 备注: 2.测试环境 用途硬件环境软件环境 表2 测试环境 3.问题统计 (说明:该报告为阶段性测试的统计报告,该报表统计的bug数量为:本发布阶段内第一份申请单提交日期为起,直至填写报告这天为止的BUG数量,如果以前版本中有问题延期至本发布阶段来修正,那么该缺陷也需要统计进来;如果是功能测试报告则只统计当轮的即可,如果是功能+验证则需要统计本发布阶段的) 3.1按BUG状态统计(表格后面可以附上柱形图,以示更直观) BUG状态BUG数量备注 未分配(new) 不是缺陷(Not Bug)

未修改(open) 已修改(fixed) 不予修改(Won’t Fix)延期(Deffered) 被拒绝(Declined)无法重现信息不足重复的 已关闭(Closed) 重开启(Reopen) 合计 表3 按bug状态统计 3.2按BUG类型统计(表格后面可以附上柱形图,以示更直观) BUG 类型 BUG数量 备注未 分 配 未 修 改 不 是 缺 陷 已 修 改 不 予 修 改 延 期 被拒绝 已 关 闭 重 新 开 启 合 计 无 法 重 现 信 息 不 足 重 复 的 功能 界面 交互 3.3按BUG严重级别统计(表格后面可以附上柱形图,以示更直观) BUG 严 BUG数量 备注未未不已不延被拒绝已重合

重级别分 配 修 改 是 缺 陷 修 改 予 修 改 期无 法 重 现 信 息 不 足 重 复 的 关 闭 新 开 启 计 紧 急 严 重 中 等 轻 微 建 议 表5 按bug严重级别统计 3.4按功能模块统计(表格后面可以附上柱形图,以示更直观) 模块名称 BUG数量 备注未 分 配 未 修 改 不 是 缺 陷 已 修 改 不 予 修 改 延 期 被拒绝 已 关 闭 重 新 开 启 合 计 无 法 重 现 信 息 不 足 重 复 的 模块1 模块2 … …

PC性能评测实验报告

计算机体系结构课程实验报告 PC性能测试实验报告 学号: 姓名:张俊阳 班级:计科1302 题目1:PC性能测试软件 请在网上搜索并下载一个PC机性能评测软件(比如:可在百度上输入“PC 性能benchmark”,进行搜索并下载,安装),并对你自己的电脑和机房电脑的性能进行测试。并加以比较。 实验过程及结果: 我的电脑:

机房电脑:

综上分析:分析pcbenchmark所得数据为电脑的current performance与其potential performance的比值,值大表明计算机目前运行良好,性能好,由测试结果数据可得比较出机房的电脑当前运行的性能更好。分析鲁大师性能测试结果:我的电脑得分148588机房电脑得分71298,通过分析我们可以得出CPU占总得分的比重最大,表明了其对计算机性能的影响是最大的,其次显卡性能和内存性能也很关键,另外机房的电脑显卡性能较弱,所以拉低了整体得分,我的电脑各项得分均超过机房电脑,可以得出我的电脑性能更好的结论。 题目2:toy benchmark的编写并测试 可用C语言编写一个程序(10-100行语句),该程序包括两个部分,一个部分主要执行整数操作,另一个部分主要执行浮点操作,两个部分执行的频率(频率整数,频率浮点)可调整。请在你的计算机或者在机房计算机上,以(,),(,),(,)的频率运行你编写的程序,并算出三种情况下的加权平均运行时间。 实验过程及结果: #include<> #include<> int main() {

int x, y, a; double b; clock_t start, end; printf("请输入整数运算与浮点数运算次数(单位亿次)\n"); scanf("%d%d", &x, &y); /*控制运行频率*/ start = clock(); for (int i = 0; i X项目AB系统性能测试报告 项目编号:XXXXXX-ACP101项目名称:X项目 编写:XXX编写日期: 审核:XX审核日期: 批准:批准日期: 1.前言 1.1.测试目标 本次性能测试的目的:通过测试获取与主机、后台流程平台交互过程中终端服务器处理性能及资源消耗情况。评估目前处理性能是否满足业务需求。 2.测试方法 压力测试采用自动化测试来实现,使用业界主流的压力测试工具LoadRunner8.1及其方法论完成对被测系统进行测试和结果分析。 压力测试工具LoadRunner通过使用虚拟用户模拟真实用户的操作,发起交易,完成对被测系统的加压,监控并记录被测系统的交易响应能力,各服务器的资源使用情况,获取交易响应时间、吞吐率等各项性能指标,并根据测试结果分析系统的性能瓶颈,评估系统的整体性能。 压力测试的测试方法主要包括:在被测系统中录制压力测试中使用的交易脚本,形成可以多次重复并发运行的测试脚本,由LoadRunner的控制台调度这些脚本,并发地执行交易,从而模拟真实生产系统的压力,形成对被测系统的加压,并监控和记录被测系统在这样的压力状况下表现出来的各项特征,例如:交易响应时间变化趋势、吞吐率变化趋势和系统资源(CPU)利用率的变化趋势等,获取被测系统在大压力情况下的各项性能指标。 2.1.测试准备 (1)开发测试交易,交易首先进行圈存,然后发任务给流程平台 (2)使用grinder交易执行过程作为测试交易的脚本 (3)使用下列测试数据(帐号)进行维护。测试时随机获取不同行所的账号进行测试。 压力测试账号 (4)准备一台台式机作为调试测试脚本、发起测试的客户端。配置:CPU intel core 2duo cpu(2.93GHz);2GB Memory;os windows xp sp3.IP为10.2.45.92(5)安装被测试交易到被测试的ABS终端服务器上。 2.2.被测试系统的系统配置 系统名称Ip地址os CPU Memory (GB) Network(M)应用程序参数 ABS10.2.39.13AIX5.3 64bit POWER5 2.3*2 41000Java:1.4.2(64 bit)SR9 mem:ms256; mx1536 Log:error Gateway10.2.39.14AIX5.3 64bit POWER5 2.3*2 41000Java:1.4.2(64 bit)SR9 mem:ms256; mx1280 Log:error 2.3.资源监控 本次压力测试监控的资源是操作系统AIX资源。 利用NMON软件对服务器系统的CPU%进行监控、并把这些数据作为为测试结果的一部分进行收集,便于进行事后分析。 XXXXXX系统 功 能 测 试 报 告 测试人员: 测试时间: 目录 1. 测试概念 (3) 1.1. 测试对象 (3) 1.2. 测试范围 (3) 1.3. 测试目的 (3) 1.4. 参考文档 (3) 2. 功能测试 (3) 2.1. 测试方法 (3) 2.2. 测试环境 (4) 2.3. 测试结果 (4) 2.3.1. 错误等级定义 (4) 2.3.2. 相关图表 (5) 2.3.3. 测试结果 (5) 3. 测试结论 (5) 1.测试概念 1.1. 测试对象 【测试对象概述】 1.2. 测试范围 【测试的功能范围】 1.3. 测试目的 测试软件系统所提供的各功能点是否达到功能目标;反馈跟踪系统功能实现的缺陷及修复情况;从而提高软件系统的质量,最终满足用户使用需求。 1.4. 参考文档 【测试过程中所依据的文档资料】 2.功能测试 2.1. 测试方法 采用黑盒测试法进行功能测试; 采用等价类划分、边界值分析、错误推测法设计测试数据; 及时记录缺陷和错误; 运行测试案例; 检查测试结果是否符合业务逻辑,评审功能测试结果; 开发组修改原码后,重新进行测试。 2.2. 测试环境 硬件软件 服务器CPU: 内存: 硬盘: 网卡:操作系统: 数据库: Web应用服务器: 客户机CPU: 内存: 硬盘: 网卡:操作系统:浏览器: 网络 2.3. 测试结果 整个测试过程进行了两轮全面测试及一次随机测试。在整个测试过程中未发现崩溃性错误。 2.3.1.错误等级定义 按照严重性级别可分为: 1)崩溃性:系统崩溃、数据丢失、数据毁坏,该类问题会导致软件无法正确运行,整体功能受到影响; 2)严重性:重要功能无法实现且不存在其他替代途径实现该功能,或者操作性错误、错误结果、遗漏功能; 3)一般性:功能没有按照预定方法实现,但存在其他合理途径实现该功能; 4)提示性:界面不美观、文字不易懂、错别字、使操作者使用不方便等 流量计性能测定实验报告 篇一:孔板流量计性能测定实验数据记录及处理篇二:实验3 流量计性能测定实验 实验3 流量计性能测定实验 一、实验目的 ⒈了解几种常用流量计的构造、工作原理和主要特点。 ⒉掌握流量计的标定方法(例如标准流量计法)。 ⒊了解节流式流量计流量系数C随雷诺数Re的变化规律,流量系数C的确定方法。 ⒋学习合理选择坐标系的方法。 二、实验内容 ⒈通过实验室实物和图像,了解孔板、1/4园喷嘴、文丘里及涡轮流量计的构造及工作原理。 ⒉测定节流式流量计(孔板或1/4园喷嘴或文丘里)的流量标定曲线。 ⒊测定节流式流量计的雷诺数Re和流量系数C的关系。 三、实验原理 流体通过节流式流量计时在流量计上、下游两取压口之间产生压强差,它与流量的关系为: 式中: 被测流体(水)的体积流量,m3/s; 流量系数,无因次; 流量计节流孔截面积,m2; 流量计上、下游两取压口之间的压强差,Pa ; 被测流体(水)的密度,kg/m3 。 用涡轮流量计和转子流量计作为标准流量计来测量流量VS。每一 个流量在压差计上都有一对应的读数,将压差计读数△P和流量Vs绘制成一条曲线,即流量标定曲线。同时用上式整理数据可进一步得到C—Re关系曲线。 四、实验装置 该实验与流体阻力测定实验、离心泵性能测定实验共用图1所示的实验装置流程图。 ⒈本实验共有六套装置,流程为:A→B(C→D)→E→F→G→I 。 ⒉以精度0.5级的涡轮流量计作为标准流量计,测取被测流量计流量(小于2m3/h流量时,用转子流量计测取)。 ⒊压差测量:用第一路差压变送器直接读取。 图1 流动过程综合实验流程图 ⑴—离心泵;⑵—大流量调节阀;⑶—小流量调节阀; ⑷—被标定流量计;⑸—转子流量计;⑹—倒U管;⑺⑻⑽—数显仪表;⑼—涡轮流量计;⑾—真空表;⑿—流量计平衡阀;⒁—光滑管平衡阀;⒃—粗糙管平衡阀;⒀—回流阀;⒂—压力表;⒄—水箱;⒅—排水阀;⒆—闸阀;⒇— XXX项目or府门户网站性能测试报告 目录 第一章概述 (4) 第二章测试活动 (4) 2.1测试用具 (4) 2.2测试范围 (4) 2.3测试目标 (5) 2.4测试方法 (5) 2.4.1基准测试 (5) 2.4.2并发测试 (6) 2.4.3稳定性测试 (6) 2.5性能指标 (6) 2.6性能测试流程 (6) 2.7测试术语 (7) 第三章性能测试环境 (8) 3.1服务器环境 (8) 3.2客户端环境 (9) 3.3网络结构 (9) 第四章测试方案 (10) 4.1基准测试 (11) 4.2并发测试 (13) 4.3稳定性测试 (15) 第五章测试结果描述和分析 (16) 6.1基准测试性能分析 (16) 6.2并发测试性能分析 (21) 6.3稳定性性能测试分析 (28) 第六章测试结论 (29) 摘要 本文档主要描述XXXX网站检索和页面浏览性能测试中的测试内容、测试方法、测试策略等。 修改历史 注释:评审号为评审记录表的编号。更改请求号为文档更改控制工具自动生成的编号。 第一章概述 由于当前对系统要接受业务量的冲击,面临的系统稳定、成熟性方面的压力。系统的性能问题必将成为焦点问题,海量数据量的“冲击”,系统能稳定在什么样的性能水平,面临业务增加时,系统抗压如何等这些问题需要通过一个较为真实的性能模拟测试来给出答案,通过测试和分析为系统性能的提升提供一些重要参考数据,以供后期系统在软硬件方面的改善和完善。 本《性能测试报告》即是基于上述考虑,参考当前的一些性能测试方法而编写的,用以指导即将进行的该系统性能测试。 第二章测试活动 2.1测试用具 本次性能测试主要采用HP公司的Loadrunner11作为性能测试工具。Load runner主要提供了3个性能测试组件:Virtual User Generator, Controller,Analysis。 ●使用Virtual User Generator修改和优化脚本。 ●使用Controller进行管理,控制并发的模拟并发数,记录测试结果。 ●使用Analysis进行统计和分析结果。 2.2测试范围 此次性能测试实施是对吴忠市门户网站系统性能进行测试评估的过程,我们将依据系统将来的实际运行现状,结合系统的设计目标和业务特点,遵循着发生频率高、对系统或数据库性能影响大、关键和核心业务等原则选取需要进行测试的业务,模拟最终用户的操作行为,构建一个与生产环境相近的压力场景,对系统实施压力测试,以此评判系统的实际性能表现。 根据与相关设计,开发人员的沟通和交流,本次测试主要就是针对大量用户在使用吴忠市门户网站进行信息查询,而选取的典型事务就是用户使用检索进行关键字搜索以及界面浏览和反馈回搜索结果,这是用户使用最频繁,反应最多的地方,也是本系统当前以及以后业务的一个重要压力点所在。所以本次测试只选取检索业务的性能情况和界面浏览进行记录和 文档级别:X级模板编号:TNET-QR-RD004 模板版本:V1.0 XXXX公司 系统名称V1.0 测试报告(功能+性能) 版本记录 状态:C-创建文档,A-增加内容,M-修改内容,D-删除内容 目录 引言 (4) 1.1编制目的 (4) 1.2词汇表 (4) 1.3背景 (4) 2 测试管理 (4) 2.1测试范围与主要内容 (4) 2.2测试方法 (4) 2.3测试环境与测试辅助工具 (5) 2.4测试准则 (5) 2.5测试接受准则 (5) 2.6 BUG的定义标准 (5) 2.7人员与任务表 (6) 2.8缺陷管理与改错计划 (7) 3 测试概要 (7) 3.1测试执行 (7) 3.2测试用例 (8) 3.2.1 功能性 (8) 3.2.2 易用性 (8) 4 测试结果 (8) 4.1B UG量表格统计 (8) 4.2柱形图统计 (9) 4.3B UG趋势图 (9) 4.4B UG引入阶段 (10) 4.5B UG状态分布 (10) 5 测试结论 (11) 5.1功能性 (11) 5.2易用性 (11) 5.3兼容性 (11) 6 附录. 本计划审批意见 (11) 引言 1.1编制目的 略 1.2词汇表 1.3背景 随着互联网的发展,人们对于网络依赖,XX系统的实现提供手机端的访问,及各功能在便捷设备上的使用,提供客户更快更优质的服务。 2测试管理 2.1测试范围与主要内容 略 2.2测试方法 黑盒测试: 1.系统测试 2.兼容性测试 3.性能测试 4.压力测试 5.容错性测试 6.升级测试 7.用户体验测试 8.UI测试 9.易用性测试 10.集成测试 [专业公司名] [系统名称] 性能测试报告 版本号: 2014年06月10日共享服务中心 1引言 1.1编写目的 编写该测试总结报告主要有以下几个目的 1.通过对测试结果的分析,得到对系统质量的评价; 2.系统存在的缺陷,为修复和预防bug提供建议; 3.分析测试过程中的不足,为将来的改进提供参考; 说明:列举该报告的作用及其编写目的 1.2阅读对象 主要读者:太平养老及共享中心的领导、团险核心系统的用户、系统需求人员、系统开发人员、测试人员 其他读者:其他愿意了解团险核心系统的其他人员 说明:列举该报告主要的阅读对象,和其他潜在可能的阅读对象 1.3参考资料 XXX项目性能测试方案 XXX项目性能测试需求确认表 XXX项目结果分析表 ………….. 2系统评价 对系统做整体性能测试情况做总结,并对系统整体性能做评估和评价。 3测试环境 3.1网络拓扑结构图 可添加生产环境网络拓扑结构图与性能测试环境网络拓扑结构图,并对比,如一致要说明环境一致;如不一致,要说明差异性。与接口系统的对接情况做说明,如对接XXX接口的测试环境或者开发挡板等。 3.2软硬件配置 性能测试硬件基础环境表 性能测试软件环境配置表 性能测试环境参数配置表 说明环境参数配置表可以以此表格的形式展现,也可以内嵌配置文件。4测试进度 添加进度偏差说明分析 5测试数据 增量:可以是交易功能insert新增的数据量,也可以是查询类功能的查询结果的数据量。 6测试情况 6.1基准测试 6.1.1测试过程 描述测试过程中遇到的问题,解决的方法等。如没有,本小节可删减。 6.1.2测试结果 第一轮:未达指标的数据可以标红突出 手机性能测试报告 系:信息 班级:041 指导教师:李国力 本报告是我同肖钢同学一起合作完成的。由于条件限制,我们只是通过测试相同的项目来对比两个版本的性能差异,实验项目有基本功能、游戏流畅性、响应时间、CPU 负载、内存使用等。我们所做的实验测试,只对存在差异性的项目进行报告结果,对其它有相同结果的项目没有列到本报告中。在实验中分别是对安卓和苹果二种手机进行了测试。 第一个成果:测试项及测试结果: 第二个成果是:使用超级兔子系统评测的结果: 序号 测试项 功能名称 RAM256版 RAM512升级版 差值\优势机 1 基本功能 通话,短信,浏 览器 正常 正常 相同 2 安装20个软件用时 第三方软件 1000秒 300秒 700秒/RAM512 升级版 3 启动游戏 Angry bird 20秒 12秒 8秒/RAM512升级版 4 游戏后台 Angry bird 不能后台(内存不足引起) 能后台 RAM512升级版 5 5小时并发测试 音乐、QQ ,Angry bird Angry bird 出现2次错 误 正常 RAM512升级版 6 运行游戏 的流畅性 Angry bird , NFS Shift ,水果 忍者 RAM512升级版 测试项 RAM256版 RAM512升级版 差值/优势机 1 RAM 性能 88 98 10/RAM51 2 2 CPU 整数性能 179 199 20/RAM512 3 CPU 浮点性能 15 16 1 4 2D 绘图性能 234 23 5 1 5 3D 绘图性能 395 454 60/RAM512 6 数据库IQ 性能 120 140 20/RAM512 7 SD 卡写入速度 55 55 0 8 SD 卡读取速度 161 161 南昌大学软件学院 实验报告 实验名称 LoadRunner的使用 实验地点 实验日期 指导教师 学生班级 学生姓名 学生学号 提交日期 LoadRunner简介: LoadRunner 是一种适用于各种体系架构的自动负载测试工具,它能预测系统行为并优化系统性能。LoadRunner 的测试对象是整个企业的系统,它通过模拟实际用户的操作行为和实行实时性能监测,来帮助您更快的查找和发现问题。此外,LoadRunner 能支持广范的协议和技术,为您的特殊环境提供特殊的解决方案。LoadRunner是目前应用最为广泛的性能测试工具之一。 一、实验目的 1. 熟练LoadRunner的工具组成和工具原理。 2. 熟练使用LoadRunner进行Web系统测试和压力负载测试。 3. 掌握LoadRunner测试流程。 二、实验设备 PC机:清华同方电脑 操作系统:windows 7 实用工具:WPS Office,LoadRunner8.0工具,IE9 三、实验内容 (1)、熟悉LoadRunner的工具组成和工具原理 1.LoadRunner工具组成 虚拟用户脚本生成器:捕获最终用户业务流程和创建自动性能测试脚本,即我们在以后说的产生测试脚本; 压力产生器:通过运行虚拟用户产生实际的负载; 用户代理:协调不同负载机上虚拟用户,产生步调一致的虚拟用户;压力调度:根据用户对场景的设置,设置不同脚本的虚拟用户数量;监视系统:监控主要的性能计数器; 压力结果分析工具:本身不能代替分析人员,但是可以辅助测试结果的分析。 2.LoadRunner工具原理 代理(Proxy)是客户端和服务器端之间的中介人,LoadRunner 就是通过代理方式截获客户端和服务器之间交互的数据流。 ①虚拟用户脚本生成器通过代理方式接收客户端发送的数据包, 性能测试总结报告 目录 1基本信息 (4) 1.1背景 (4) 1.2参考资料 (4) 1.3名词解释 (4) 1.4测试目标 (4) 2测试工具及环境 (4) 2.1测试环境架构 (4) 2.2系统配置 (4) 2.3测试工具 (4) 3测试相关定义 (4) 4测试记录和分析 (5) 4.1测试设计 (5) 4.2测试执行日志 (5) 4.3测试结果汇总 (5) 4.4测试结果分析 (6) 5交付物 (6) 6.测试结论和建议 (7) 6.1测试结论 (7) 6.2建议 (7) 7批准 (7) 使用说明 在正式使用时,本节及蓝色字体部分请全部删除。本节与蓝色字体部分为说明文字,用以表明该部分的内容或者注意事项。 1基本信息 1.1背景 <简要描述项目背景> 1.2参考资料 <比如:测试计划、测试流程、测试用例执行记录、SOW、合同等> 1.3名词解释 1.4测试目标 <说明测试目标,例如在线用户数、并发用户数、主要业务相应时间等> 2测试工具及环境 2.1测试环境架构 2.2系统配置 硬件配置 软件配置 2.3测试工具 3测试相关定义 <以下为示例,请根据项目实际情况填写完整> 4测试记录和分析 4.1测试设计 <说明测试的方案和方法> 4.2测试执行日志 <以下为示例,项目组按实际情况修改或填写> 4.3测试结果汇总 <以下为示例,项目组按实际情况修改或填写> 4.4测试结果分析 <分析各服务器在测试过程中的资源消耗情况> 1.数据库服务器 2.应用服务器 3.客户端性能分析 4.网络传输性能分析 5.综合分析 5交付物 <指明本测试完成后交付的测试文档、测试代码及测试工具等测试工作产品,以及指明配置管理位置和物理媒介等,一般包括但不限于如下工作产品: 1.测试计划 2.测试策略 3.测试方案 4.测试用例 5.测试报告 性能测试报告 ―――――――――――――――――――― 宜通关研发部 云路网络科技有限公司 目录 1. 测试目的 (3) 2. 测试地点 (3) 3. 测试环境 (3) 3.1.客户端环境 (3) 3.2.测试工具 (3) 3.3. M ONKEY的特征 (3) 4. 测试过程说明 (4) 4.1.测试案例 (4) 5. 测试结果 (5) 6. 性能测试总结 (6) 1.测试目的 本报告是针对在Android客户端的稳定性,CPU使用率,UI的渲染时间以及发生的未知的错误,发现现有系统中可能存在的性能方面问题,提出可行性建议,以尽可能降低后续工作风险,为运用的稳定运行提供保证。 主要测试目标如下: 1、获得是否无响应问题,崩溃问题,内存泄露问题,异常问题(包含空指针, NullPointerException)。 2、获得APP在不同负载下的资源消耗情况,为硬件配置提供依据。 1.测试地点 公司。 2.测试环境 2.1.客户端环境 本次测试使用的设备清单如下: 设备名称设备型号操作系统网络内存CPU 测试次数魅族魅蓝3s 5.1 3G 16G 2G 100000 OPPO R7 Plus 5.0 WiFi 32G 3G 10000 2.2.测试工具 测试项目测试工具 性能测试工具monkey 2.3. Monkey的特征 1、测试的对象仅为应用程序包,有一定的局限性。 2、 Monky测试使用的事件流数据流是随机的,不能进行自定义。 3、可对Test的对象,事件数量,类型,频率等进行设置。 3.测试过程说明 3.1.测试案例 下面是一个更为典型的命令行示例,它启动指定的应用程序,并向其发送10000个伪随机事件: monkey -p com.winlu.etg --ignore-crashes -s 100 --throttle 100 -v -v -v 100000 >D:\monkeylog.txt & com.winlu.etg (包名) -ignore-crashes 忽略崩溃,继续测试,若不做此限制,monkey测试出现崩溃时会自动停止测试 --throttle延时1000=1秒 -v -v -v 100000随机点击次数 -s 100为随机数的事件序列定一个值,若出现问题下次可以重复同样的系列进行排错 >D:\monkeylog.txt把monkey日志打出到设备储存,当测试发现出现错误时,就应该重新执行测试,把日志打出观看 & 即使把数据线从电脑上拔开,monkey测试依然会在设备上进行 举例: Android SDK 连接真机设备,Window打开CMD,命令行输入:adb shell,进入shell界面后:性能测试报告范例 - X项目AB系统性能测试报告

功能测试报告(精简版)

流量计性能测定实验报告doc

项目性能测试报告

测试报告范例

性能测试报告模板

手机性能测试报告

软件测试实验报告LoadRunner的使用

软件系统性能测试总结报告

Android性能测试报告