linux平台CEGUI及OGRE的安装配置

IntelCE平台CEGUI及OGRE的安装配置

IntelCE嵌入式平台上要使用CEGUI作为用户图形界面,CEGUI支持的render系统里包括DirectFB,OpenGL,Irrlicht,Ogre 四种,不支持OpenGL | ES直接渲染。OpenGL ES (OpenGL for Embedded Systems) 是OpenGL 三维图形API 的子集,针对手机、PDA 和游戏主机等嵌入式设备而设计。为了能支持CEGUI使用OpenGL | ES渲染,我们选择OGRE-1.7.1版本来作为IntelCE平台CEGUI的渲染器,因为它支持OpenGL | ES。

先下载Linux平台的OGRE-1.7.1源码包。https://www.sodocs.net/doc/009663841.html,/download有事先编译好的SDK开发包,但是只有Windows平台以及Mac和iPhone平台才有,Linux平台只能自己动手编译源码。

tar jxvf ogre_src_v1-7-1.tar.bz2

cd ogre_src_v1-7-1

cmake ./ (最新版本的源码包是用CMake工具来管理的,不是熟悉的automake) make

make install

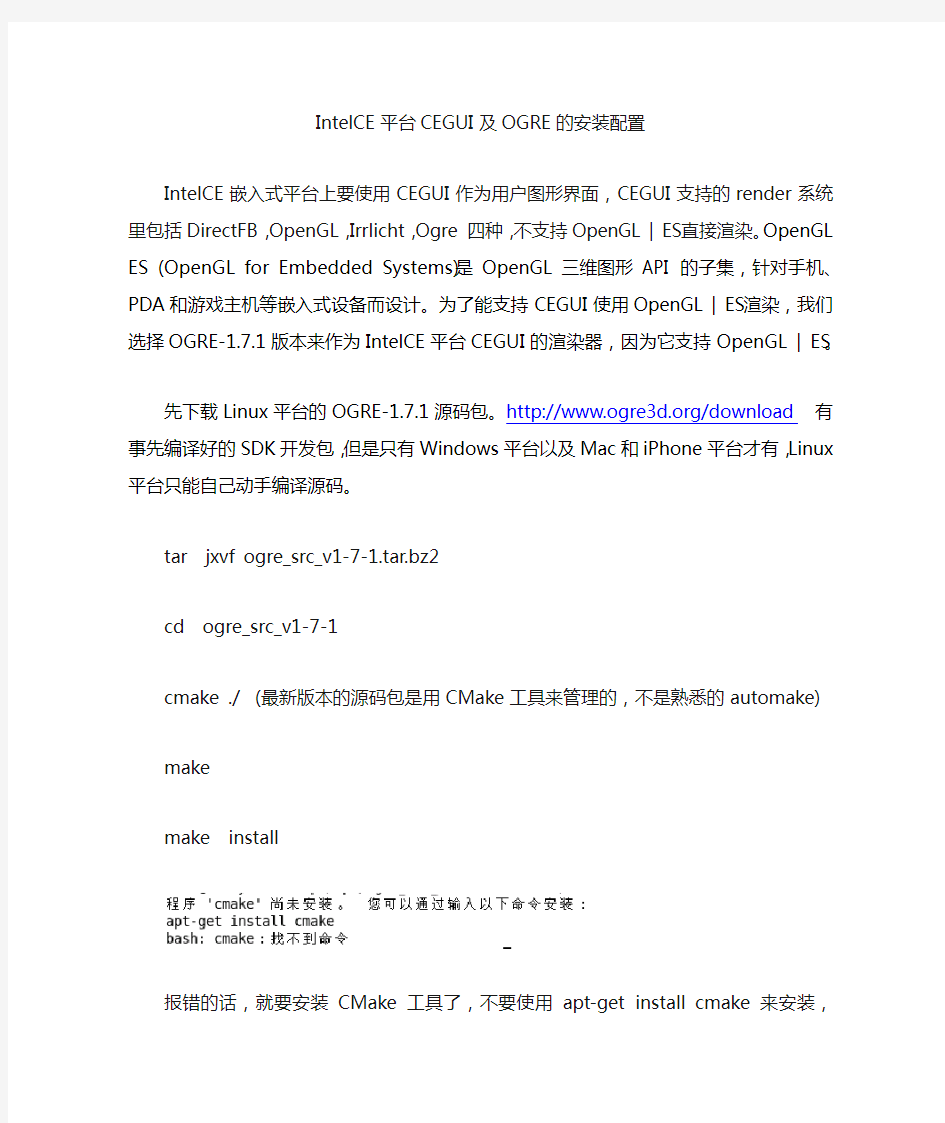

报错的话,就要安装CMake工具了,不要使用apt-get install cmake 来安装,ubuntu 主服务器上的软件版本不是很新,会出现警告

若安装上了,可以apt-get remove cmake –purge 来卸载掉。

下载cmake-2.6.4.tar.gz,手动编译安装上即可。

运行cmake ./ 时,会报错bash: /usr/bin/cmake: 没有该文件或目录!

cp /usr/local/bin/cmake /usr/bin/ 即可。

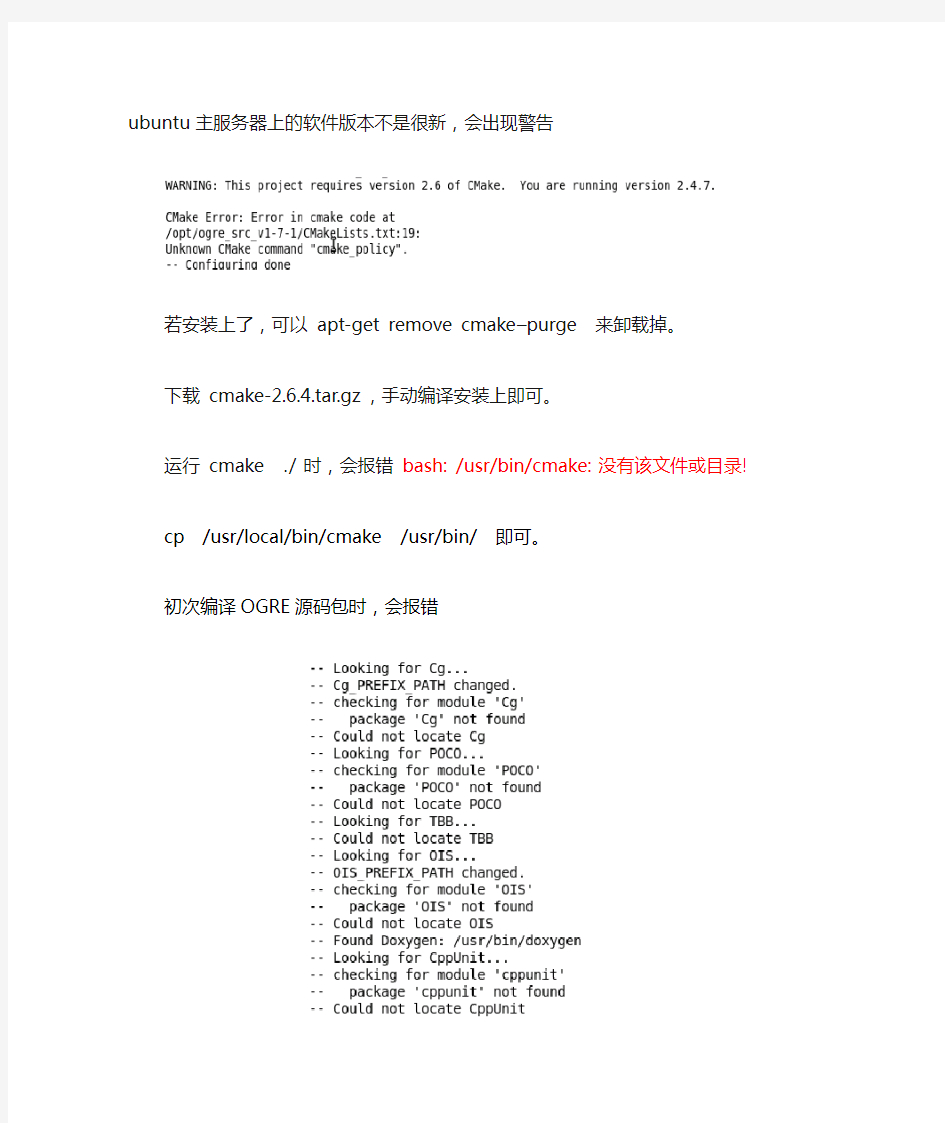

初次编译OGRE源码包时,会报错

OGRE-1.7.1缺少很多依赖库,需要自己下载编译安装。注意版本问题。OGRE-1.7.1对依赖库版本要求比较严格。Cg-2.2 FreeImage-3.13.1 freetype-2.3.11 ois-1.2.0 zlib-1.2.3 zziplib-0.13.57

先安装xaw库,apt-get install libxaw7-dev

下载Cg-2.2_February2009_x86.tgz

注意:Cg-2.2_February2009_x86.tgz这个包不需要编译,直接解压到/usr 下面即可,记得要到根目录下面解压!

下载zziplib-0.13.57.tar.bz2 编译安装

下载poco_1.3.6p1.orig.tar.gz 编译安装

下载FreeImage3131.zip 编译安装

安装CppUnit apt-get install libcppunit-dev

安装xrandr apt-get install libxrandr-dev

安装boost apt-get install libboost-dev

安装boost-pthread apt-get install libboost-thread-dev

安装boost-date-time apt-get install libboost-date-time-dev

注意:OIS (Object-oriented Input Library)库的安装是最繁琐的,它是一个输入库。记得一定要选择能与OGRE-1.7.1匹配的版本ois-1.2.0,不要使用apt-get install 命令从ubuntu的主服务器上下载,自动下载的那个是较早的版本,其中OGRE需要的某些接口在它里面是没有定义的。链接时会报错。我们下载ois_1.2.0.tar.gz,但是很遗憾这个解

压之后,运行

./bootstrap 脚本,使用automake autoconf工具自动编译会发生错误。脚本文件缺少某些宏定义。所以只能去网上寻找编译好的安装包libois-1.2.0_1.2.0-1_i386.deb,

执行dpkg –i libois-1.2.0_1.2.0-1_i386.deb 安装开发包,注意:安装完之后,需要我们自己动手把ois_1.2.0.tar.gz代码包中的头文件拷贝到系统路径下。否则编译OGRE的过程中会出问题。

还有一个简单的办法,下载ois-1.2.0-2-i686.pkg.tar.xz包,直接解压,会将头文件以及库文件自动解压到系统路径下,但是需要安装xz格式的解压工具xz-4.999.9beta.tar.bz2

tar jxvf xz-4.999.9beta.tar.bz2

cd xz-4.999.9beta

make

make install

xz -d ois-1.2.0-2-i686.pkg.tar.xz

tar xvf ois-1.2.0-2-i686.pkg.tar

这个方法比较简单高效,注意把解压好的东西放到系统路径下就OK了,正好就是1.2.0版本的头文件和共享库。

安装POCO库,POCO C++库是开源的用于简化和加速C++开发面向网络、可移植应用程序的C++库集,注意下载最新发布的poco-1.3.6p2.tar.gz版本,有两种源码包,一种是Complete Edition,包含OpenSSL, MySQL Client and ODBC等较大的依赖库,一种是Basic Edition,不含依赖库,易于编译开发。我们选的就是精简版的poco-1.3.6p2.tar.gz

安装TBB库,下载tbb_2.0r014.orig.tar.gz,不要用apt-get install 命令来安装。

用OGRE做渲染器,编译CEGUI的时候,可能会报错,

/usr/lib64/opengl/nvidia/lib/libGLcore.so.1: undefined reference to `_nv000016gl'

/usr/lib64/opengl/nvidia/lib/libGLcore.so.1: undefined reference to `_nv000003gl'

/usr/lib64/opengl/nvidia/lib/libGLcore.so.1: undefined reference to `_nv000027gl'

/usr/lib64/opengl/nvidia/lib/libGLcore.so.1: undefined reference to `_nv000025gl'

/usr/lib64/opengl/nvidia/lib/libGLcore.so.1: undefined reference to `_nv000034gl'

/usr/lib64/opengl/nvidia/lib/libGLcore.so.1: undefined reference to `_nv000018gl'

/usr/lib64/opengl/nvidia/lib/libGLcore.so.1: undefined reference to `_nv000013gl'

/usr/lib64/opengl/nvidia/lib/libGLcore.so.1: undefined reference to `_nv000005gl'

/usr/lib64/opengl/nvidia/lib/libGLcore.so.1: undefined reference to `_nv000022gl'

/usr/lib64/opengl/nvidia/lib/libGLcore.so.1: undefined reference to `_nv000008gl'

/usr/lib64/opengl/nvidia/lib/libGLcore.so.1: undefined reference to `_nv000002gl'

/usr/lib64/opengl/nvidia/lib/libGLcore.so.1: undefined reference to `_nv000030gl'

/usr/lib64/opengl/nvidia/lib/libGLcore.so.1: undefined reference to `_nv000033gl'

/usr/lib64/opengl/nvidia/lib/libGLcore.so.1: undefined reference to `_nv000004gl'

/usr/lib64/opengl/nvidia/lib/libGLcore.so.1: undefined reference to `_nv000036gl'

/usr/lib64/opengl/nvidia/lib/libGLcore.so.1: undefined reference to `_nv000031gl'

/usr/lib64/opengl/nvidia/lib/libGLcore.so.1: undefined reference to `_nv000028gl'

/usr/lib64/opengl/nvidia/lib/libGLcore.so.1: undefined reference to `_nv000024gl'

/usr/lib64/opengl/nvidia/lib/libGLcore.so.1: undefined reference to `_nv000029gl'

/usr/lib64/opengl/nvidia/lib/libGLcore.so.1: undefined reference to `_nv000012gl'

/usr/lib64/opengl/nvidia/lib/libGLcore.so.1: undefined reference to `_nv000020gl'

/usr/lib64/opengl/nvidia/lib/libGLcore.so.1: undefined reference to `_nv000026gl'

/usr/lib64/opengl/nvidia/lib/libGLcore.so.1: undefined reference to `_nv000019gl'

/usr/lib64/opengl/nvidia/lib/libGLcore.so.1: undefined reference to `_nv000010gl'

/usr/lib64/opengl/nvidia/lib/libGLcore.so.1: undefined reference to `_nv000011gl'

/usr/lib64/opengl/nvidia/lib/libGLcore.so.1: undefined reference to `_nv000017gl'

/usr/lib64/opengl/nvidia/lib/libGLcore.so.1: undefined reference to `_nv000021gl'

/usr/lib64/opengl/nvidia/lib/libGLcore.so.1: undefined reference to `_nv000035gl'

/usr/lib64/opengl/nvidia/lib/libGLcore.so.1: undefined reference to `_nv000006gl'

/usr/lib64/opengl/nvidia/lib/libGLcore.so.1: undefined reference to `_nv000009gl'

/usr/lib64/opengl/nvidia/lib/libGLcore.so.1: undefined reference to `_nv000007gl'

/usr/lib64/opengl/nvidia/lib/libGLcore.so.1: undefined reference to `_nv000023gl'

/usr/lib64/opengl/nvidia/lib/libGLcore.so.1: undefined reference to `_nv000014gl'

/usr/lib64/opengl/nvidia/lib/libGLcore.so.1: undefined reference to `_nv000037gl'

/usr/lib64/opengl/nvidia/lib/libGLcore.so.1: undefined reference to `_nv000032gl'

这个是显卡驱动的问题,笔者显卡是Geforce 9100 老版显卡驱动会报错,去NVIDIA官网上下载的NVIDIA-Linux-x86-256.44.run 最新版本的驱动程序。退出图形界面,进入控制台下,sh NVIDIA-Linux-x86-256.44.run -k $(uname -r) 安装,重启,再次编译OGRE 做renderer的CEGUI顺利通过。

可能安装完新的显卡驱动之后,GLX库libglx.so 会出问题,运行CEGUI的Demo会报错,这时卸载掉新版本显卡驱动用Envyng重新安装老版本驱动就OK了。新显卡驱动就是为了编译CEGUI而安装的。

运行CEGUI的Demo时。也可能会出现找不到plugins.cfg,加载失败的错误。只要locate 一下plugins.cfg这个文件拷贝到Demo的当前目录就OK了。

Hadoop集群MYSQL的安装指南

前言 本篇主要介绍在大数据应用中比较常用的一款软件Mysql,我相信这款软件不紧紧在大数据分析的时候会用到,现在作为开源系统中的比较优秀的一款关系型开源数据库已经被很多互联网公司所使用,而且现在正慢慢的壮大中。 在大数据分析的系统中作为离线分析计算中比较普遍的两种处理思路就是:1、写程序利用 mapper-Reducer的算法平台进行分析;2、利用Hive组件进行书写Hive SQL进行分析。 第二种方法用到的Hive组件存储元数据最常用的关系型数据库最常用的就是开源的MySQL了,这也是本篇最主要讲解的。 技术准备 VMware虚拟机、CentOS 6.8 64 bit、SecureCRT、VSFTP、Notepad++ 软件下载 我们需要从Mysql官网上选择相应版本的安装介质,官网地址如下: MySQL下载地址:https://www.sodocs.net/doc/009663841.html,/downloads/

默认进入的页面是企业版,这个是要收费的,这里一般建议选择社区开源版本,土豪公司除外。

然后选择相应的版本,这里我们选择通用的Server版本,点击Download下载按钮,将安装包下载到本地。 下载完成,上传至我们要安装的系统目录。 这里,需要提示下,一般在Linux系统中大型公用的软件安装在/opt目录中,比如上图我已经安装了Sql Server On linux,默认就安装在这个目录中,这里我手动创建了mysql目录。 将我们下载的MySQL安装介质,上传至该目录下。

安装流程 1、首先解压当前压缩包,进入目录 cd /opt/mysql/ tar -xf mysql-5.7.16-1.el7.x86_64.rpm-bundle.tar 这样,我们就完成了这个安装包的解压。 2、创建MySql超级管理用户 这里我们需要单独创建一个mySQL的用户,作为MySQL的超级管理员用户,这里也方便我们以后的管理。 groupaddmysql 添加用户组 useradd -g mysqlmysql 添加用户 id mysql 查看用户信息。

4Mlinux安装配置方法

4Mlinux安装配置 一、安装4Mlinux 1.新建otherlinux虚拟机 2.硬件资源分配,硬盘不要超过1G,600M足够否则安装会很慢,必须为IDE接口硬盘。 内存256M即可。 设置硬盘大小:

硬件资源分配图 3.配置好硬件资源后可能会无法选择硬盘接口类型,可以删除原来的,再添加一个

删除SCSI接口的硬盘,添加一个IDE接口的硬盘 设置硬盘接口为IDE的类型,绝对不能用SCSI的,否则不能识别

设置大小为600M 删除原来的SCSI接口硬盘,其他的按回车就可以了。

4.选择iso安装镜像从CD/DVD启动 5.启动后会进入一个类似安装系统界面,但是这不是安装界面 6.这里可以不输入密码,按回车就可以了 7.Root账号登陆,没有设置密码,回车就可以了

8.登陆之后,用“fdisk/dev/sda”新建一个主分区,等下系统就是安装在这个分区里的。 分区新建之后,由于这里无法探测分区,所以用reboot重启系统。 格式化为ext3 9.进入/usr/sbin/目录下,找到一个名为install2hd的文件拷贝到/tmp目录下 拷贝到/tmp目录下,注意这里一定要拷贝到/tmp/目录下,因为等下要修改这个脚本文件,而且执行后文件会改变 到/tmp目录下修改这个脚本文件,用“/df-h”查找到相关内容,将原来为G的单位改为M 将G改为M 保存退出 10.执行“./install2hd/dev/sda”安装系统到“/dev/sda1”分区下 执行这条命令后选分区时选择1,其余回车或y就可以了。安装完后重启系统就可以了 二、网络配置 到/etc/net/net.conf里面配置网络。 根据需求配置网络即可。

Hadoop全分布式安装配置

Hadoop全分布式安装配置 一实验目的: 1、了解Hadoop的体系结构、组成; 2、熟练掌握Hadoop的配置、安装方法; 3、通过安装Hadoop了解Hadoop的原理; 二实验内容: 集群包含三个安装了Linux操作系统的节点。将其中的一个节点作为NameNode,另外两个节点作为DataNode,安装之前先利用ping命令,确认三个节点之间的网络互通,即可以互相ping通。假设三个节点IP地址如下,实际的集群节点IP地址可以不同。 NameNode:192.168.198.2 主机名:master DataNode1:192.168.198.3 主机名:slaver1 DataNode2:192.168.198.4 主机名:slaver2 三实验环境: 在申请的虚拟服务器上安装了VMWare Workstation虚拟3个Ubuntu14.04系统。 四安装配置过程: 1、安装Vmware WorkStation软件 下载安装Vmware WorkStation12.0软件。 2、在虚拟机上安装linux操作系统 在Vmware WorkStation12.0中创建一个Ubuntu14.04系统。拷贝镜像文件复制出三个系统。分别为master、slaver1、slaver2。 3、配置hosts、hostname文件

在三台机器上配置相同的hosts文件 (1)修改hosts sudo gedit /etc/hosts 192.168.198.200 master 192.168.198.199 slave1 192.168.198.198 slave2 (2)修改hostname sudo gedit /etc/hostname 4、配置ip地址 配置ip:sudo gedit /etc/network/interfaces slave2 auto eth0 iface eth0 inet static address 192.168.198.198 gateway 192.168.198.107 netmask 255.255.255.0 slave1 auto eth0 iface eth0 inet static address 192.168.198.199 gateway 192.168.198.107 netmask 255.255.255.0 master auto eth0 iface eth0 inet static address 192.168.198.200 gateway 192.168.198.107 netmask 255.255.255.0

hadoop集群完整配置过程详细笔记

本文为笔者安装配置过程中详细记录的笔记 1.下载hadoop hadoop-2.7.1.tar.gz hadoop-2.7.1-src.tar.gz 64位linux需要重新编译本地库 2.准备环境 Centos6.4 64位,3台 hadoop0 192.168.1.151namenode hadoop1 192.168.1.152 datanode1 Hadoop2 192.168.1.153 datanode2 1)安装虚拟机: vmware WorkStation 10,创建三台虚拟机,创建时,直接建立用户ha,密码111111.同时为root密码。网卡使用桥接方式。 安装盘 、 2). 配置IP.创建完成后,设置IP,可以直接进入桌面,在如下菜单下配置IP,配置好后,PING 确认好用。 3)更改三台机器主机名 切换到root用户,更改主机名。 [ha@hadoop0 ~]$ su - root Password: [root@hadoop0 ~]# hostname hadoop0 [root@hadoop0 ~]# vi /etc/sysconfig/network NETWORKING=yes HOSTNAME=hadoop0 以上两步后重启服务器。三台机器都需要修改。 4)创建hadoop用户 由于在创建虚拟机时,已自动创建,可以省略。否则用命令创建。

5)修改hosts文件 [root@hadoop0 ~]# vi /etc/hosts 127.0.0.1 localhostlocalhost.localdomain localhost4 localhost4.localdomain4 ::1localhostlocalhost.localdomain localhost6 localhost6.localdomain6 192.168.1.151 hadoop0 192.168.1.152 hadoop1 192.168.1.153 hadoop2 此步骤需要三台机器都修改。 3.建立三台机器间,无密码SSH登录。 1)三台机器生成密钥,使用hadoop用户操作 [root@hadoop0 ~]# su– ha [ha@hadoop0 ~]$ ssh -keygen -t rsa 所有选项直接回车,完成。 以上步骤三台机器上都做。 2)在namenode机器上,导入公钥到本机认证文件 [ha@hadoop0 ~]$ cat ~/.ssh/id_rsa.pub>>~/.ssh/authorized_keys 3)将hadoop1和hadoop2打开/home/ha/.ssh/ id_rsa.pub文件中的内容都拷贝到hadoop0的/home/ha /.ssh/authorized_keys文件中。如下: 4)将namenode上的/home/ha /.ssh/authorized_keys文件拷贝到hadoop1和hadoop2的/home/ha/.ssh文件夹下。同时在三台机器上将authorized_keys授予600权限。 [ha@hadoop1 .ssh]$ chmod 600 authorized_keys 5)验证任意两台机器是否可以无密码登录,如下状态说明成功,第一次访问时需要输入密码。此后即不再需要。 [ha@hadoop0 ~]$ ssh hadoop1 Last login: Tue Aug 11 00:58:10 2015 from hadoop2 4.安装JDK1.7 1)下载JDK(32或64位),解压 [ha@hadoop0 tools]$ tar -zxvf jdk-7u67-linux-x64.tar.gz 2)设置环境变量(修改/etx/profile文件), export JAVA_HOME=/usr/jdk1.7.0_67 export CLASSPATH=:$CLASSPATH:$JAVA_HOME/lib:$JAVA_HOME/jre/lib export PATH=$PATH:$JAVA_HOME/bin:$JAVA_HOME/jre/bin 3)使环境变量生效,然后验证JDK是否安装成功。

hadoop3安装和配置

hadoop3.0.0安装和配置1.安装环境 硬件:虚拟机 操作系统:Centos 7 64位 IP:192.168.0.101 主机名:dbp JDK:jdk-8u144-linux-x64.tar.gz Hadoop:hadoop-3.0.0-beta1.tar.gz 2.关闭防火墙并配置主机名 [root@dbp]#systemctl stop firewalld #临时关闭防火墙 [root@dbp]#systemctl disable firewalld #关闭防火墙开机自启动 [root@dbp]#hostnamectl set-hostname dbp 同时修改/etc/hosts和/etc/sysconfig/network配置信息 3.配置SSH无密码登陆 [root@dbp]# ssh-keygen -t rsa #直接回车 [root@dbp]# ll ~/.ssh [root@dbp .ssh]# cp id_rsa.pub authorized_keys [root@dbp .ssh]# ssh localhost #验证不需要输入密码即可登录

4.安装JDK 1、准备jdk到指定目录 2、解压 [root@dbp software]# tar–xzvf jdk-8u144-linux-x64.tar.gz [root@dbp software]# mv jdk1.8.0_144/usr/local/jdk #重命名4、设置环境变量 [root@dbp software]# vim ~/.bash_profile 5、使环境变量生效并验证 5.安装Hadoop3.0.0 1、准备hadoop到指定目录 2、解压

Linux操作系统的安装配置(吐血之作)

Linux操作系统的安装配置 文档记录: RedHat操作系统的安装 1.放入REDHAT ENTERPRISE LINUX 5.0安装光盘,并 设置为光盘启动。 启动成功后,如图1。输入linux text(采用文本模式)确认回车。

建议:REDHAT ENTERPRISE LINUX 5.0支持新服务器驱动,如:HP380G6 2.选择在准备安装之前是否检测光驱 一般选择SKIP跳过,开始安装,如图2:

3.选择安装过程的语言 选择English (在linux中使用Tab,切换光标的位置,使用空格键选中选项)回车,如图3: 4.选择键盘 选择US(美国键盘)回车,如图4:

5.选择安装LINUX服务代码 序列号为:2515dd4e215225dd 安装与不安装的区别: 红帽企业版的服务代码,不仅仅是升级,还包含很多售后服务和技术支持,如图5: 6.选择分区方法 选择Create custom layout,如图6:

7.分区 使用F2新建一个分区,出现图7: Mount Point :Bstarsrv1 挂接点,像/root、/bin、/etc、/usr、/home等等。 Filesystem Type:文件格式,例如windows中的fat32格式,windows 2000中的ntfs格式。Bstarsrv1中现在最常用的是

ext3、swap等。Swap是交换分区格式。 Fixed Size:自定义空间大小。 Fill all available space:使用所有可用空间 Force to be a primary partition:强制使用主分区 Check for a bad block :检测坏块 一般只需要将系统分为3个分区,同样的方法建立以下分区。/boot 启动目录100M swap 数据交换分区内存的2倍 / 根目录Fill all available space 建立数据交换分区时,不用输入挂接点,直接在File system 中,使用上下键选择swap格式,大小为内存的2倍。如图8: (根据实际调整仅供参考)下图是在8G的硬盘分区示意图9:

hadoop安装简要过程和相关配置文件

Hadoop安装简要过程及配置文件 1、机器准备 ①、Linux版操作系统centos 6.x ②、修改主机名,方便配置过程中记忆。修改文件为: /etc/sysconfig/network 修改其中的HOSTNAME即可 ③、配置局域网内,主机名与对应ip,并且其中集群中所有的机器的文件相同,修改文件为 /etc/hosts 格式为: 10.1.20.241 namenode 10.1.20.242 datanode1 10.1.20.243 datanode2 2、环境准备 ①、配置ssh免密码登陆,将集群中master节点生成ssh密码文件。具体方法: 1)、ssh-keygen -t rsa 一直回车即可,将会生成一份 ~/.ssh/ 文件夹,其中id_rsa为私钥文件 id_rsa.pub公钥文件。 2)、将公钥文件追加到authorized_keys中然后再上传到其他slave节点上 追加文件: cat ~/.ssh/id_rsa.pub >> ~/.ssh/authorized_keys 上传文件: scp ~/.ssh/authorized_keys root@dananode:~/.ssh/ 3)、测试是否可以免密码登陆:ssh 主机名或局域网ip ②、配置JDK ③、创建hadoop用户 groupadd hadoop useradd hadoop -g hadoop 4)、同步时间 ntpdate https://www.sodocs.net/doc/009663841.html, 5)、关闭防火墙 service iptables stop 3、安装cdh5 进入目录/data/tools/ (个人习惯的软件存储目录,你可以自己随便选择); wget "https://www.sodocs.net/doc/009663841.html,/cdh5/one-click-install/redhat/ 6/x86_64/cloudera-cdh-5-0.x86_64.rpm" yum --nogpgcheck localinstall cloudera-cdh-5-0.x86_64.rpm 添加cloudera仓库验证: rpm --importhttps://www.sodocs.net/doc/009663841.html,/cdh5/redhat/6/x86_64/cdh/RPM-GPG-KEY-cloudera

Hadoop的安装与配置及示例wordcount的运行

Hadoop的安装与配置及示例程序 wordcount的运行 目录 前言 (1) 1 机器配置说明 (2) 2 查看机器间是否能相互通信(使用ping命令) (2) 3 ssh设置及关闭防火墙 (2) 1)fedora装好后默认启动sshd服务,如果不确定的话可以查一下[garon@hzau01 ~]$ service sshd status (3) 2)关闭防火墙(NameNode和DataNode都必须关闭) (3) 4 安装jdk1.6(集群中机子都一样) (3) 5 安装hadoop(集群中机子都一样) (4) 6 配置hadoop (4) 1)配置JA V A环境 (4) 2)配置conf/core-site.xml、conf/hdfs-site.xml、conf/mapred-site.xml文件 (5) 3)将NameNode上完整的hadoop拷贝到DataNode上,可先将其进行压缩后直接scp 过去或是用盘拷贝过去 (7) 4)配置NameNode上的conf/masters和conf/slaves (7) 7 运行hadoop (7) 1)格式化文件系统 (7) 2)启动hadoop (7) 3)用jps命令查看进程,NameNode上的结果如下: (8) 4)查看集群状态 (8) 8 运行Wordcount.java程序 (8) 1)先在本地磁盘上建立两个文件f1和f2 (8) 2)在hdfs上建立一个input目录 (9) 3)将f1和f2拷贝到hdfs的input目录下 (9) 4)查看hdfs上有没有f1,f2 (9) 5)执行wordcount(确保hdfs上没有output目录) (9) 6)运行完成,查看结果 (9) 前言 最近在学习Hadoop,文章只是记录我的学习过程,难免有不足甚至是错误之处,请大家谅解并指正!Hadoop版本是最新发布的Hadoop-0.21.0版本,其中一些Hadoop命令已发生变化,为方便以后学习,这里均采用最新命令。具体安装及配置过程如下:

4Mlinux安装配置方法

4Mlinux 安装配置 一、安装4Mlinux 1.新建otherlinux虚拟机 2.硬件资源分配,硬盘不要超过1G,600M足够否则安装会很慢,必须为IDE接口硬盘。 内存256M即可。 设置硬盘大小:

硬件资源分配图 3.配置好硬件资源后可能会无法选择硬盘接口类型,可以删除原来的,再添加一个

删除SCSI接口的硬盘,添加一个IDE接口的硬盘 设置硬盘接口为IDE的类型,绝对不能用SCSI的,否则不能识别

设置大小为600M 删除原来的SCSI接口硬盘,其他的按回车就可以了。

4.选择iso安装镜像从CD/DVD启动 5.启动后会进入一个类似安装系统界面,但是这不是安装界面 6.这里可以不输入密码,按回车就可以了 7.Root账号登陆,没有设置密码,回车就可以了

8.登陆之后,用“fdisk /dev/sda”新建一个主分区,等下系统就是安装在这个分区里的。 分区新建之后,由于这里无法探测分区,所以用reboot重启系统。 格式化为ext3 9.进入/usr/sbin/目录下,找到一个名为install2hd 的文件拷贝到/tmp目录下 拷贝到/tmp目录下,注意这里一定要拷贝到/tmp/目录下,因为等下要修改这个脚本文件,而且执行后文件会改变 到/tmp目录下修改这个脚本文件,用“/df -h”查找到相关内容,将原来为G的单位改为M 将G改为M 保存退出 10.执行“./install2hd /dev/sda”安装系统到“/dev/sda1”分区下 执行这条命令后选分区时选择1,其余回车或y就可以了。安装完后重启系统就可以了 二、网络配置 到/etc/net/net.conf里面配置网络。 根据需求配置网络即可。

Hadoop安装手册_Hadoop2.0-v1.6

Hadoop2.0安装手册目录 第1章安装VMWare Workstation 10 (4) 第2章VMware 10安装CentOS 6 (10) 2.1 CentOS系统安装 (10) 2.2 安装中的关键问题 (13) 2.3 克隆HadoopSlave (17) 2.4 windows中安装SSH Secure Shell Client传输软件 (19) 第3章CentOS 6安装Hadoop (23) 3.1 启动两台虚拟客户机 (23) 3.2 Linux系统配置 (24) 3.2.1软件包和数据包说明 (25) 3.2.2配置时钟同步 (25) 3.2.3配置主机名 (26) 3.2.5使用setup 命令配置网络环境 (27) 3.2.6关闭防火墙 (29) 3.2.7配置hosts列表 (30) 3.2.8安装JDK (31) 3.2.9免密钥登录配置 (32) 3.3 Hadoop配置部署 (34) 3.3.1 Hadoop安装包解压 (34) 3.3.2配置环境变量hadoop-env.sh (34) 3.3.3配置环境变量yarn-env.sh (35) 3.3.4配置核心组件core-site.xml (35) 3.3.5配置文件系统hdfs-site.xml (35) 3.3.6配置文件系统yarn-site.xml (36) 3.3.7配置计算框架mapred-site.xml (37) 3.3.8 在master节点配置slaves文件 (37) 3.3.9 复制到从节点 (37) 3.4 启动Hadoop集群 (37) 3.4.1 配置Hadoop启动的系统环境变量 (38) 3.4.2 创建数据目录 (38) 3.4.3启动Hadoop集群 (38) 第4章安装部署Hive (44) 4.1 解压并安装Hive (44) 4.2 安装配置MySQL (45) 4.3 配置Hive (45) 4.4 启动并验证Hive安装 (46) 第5章安装部署HBase (49) 5.1 解压并安装HBase (49) 5.2 配置HBase (50) 5.2.1 修改环境变量hbase-env.sh (50) 5.2.2 修改配置文件hbase-site.xml (50) 5.2.3 设置regionservers (51)

LINUX安装配置手册

封面

作者:PanHongliang 仅供个人学习 LINUX服务器 安装配置手册 杭州世导科技有限公司

文档修改/审批记录

目录1介质准备5 2REDHAT LINUX 的安装6 2.1安装步骤6 2.2R EDHA T 9.0的配置:9 2.2.1其他应用环境配置10

1介质准备 安装介质:Redhat linux9.0,安装光盘三张;

2Redhat linux 的安装 2.1安装步骤 1、首先接通服务器的电源,插入Redhat 系统安装盘1,直到下面界 面出现: 2、安装的界面有图形化用户界面GUI(graphical user interface)--默认方式、直观、用鼠标在屏幕间翻阅、“点击”按 钮,或输入文字字段、简单直观,和文本模式界面,要用这种模式,需 在引导时输入 boot:text ***:推荐使用GUI模式与光盘安装模式;,下面就开始介绍这种模式的安装步骤; 点击“Next”按钮,出现下面的界面. 在这里选择安装界面的语言,选“中文简体”,这样安装界面就是简体中文的了.点击“Next”. 然后点“下一步”. 接着选择一下你的鼠标类型.选择完后,点击“下一步”.在安装类型选择时,选择“定制”.点击“下一步”.安装类型: 个人桌面:适合于新手,有图形化桌面环境(X窗口系统),需要1.8G(兼选GNOME/KDE的个人桌面);如果你需要选择所有的软件包组的话,可能至少需要4G的空间; 工作站:队了有图形化桌面环境外,还具备软件开发工具 服务器:要注意一点,如果你在安装软件时,在选择软件包时没有安装适当的软件包,当系统引导时,X窗口系统不会被配置,因而不会载入GUI 定制:根据你自己的需要来定制你所要安装的软件包,灵活性、随意性较强 升级:如果你使用的一个版本是低于8.0,此时你可以选择这种安装方式(在6.2以上版本是不会破坏现有旧系统里面的数据,只会更新新的内核和软件包); 如果你选择了自动分区的话,系统会创建以下几个分区: 1)交换分区,一般建议为你的内存的2倍 2)/boot分区,大小为100MB,其中驻留着Linux内核和相关的文件 3)/根分区,其中贮存着所有其它文件,大小根据你实际硬盘的大小来分区 在以上三个分区的基础上,服务器安装还会挂载一个/usr的分区,一个/home的分区,一个大小为/var的分区,大小256M; 然后选择“用 Disk Druid 手工分区”,点击“下一步”.由于COMPAQ机器本身会使用8M的硬盘空间来引导系统COMPAQ SETUP ,所以这个分区就不用去动它;/dev/sda3这8M不用去动它1)/boot分区,大小为200MB,其中驻留着Linux内核和相关的文件 2)交换分区,为你的内存的2倍,考虑到以后有扩展内存的可能,建议将SWAP分区加大1G 3)/根分区,其中贮存着所有其它文件,大小根据你实际硬盘的大小来分区,把余下的空间分给它 4)在此基础上增加一个/tmp空间,大小为1G,用于ORACLE时存放备用文件

Hadoop安装部署手册

1安装环境介绍1.1软件环境 1)CentOS6.5x64 2)Jdk1.7x64 3)Hadoop2.6.2x64 4)Hbase-0.98.9 5)Zookeeper-3.4.6 1.2集群环境 集群中包括3个节点:1个Master,2个Slave 2安装前的准备 2.1下载JDK 2.2下载Hadoop 2.3下载Zookeeper 2.4下载Hbase 3开始安装 3.1CentOS安装配置 1)安装3台CentOS6.5x64(使用BasicServer模式,其他使用默认配置,安装过程略) 2)Master.Hadoop配置 a) 配置网络

保存,退出(esc+:wq+enter),使配置生效 b) 配置主机名 修改为: c) 配置hosts 修改为: 修改为: 在最后增加如下内容 以上调整,需要重启系统才能生效 g) 配置用户 新建hadoop用户和组,设置hadoop用户密码

id_rsa 和id_rsa.pub ,默认存储在 "/home/hadoop/.ssh"目录下。 a) 把id_rsa.pub 追加到授权的key 里面去 b) 修改 .ssh 目录的权限以及 authorized_keys 的权限 c) 用root 用户登录服务器修改SSH 配置文件"/etc/ssh/sshd_config" 的下列内容 3) Slave1.Hadoop 、Slave1.Hadoop 配置 相同的方式配置Slave1和Slave2的IP 地址,主机名和hosts 文件,新建hadoop 用户和组及用户密码等等操作 3.2 无密码登陆配置 1) 配置Master 无密码登录所有Slave a) 使用hadoop 用户登陆Master.Hadoop b) 把公钥复制所有的Slave 机器上。使用下面的命令格式进行复制公钥 2) 配置Slave 无密码登录Master a) 使用hadoop 用户登陆Slave b) 把公钥复制Master 机器上。使用下面的命令格式进行复制公钥

Linux项目安装部署

1安装Jdk (1)安装 第一步:下载Linux环境下的jdk1.8,请去(官网)中下载jdk的安装文件; 由于我的Linux是32位的,因此我下载jdk-8u92-linux-i586.tar.gz文件。 解压: tar xzvf jdk-8u45-linux-i586.tar.gz 移动到opt目录: sudo mv jdk1.8.0_45 /opt (2)配置环境变量 ①、使用vim /etc/profile编辑profile文件 ②、在/etc/profile底部加入如下内容: JAVA_HOME=/opt/jdk1.8.0_92 PATH=$JAVA_HOME/bin:$PATH CLASSPATH=$JAVA_HOME/jre/lib/ext:$JAVA_HOME/lib/tools.jar export JAVA_HOME export PATH export CLASSPATH

输入:wq保存并退出,最后使用source /etc/profile让profile文件立即生效。 (3)测试命令 输入:java -version,如果看到如下截图说明你的jdk已经安装成功了。 2安装mysql (1)到mysql官网下载mysql编译好的二进制安装包,在下载页面Select Platform:选项选择linux-generic,然后把页面拉到底部,64位系统下载Linux - Generic (glibc 2.5) (x86, 64-bit),32位系统下载Linux - Generic (glibc 2.5) (x86, 32-bit) (2)解压32位安装包: 进入安装包所在目录,执行命令:tar mysql-5.6.17-linux-glibc2.5-i686.tar.gz (3)复制解压后的mysql目录到系统的本地软件目录: 执行命令:cp mysql-5.6.17-linux-glibc2.5-i686 /usr/local/mysql -r

Hadoop系统操作安装手册

基于网络音乐云Hadoop系统及MapReduce模型管理平台 V1.0 操作手册 北京华康嘉合科技有限公司

目录 一、服务器基础配置 (2) 二、实现Linux的ssh无密码验证配置 (2) 三、修改Linux机器名 (2) 四、安装JDK,并配置环境变量 (3) 五、安装Hadoop,并修改文件的配置 (3) 六、创建Hadoop备份的目录 (5) 七、将Hadoop的bin加入环境变量 (6) 八、修改部分运行文件的权限 (6) 九、格式化Hadoop,启动Hadoop (6) 十、新加datanode的安装步骤 (7)

一、服务器基础配置 首先,需要将服务器IP进行固定。 本文采用主机IP:10.0.0.30,分机:10.0.0.31; 主机名称:namenode,分机名称:datanode; 本文红色字体为终端命令或需修改添加部分。 二、实现Linux的ssh无密码验证配置 1.生成密钥:在namenode(主机)上,使用终端输入ssh-keygen –t rsa,一直回车,生成密钥; 2.在namenode上使用命令cd /root/.ssh进入文件夹,使用ls可查 看两个文件:id_rsa.pub,id_rsa; 3.然后执行cp id_rsa.pub authorized_keys;使用ssh localhost验证是 否成功,第一次需要输入登录密码,以后就不需要输入密码; 4.拷贝密钥: [root@namenode .ssh] #scp authorized_keys 10.0.0.31:/root/.ssh 这是拷贝命令,将namenode上的authorized_keys 拷贝到datanode的/root/.ssh 上; 5.验证是否成功,在namenode上输入ssh 10.0.0.31,第一次连接需 要输入yes,就可以连接到datanode上了,无需使用密码即为成功;此时,系统已登录至datanode下,不在namenode上了,可输入命令exit返回至namenode; 三、修改Linux机器名 1.查看主机名: 在命令行输入:hostname [root@namenode ~]# hostname namenode//这是你的主机名。 2.修改机器名 执行cd /etc/sysconfig ,进如sysconfig目录下 执行vi network,修改network文件(文件修改方法,键盘点击Insert键进入输入模式,修改好文件后,按Esc键退出输入模式,直接输入:w进行文件保存,:q退出编辑模式;也可在文件夹内选择需修改文件直接打开进行文件修改) NETWORKING=yes HOSTNAME=namenode(修改成你需要的)

Linux安装部署规范标准

Linux安装部署规文档 编制人员:石鹏 编制部门:运维事业部 模版文件版本:V1.1 适用项目围:所有

文件修改记录表

目录 1 安装前的准备工作 (6) 1.1 操作系统版本 (6) 1.2 操作系统的安装信息搜集 (6) 2 默认情况的Linux操作系统安装 (7) 2.1 安装语言的选择 (7) 2.2 分区的划分 (8) 2.2.1 boot分区 (8) 2.2.2 LVM分区 (8) 2.2.3 根分区 (10) 2.2.4 Swap空间 (10) 2.3 IP地址的配置 (11) 2.4 主机名的设定 (12) 2.5 时区的设定 (12) 2.6 密码的设定 (13) 2.7 软件包的定制 (13) 2.7.1 桌面环境 (13) 2.7.2 应用程序 (14) 2.7.3 开发环境 (14) 2.7.4 服务器 (15) 2.7.5 基础系统 (15) 2.7.6 虚拟化 (15) 2.7.7 语言 (16) 2.8 安装后的设置 (17) 2.8.1 防火墙设置 (17) 2.8.2 SELinux (17) 2.9 操作系统配置 (18) 2.9.1 文字界面启动 (18) 2.9.2 Root用户直接登陆系统 (18) 2.9.3 取消不用的服务 (18) 2.10 备份操作系统关键文件 (19) 3 针对Oracle数据库服务器的操作系统安装 (19) 3.1 安装语言的选择 (19) 3.2 分区的划分 (19) 3.2.1 boot分区 (19) 3.2.2 LVM分区 (20) 3.2.3 根分区 (20) 3.2.4 Swap空间 (20) 3.2.5 tmp分区 (20) 3.2.6 var分区 (21) 3.2.7 usr分区 (21) 3.2.8 u01分区 (22) 3.3 IP地址的配置 (22) 3.4 主机名的设定 (22) 3.5 时区的设定 (23) 3.6 密码的设定 (23) 3.7 软件包的定制 (23) 3.7.1 桌面环境 (23)

Hadoop详细安装配置过程

1.下载并安装安装ssh sudo apt-get install openssh-server openssh-client 3.搭建vsftpd #sudo apt-get update #sudo apt-get install vsftpd 配置参考的开始、关闭和重启 $sudo /etc/vsftpd start #开始 $sudo /etc/vsftpd stop #关闭 $sudo /etc/vsftpd restart #重启 4.安装 sudo chown -R hadoop:hadoop /opt cp /soft/ /opt sudo vi /etc/profile alias untar='tar -zxvf' sudo source /etc/profile source /etc/profile untar jdk* 环境变量配置 # vi /etc/profile ●在profile文件最后加上 # set java environment export JAVA_HOME=/opt/ export CLASSPATH=.:$JAVA_HOME/lib/:$JAVA_HOME/lib/ export PATH=$JAVA_HOME/bin:$PATH 配置完成后,保存退出。 ●不重启,更新命令 #source /etc/profile ●测试是否安装成功 # Java –version 其他问题: 出现unable to resolve host 解决方法 参考 开机时停在Starting sendmail 不动了的解决方案 参考安装软件时出现E: Unable to locate package vsftpd 参考vi/vim 使用方法讲解 参考分类: Hadoop

Linux下WebLogic 的安装配置及启动

Linux? Weblogic ??3 zhenhua_hou@https://www.sodocs.net/doc/009663841.html, 20100822 WebLogic 1 ǐ ? CentOS4.8 2 3'? 1:oracle wls1033_oepe111150_linux32.bin https://www.sodocs.net/doc/009663841.html,/technetwork/middleware/ias/downloads/wls-main-097127.html 2:ftp xFtp https://www.sodocs.net/doc/009663841.html,/download/down_xfp3.html 3:SSH SecureCRT,SSH,XShell 3 3? ?URRW/"? ? ?D ? ZHE/RJLF/"? KRPH ? mkdir -p /u02/weblogic

?üZHE/RJLF?/"? groupadd weblogic ?ü/ZHE/RJLF useradd -g weblogic -d /u02/weblogic weblogic "?ü?/" 3 passwd weblogic ? ? ? ? weblogic weblogic ? X " ???/" cd /u02 ls -la root root 4096 Aug 23 15:29 u02 ? X ? " ???/" ?%?ZHE/RJLF chown -R weblogic:weblogic /u02 /;IWS?ZOV BRHSH BOLQX[ ELQ? X ? ?ZOV BRHSH BOLQX[ ELQ" ?/"??/" cd /u02 ls -la root root 968036147 Aug 23 15:39 wls1033_oepe111150_linux32.bin

hadoop环境配置入门教程

ubuntu 下安装配置hadoop 1.0.4 第一次搞hadoop,折腾我2天,功夫不负有心人,终于搞好了,现在来分享下, 我的环境 操作系统:wmv虚拟机中的ubuntu12.04 hadoop版本:hadoop-1.0.4(听说是稳定版就下了) eclipse版本:eclipse-jee-indigo-SR2-win32 1.先安装好jdk,然后配置好jdk的环境变量,在这里我就不累赘了!网上多的是 2.安装ssh这个也不用说了 2.把hadoop-1.0.4.tar.gz拖到虚拟机中,解压,比如: /home/wys/Documents/hadoop-1.0.4/ (有的还单独建了个用户,为了舍去不必要的麻烦我都是用root用户来操作的) 3.修改hadoop-1.0.4/conf 下面的core-site.xml文件,如下:

192.168.116.128这个是虚拟机中ubuntu的ip,听说用localhost,127.0.0.1都不行,我没试过,直接写上ip地址了 tmp是预先创建的一个目录 4.修改hadoop-env.sh 把export JAVA_HOME=xxxxxx 这行的#号去掉,写上jdk的目录路径 5.修改hdfs-site.xml如下:

Hadoop安装配置超详细步骤

Hadoop的安装 1、实现linux的ssh无密码验证配置. 2、修改linux的机器名,并配置/etc/hosts 3、在linux下安装jdk,并配好环境变量 4、在windows下载hadoop 1.0.1,并修改hadoop-env.sh,core-site.xml, hdfs-site.xml, mapred-site.xml,masters,slaves文件的配置 5、创建一个给hadoop备份的文件。 6、把hadoop的bin加入到环境变量 7、修改部分运行文件的权限 8、格式化hadoop,启动hadoop 注意:这个顺序并不是一个写死的顺序,就得按照这个来。如果你知道原理,可以打乱顺序来操作,比如1、2、3,先哪个后哪个,都没问题,但是有些步骤还是得依靠一些操作完成了才能进行,新手建议按照顺序来。

一、实现linux的ssh无密码验证配置 (1)配置理由和原理 Hadoop需要使用SSH协议,namenode将使用SSH协议启动namenode和datanode进程,(datanode向namenode传递心跳信息可能也是使用SSH协议,这是我认为的,还没有做深入了解)。大概意思是,namenode 和datanode之间发命令是靠ssh来发的,发命令肯定是在运行的时候发,发的时候肯定不希望发一次就弹出个框说:有一台机器连接我,让他连吗。所以就要求后台namenode和datanode 无障碍的进行通信。 以namenode到datanode为例子:namenode作为客户端,要实现无密码公钥认证,连接到服务端datanode上时,需要在namenode上生成一个密钥对,包括一个公钥和一个私钥,而后将公钥复制到datanode上。当namenode通过ssh连接datanode时,datanode就会生成一个随机数并用namenode的公钥对随机数进行加密,并发送给namenode。namenode收到加密数之后再用私钥进行解密,并将解密数回传给datanode,datanode确认解密数无误之后就允许namenode 进行连接了。这就是一个公钥认证过程,其间不需要用户手工输入密码。重要过程是将客户端namenode公钥复制到datanode上。

相关文档

- Linux操作系统的安装配置(吐血之作)

- Linux下WebLogic 的安装配置及启动

- Linux安装与配置

- LINUX下NFS安装配置

- 4Mlinux安装配置方法

- Linux_服务器安装、配置和管理(一)new

- 4Mlinux安装配置方法

- Linux环境Weblogic超详细安装配置说明

- linux系统安装及软件配置(精)

- 如何安装配置LINUX安装,LINUX,分区,教程

- Linux操作系统安装部署规范

- Linux安装部署规范标准

- Linux安装配置

- linux下mysql安装配置

- linux安装配置常见注意事项

- LINUX开发环境安装和配置

- linux系统安装初始配置命令

- Linux下服务器安装配置超详细讲解

- Linux常用服务的安装与配置

- Linux服务器环境搭建(设置)